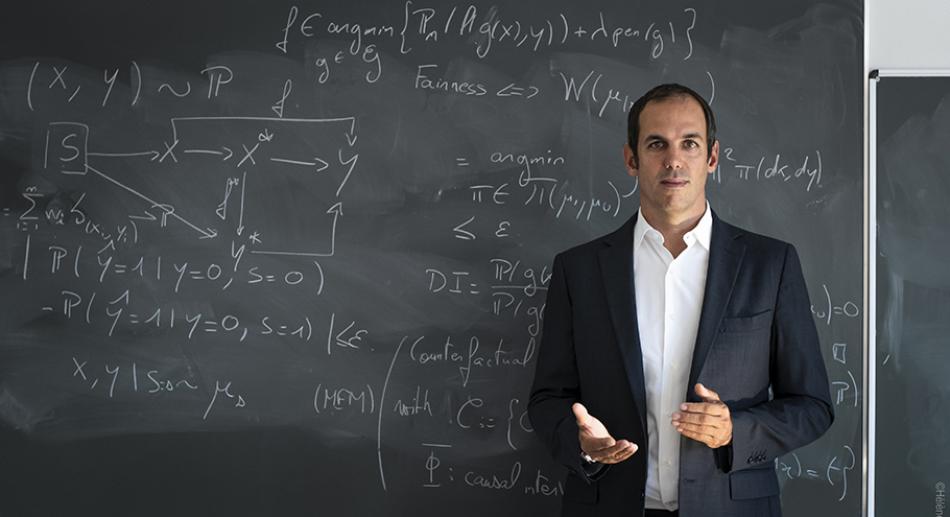

Jean-Michel Loubes : « Les algorithmes pourraient rendre la société plus équitable »

⏱ 4 minJean-Michel Loubes, professeur et vice-président de l’Université Toulouse III-Paul Sabatier, directeur scientifique de l’ANITI (Artificial and Natural Intelligence Toulouse Institute), un des quatre instituts interdisciplinaires français d’intelligence artificielle (3IA), et responsable de la chaire « Fiabilité et robustesse des méthodes d’apprentissage automatique », cherche à comprendre le rôle des biais dans les algorithmes pour proposer des méthodes plus robustes, certifiables et explicables.

Data Analytics Post : Qu’est-ce qu’un biais ?

Jean-Michel Loubes : Un biais désigne une information qui ne devrait pas jouer un rôle dans une prédiction. La notion de biais dépend donc du cadre dans lequel on l’évoque et ses définitions ne sont pas compatibles entre elles. Le biais du législateur est une discrimination contre laquelle il faut lutter comme les biais de genre, de race, de revenus, d’âge, etc. bien connus dans les algorithmes d’apprentissage automatique (ou machine learning) de recrutement ou d’accord de prêts bancaires. Ces algorithmes, fondés sur les données que nous leur fournissons, ne révèlent rien d’autre que nos biais de société. Mais le biais est aussi ce qui permet à ces mêmes algorithmes de prédire car leurs décisions sont basées sur le déséquilibre, la disparité entre les données. Ils apprennent des biais. Si les données n’étaient pas biaisées, parfaitement équilibrées, comme la probabilité de piles et faces d’une pièce de monnaie, l’algorithme ne pourrait tirer aucune conclusion. Le machine learning est basé sur le biais : un algorithme d’apprentissage ne fait rien d’autre que de chercher des différences entre les données pour en tirer des corrélations, soit en reproduisant celles qu’on lui impose (apprentissage supervisé) soit en les trouvant lui-même dans la base de données (apprentissage non supervisé). Il transforme ces corrélations en causalité. Et cela donne d’excellents résultats, par exemple pour détecter des tumeurs cancéreuses grâce aux différences, perceptibles par l’homme ou non, entre cellules saines et malades.

Data Analytics Post : Les biais sont donc capables du meilleur comme du pire ?

Jean-Michel Loubes : Oui ! Comprendre les biais, les définir, les quantifier permet d’améliorer l’équité des algorithmes en les rendant moins discriminants au sens légal, mais aussi d’accroître leur robustesse pour qu’ils restent performants même dans des conditions moins usuelles, comme reconnaître un chat atypique. Et si l’on parvient à comprendre les décisions prises sur la base de biais inconnus, cela pourrait également permettre d’augmenter l’explicabilité des algorithmes. Mais la machinerie même de l’apprentissage, que l’on qualifie souvent de boîte noire quand il s’agit de réseaux de neurones profonds dont les décisions reposent sur l’ajustement de dizaines de milliers de paramètres, n’est par essence pas contrôlable. Ces problèmes sont donc par nature très complexes.

Data Analytics Post : Vos recherches portent sur la détection des biais et leur correction. Où en êtes-vous ?

Jean-Michel Loubes : Les outils que nous avons développés dans le cadre de l’ANITI, avec des chercheurs en droit, en sémantique et en informatique, sont désormais performants pour détecter et contrôler les biais légaux, ceux qui sont clairement identifiés et proscrits dans l’Union européenne, dans la RGPD et plus récemment dans le projet Artificial Intelligence Act, pour tous les algorithmes de finance, d’accès à l’éducation, etc. Dans tous ces domaines, la liste de variables à repérer et quantifier est connue. Nous détectons également les corrélations entre variables qui produisent elles aussi ces mêmes biais. Pour corriger ces biais, nous changeons les règles de comparaison, ce qui permet de faire remonter les minorités dans la décision. Cette forme de discrimination positive a néanmoins un coût en termes de performances des algorithmes.

Data Analytics Post : Qu’en est-il des biais inconnus ?

Jean-Michel Loubes : Nous y travaillons d’une part à l’ANITI, d’autre part en collaboration avec les autres instituts 3IA et dans le cadre du programme national Confiance.ai. Un biais est inconnu soit parce que nous n’avons pas accès aux données comme c’est le cas en France pour les données ethniques, soit parce que la variable est inconnue. Or, découvrir une variable inconnue est particulièrement difficile. Il s’agit d’abord de détecter des anomalies dans le comportement de l’algorithme, à l’instar du fond neigeux qui fait classer des photos de chiens Husky en loups à un algorithme de tri de photos de chiens et loups. Ensuite, il faut être capable d’en tirer une interprétation.

Data Analytics Post : Les algorithmes seront-ils toujours biaisés ?

Jean-Michel Loubes : Très probablement… Les biais sont dans la nature humaine, dans toutes nos décisions. Nous sommes même heureux dans nos biais quand nous refusons les choix proposés par notre moteur de recommandation musicale lorsqu’ils sont hors de notre cible habituelle. En revanche, la machine peut nous protéger des biais légaux même si elle ne sera, à proprement parler, jamais équitable. D’ailleurs l’équité n’est pas une notion juridique mais philosophique, la société n’est pas juste, on est toujours en minorité de quelqu’un ! Et je ne pense pas non plus qu’une machine puisse être morale et juste. On s’est mis à interroger la morale, l’éthique des décisions de la machine et ses biais il y a une dizaine d’années quand on a voulu confier certaines décisions à des algorithmes, en pensant que la vérité était forcément dans la masse de données du big data qu’on était désormais capables d’analyser. La confiance aveugle dans les algorithmes a alors cédé la place à une peur, tout aussi injustifiée, du grand remplacement de l’homme par des machines. Il faut remettre l’algorithme à sa place, celle d’un oracle qu’il faut interpréter et non d’un Dieu numérique qui dit la vérité.

Data Analytics Post : A travers les biais, ce dialogue entre l’homme et la machine suscite donc de nouvelles réflexions…

Jean-Michel Loubes : Oui. On est plus exigeant vis-à-vis des décisions d’une machine que de celles d’un humain. Or, la machine, notamment en exacerbant les biais, révèle des problématiques, nous renvoie sa vision de la société avec ses travers. Ainsi, en cherchant à rendre les machines plus équitables, on devrait pouvoir avoir une nouvelle vision des biais de la société, et en corrigeant l’algorithme, travailler à rendre notre monde plus équitable.

Propos recueillis par Isabelle Bellin

Pour en savoir plus :

Philippe Besse et al. A Survey of Bias in Machine Learning Through the Prism of Statistical Parity, The American statistician, août 2021. org

Céline Castets-Renard et al. Encadrement des risques techniques et juridiques des activités de police prédictive. Ministère de l’Intérieur, 2019. com

Philippe Besse et al. Can Everyday AI be Ethical? Machine Learning Algorithm Fairness, Statistiques et société, 2019. com