L’apprentissage profond permet de lire dans notre cerveau… ce qu’il voit

⏱ 7 minPercer à jour la manière dont notre système nerveux représente et traite l’information est un objectif essentiel des neurosciences. L’apprentissage profond apporte son concours. À partir des signaux issus d’instruments d’imagerie cérébrale, des modèles génératifs sont aujourd’hui capables de reconstruire des images (plus ou moins) proches de ce que voit le cerveau exploré.

Les réseaux de neurones artificiels conçus par les chercheurs en intelligence artificielle se nourrissent généralement de textes, de sons, d’images, parfois de données plus exotiques d’origines diverses (accélérateurs de particules, sismographes…). Quelques-uns écoutent des signaux issus d’instruments capables d’ausculter ce que nous considérons comme l’objet le plus complexe de l’univers, cette boîte encore si noire à nos yeux mais dont nous sommes si fiers : notre cerveau. Électroencéphalographie (EEG), imagerie par résonance magnétique fonctionnelle (IRMf), magnétoencéphalographie (MEG), sans oublier l’approche invasive des électrodes implantées… nous permettent aujourd’hui de capturer des signaux qui nous renseignent de mieux en mieux – mais encore si peu – sur ce qui se passe dans cet organe. Pour quoi faire ? D’abord et avant tout, pour comprendre. Mais aussi parce que ces recherches peuvent déboucher sur le développement d’interfaces cerveau-machine susceptibles d’apporter une aide à des personnes affectées par de graves dysfonctionnements de leur système nerveux : paralysie, syndrome d’enfermement (locked-in syndrome), coma…

Des équipes ont déjà publié, voire expérimenté des solutions reposant à des degrés divers sur l’apprentissage profond pour permettre à un patient de contrôler un fauteuil roulant, une prothèse ou même un exosquelette, de produire du texte (brain-to-text) ou de la parole (brain-to-speech) directement à partir de l’activité cérébrale. Aussi importants que soient ces premiers résultats, ils sont dépassés, sous l’angle du spectaculaire, par des travaux qui visent à interpréter l’activité cérébrale d’une personne pour reconstruire l’image de ce qu’il voit. Deux équipes de chercheurs français ont récemment publié des résultats impressionnants dans cette optique.

« Pirater DALL-E »

Rufin VanRullen est co-responsable de l’équipe NeuroAI au CerCo (Centre de Recherche Cerveau et Cognition) de Toulouse et titulaire de la chaire Deep Learning with Semantic, Cognitive and Biological Constraints du 3IA (Institut interdisciplinaire d’intelligence artificielle) Aniti (Artificial and Natural Intelligence Toulouse Institute). En septembre dernier, il a cosigné¹ dans Nature Scientific Reports les résultats étonnants de travaux visant à reconstruire des images présentées à un volontaire à partir des signaux obtenus en IRMf. « L’aspect le plus spectaculaire, la génération d’image, repose sur les mêmes principes que ceux qui sont mis en œuvre par les DALL-E, Midjourney ou Stable Diffusion, ces modèles génératifs disponibles en ligne qui produisent des images à partir d’une description textuelle, explique le chercheur. Ces outils entraînés sur des millions d’images réalisent l’opération inverse (texte vers image) de ce que certains modèles de vision artificielle font depuis longtemps, à savoir légender (image vers texte) une image. En quelque sorte, il s’agit de pirater un DALL-E de manière à remplacer le “prompt”, la description textuelle de l’image attendue, par une représentation de l’activité cérébrale du volontaire. »

C’est ce que fait le modèle “Brain-Diffuser” conçu par Rufin VanRullen et son équipe. « Dans les modèles qui génèrent des images, le texte initial est représenté par un vecteur de grande dimension, dans un espace “latent” à 768 dimensions dans notre cas, explique le chercheur. Pour produire des images à partir des signaux cérébraux, il faut donc réaliser un modèle capable d’apprendre à les traduire en vecteurs dans cet espace. Nous avons de plus en plus l’impression que ce type de représentation est proche de ce qui se passe dans le cerveau. De nombreux commentateurs insistent sur les différences. Bien sûr on peut voir le verre à moitié vide ou le verre à moitié plein… »

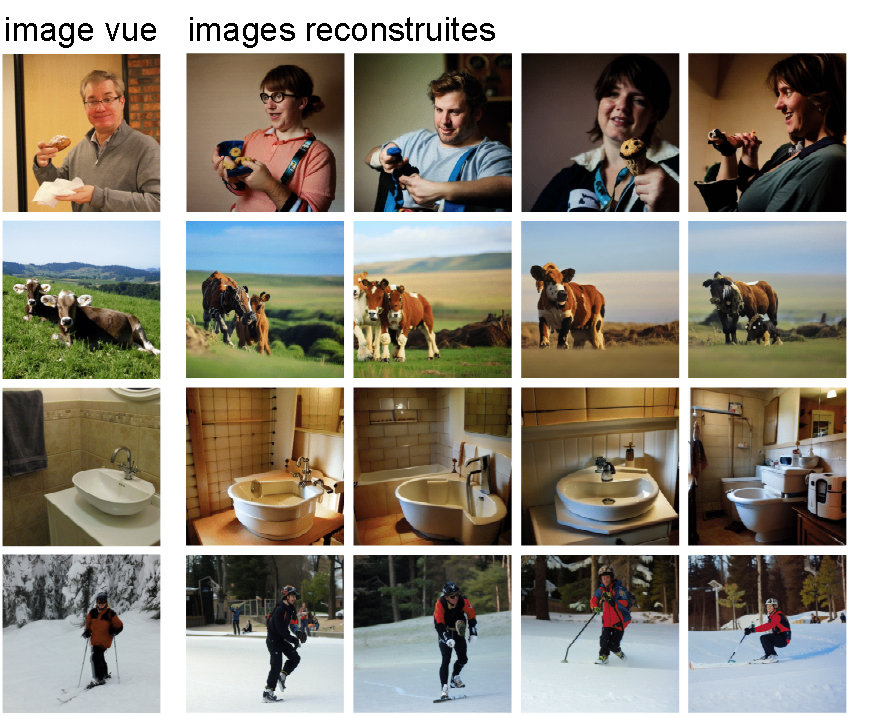

L’équipe a utilisé comme matière première le corpus d’enregistrements obtenus sur un équipement d’IRM fonctionnelle à haute résolution (7 Tesla) par une équipe de chercheurs de l’université de Minneapolis (Minnesota), qui est disponible en open source sous le nom NSD (“Natural Scenes Dataset”). Pour l’entrainement de son Brain-Diffuser, elle a sélectionné les enregistrements de quatre volontaires ayant vu 8 859 images (jusqu’à trois fois), et 982 images distinctes pour le tester. Il n’existe pas de thermomètre lisible par tout un chacun pour quantifier les performances d’un Brain-Diffuser, mais la publication produit des comparaisons flatteuses, s’appuyant sur diverses métriques, avec les travaux publiés antérieurement. Les exemples avantageux publiés sont impressionnants. Le sujet principal (avion, personne, autoroute, tour, vache, lavabo, skieur, parapentiste…) est souvent bien identifié, tandis que les détails (couleurs, dimensions…) restituent sensiblement l’ambiance de l’image originale.

Sélection d’images reconstruites par l’équipe de Rufin VanRullen. Celles de droite correspondent aux quatre participants.

Résolution spatiale vs résolution temporelle

Le type d’équipement utilisé pour obtenir les enregistrements cérébraux exploités par l’équipe de Rufin VanRullen présente des avantages par rapport à d’autres techniques permettant de sonder un cerveau humain. L’IRMf fournit des données tridimensionnelles et l’usage d’un équipement à haute résolution (7 Tesla), permet de distinguer des petits volumes de taille submillimétrique. En conséquence, l’information récoltée offre une grande résolution spatiale, qui renseigne sur l’activité cérébrale en une centaine de milliers de positions. En revanche, la résolution temporelle de l’IRMf est médiocre, de l’ordre de la seconde. Cela parce qu’elle visualise les variations locales de flux sanguin, qui sont loin de refléter instantanément l’activité des neurones. Par ailleurs, le principe même de l’IRM rend son usage très contraignant et ne laisse aucun espoir de réaliser des expériences sur un volontaire en situation naturelle, encore moins mobile.

D’où l’intérêt pour une autre technique d’exploration cérébrale, la magnétoencéphalographie (MEG). Certes, elle ne permet de « voir » ce qui se passe dans notre tête qu’au travers de quelques centaines de capteurs disposés à la surface du crâne et n’offre donc qu’une modeste résolution spatiale. En revanche, sa résolution temporelle est excellente (de l’ordre de la milliseconde) puisqu’elle mesure une conséquence directe (champ magnétique) de l’activité des neurones. Ce qui permet de s’intéresser aux aspects dynamiques de la vision humaine. Enfin, si l’équipement classique de magnétoencéphalographie est encombrant et impose une position fixe, allongée ou assise, une nouvelle génération de capteurs (magnétomètre à pompage optique) se profile qui permettra des enregistrements via une sorte de bonnet, qui accordera une certaine liberté de mouvement au patient. Bref, après l’IRMf, il y avait d’excellentes raisons d’expérimenter avec la MEG.

C’est précisément ce qui a fait l’objet des travaux publiés² le mois dernier par une équipe de Meta, sous la direction de Jean-Rémi King, un chercheur CNRS de l’École Normale Supérieure actuellement détaché chez Meta AI, où il dirige l’équipe “Brain & AI”. « La communauté scientifique pensait que la magnétoencéphalographie, du fait de sa très basse résolution spatiale, ne fournirait pas des données suffisamment riches pour qu’il soit possible de reconstituer les images observées, explique le chercheur. Pourtant, sa résolution temporelle élevée, en revanche, est un atout, dans la mesure où, pour des applications à la parole ou la vision, la temporalité est importante. » L’équipe a donc développé un modèle d’apprentissage profond complexe, comportant essentiellement trois modules : un “module cérébral”, un “module image” et un “module de génération”.

Des similitudes avec l’image originale

Pour entraîner et tester son modèle, l’équipe de Meta a exploité la base de données open source THINGS-MEG publiée par une équipe pilotée par des chercheurs du Laboratory of Brain and Cognition, dépendant au NIH (National Institutes of Health), à Bethesda (Maryland). Elle comporte des enregistrements MEG obtenus par un équipement à 272 canaux (capteurs) auprès de quatre sujets (deux femmes et deux hommes) pendant qu’ils observaient un total de 22 248 images réparties en 1854 catégories (12 images par catégorie). « Nous avons entraîné notre modèle sur ces 22 248 images avant de le tester sur le jeu de 200 images de catégories différents proposé par THINGS-MEG, mais aussi sur un jeu élargi à 2400 images (12 par catégorie), indique Jean-Rémi King. »

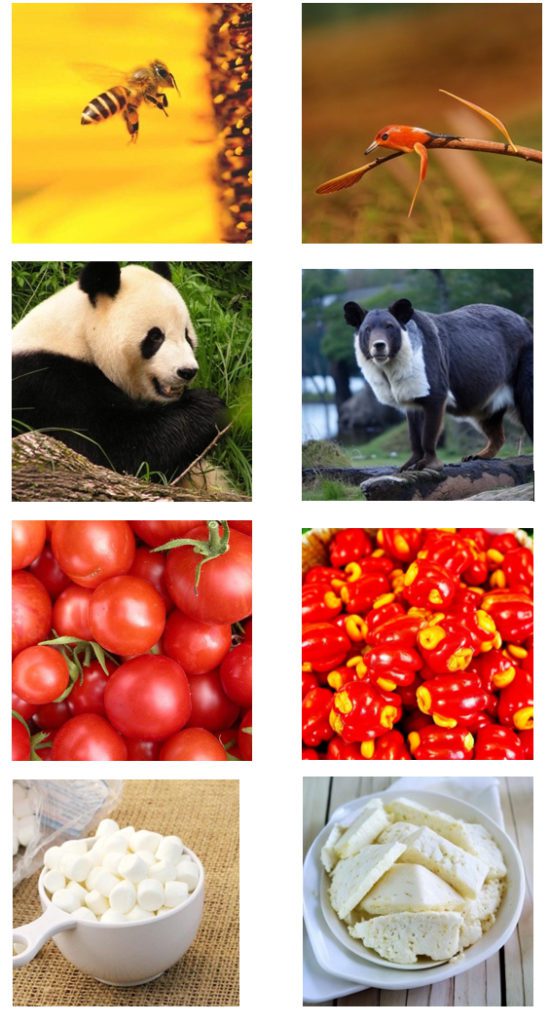

Les images présentées aux participants par l’équipe de THINGS-MEG étaient visibles pendant une demi-seconde, avec un intervalle entre deux images d’une seconde. « On s’est intéressé à cette période de 1,5 seconde globalement, mais d’autre part à des fenêtres coulissantes d’un quart de seconde (250 millisecondes), précise Jean-Rémi King. Et nous avons constaté que nous obtenions de meilleurs résultats avec les périodes de 250 millisecondes situées juste après l’apparition de l’image et juste après sa disparition. » Les images reconstruites par le modèle sont parfois très différentes de celles observées par le participant. Mais on constate souvent une similarité et parfois la ressemblance est troublante. Si les détails de l’image initiale sont généralement perdus, la catégorie à laquelle appartient l’objet ou la scène de l’image initiale se retrouve dans l’image reconstruite. Elle nous montre en substance ce qui a été vu : des brocolis, une enceinte acoustique…

Sélection d’images reconstruites par l’équipe de Jean-Rémi King. L’original est à gauche.

Jean-Rémi King se demandait si la magnétoencéphalographie, malgré sa faible résolution spatiale, allait offrir assez d’information pour que son réseau de neurones puisse apprendre à y discerner une représentation de ce qui est observé par un cerveau, il obtient une réponse positive. « Il y a une longue lignée de recherches sur le décodage de l’activité cérébrale. Avec le temps, on découvre progressivement qu’il y a une proximité, une similitude entre la façon dont nos réseaux de neurones artificiels apprennent et ce qui se passe dans notre cerveau, assure-t-il. » Avec ce type de travaux, l’objectif premier du chercheur est de faire progresser la compréhension du fonctionnement du système nerveux. Mais il ne néglige pas la possibilité qu’ils puissent déboucher sur des applications. « À terme, estime le chercheur, un dispositif inspiré de notre approche pourrait rendre service en médecine, pour venir en aide à des patients souffrant de certaines conditions qui les ont coupés du monde, comme des paralysies extrêmes, le syndrome d’enfermement (locked-in syndrome), ou même le coma. Il permettrait de répondre à des questions comme : est-ce que le patient comprend ce qu’il voit ? Et pourrait aider au diagnostic, au pronostic, voire jouer un rôle pour la réhabilitation du patient. »

Pierre Vandeginste

1. Furkan Ozcelik, Rufin VanRullen. Natural scene reconstruction from fMRI signals using generative latent diffusion. Nature Scientific Reports 13, 2023. doi.org

2. Yohann Benchetrit, Hubert Banville, Jean-Rémi King. Brain decoding: toward real-time reconstruction of visual perception. doi.org