Ces réseaux de neurones rajeunissent photos et films du temps jadis

⏱ 5 minL’apprentissage profond permet désormais de rafraîchir et même revisiter nos vieux clichés et films. Des publications récentes proposent des outils étonnants capables d’éliminer le grain et les rayures de vieilles pellicules, d’accroître leur résolution et de leur inventer des couleurs.

L’informatique n’a pas attendu l’IA pour proposer des outils permettant de donner un coup de jeune à de vieux clichés. Les premiers soins administrés à des photos fanées relevaient hier du traitement du signal. Et des algorithmes plus sophistiqués ont ensuite cherché à effacer des injures du temps plus sévères. Mais c’est l’apprentissage profond qui permet désormais de réaliser dans ce domaine de véritables prouesses.

Rajeunir des photos anciennes peut s’entendre de deux façons. On distingue la restauration, qui cherche à restituer l’état initial du cliché, c’est-à-dire à effacer autant que possible les effets du temps qui passe (jaunissement, craquelures…) et des petits accidents (tâches, rayures…) sur les photographies argentiques ou leurs négatifs. Mais on peut aussi espérer aller au-delà de l’information initialement contenue dans le cliché du passé, l’enrichir pour obtenir une photo plus contemporaine, affichant par exemple une résolution artificiellement augmentée. Ou des couleurs, quand l’original était en noir et blanc.

La « magie » de la colorisation

C’est l’auteur de science-fiction Arthur C. Clark qui aurait dit : « Toute technologie suffisamment avancée est indiscernable de la magie. » C’est l’impression que l’on a en regardant les exemples de colorisations fournis par une publication¹ remarquée en septembre 2016 signée par Richard Zhang et deux autres chercheurs de l’université de Berkeley, en Californie. Bravo : le ciel est bleu et la crête du coq est bien rouge. Mais l’apprentissage profond a ses limites, même lorsque le complexe réseau de neurones conçu par l’équipe a été abreuvé d’un copieux « dataset », en l’occurrence un million d’images issues de bases d’images comme ImageNet et d’autres.

Le réseau de neurones conçu par Richard Zhang et al. donne des couleurs le plus souvent plausibles aux clichés en noir et blanc © Colorful Image Colorization

Les auteurs ne manquent pas d’admettre sur leur site les limites de leur approche. Certes, les citrons sont bien jaunes et les oranges oranges. Mais curieusement, les chiens de toutes races ont une fâcheuse tendance à virer vers le fauve, tandis que les camions, même militaires, se retrouvent trop souvent restitués en jaune ou rouge. Néanmoins, le travail de cette équipe, qui est accessible en open source, impressionne et connaît depuis un certain succès.

Des outils accessibles en open source

Plus récemment, c’est un chercheur indépendant de San Diego, en Californie, Jason Antic, qui a proposé un outil impressionnant, également accessible en open source. La première version de son DeOldify a été rendue publique en septembre 2018. Le chercheur l’a depuis améliorée (notamment en exploitant un total de 14 millions d’images), et s’est même intéressé à la colorisation de vidéos. Ses outils sont exploités ici et là. D’après l’auteur, la meilleure version accessible au public se trouve sur le site MyHeritage.

La meilleure version de l’algorithme de colorisation DeOldify conçu par Jason Antic est accessible à tous sur le site MyHeritage © MyHeritage

C’est d’Asie qu’est encore arrivé, en février 2019, un nouvel outil de colorisation, développé par une équipe d’ingénieurs de GovTech, l’agence gouvernementale pour les technologies de Singapour. Laquelle équipe ne manque pas de « …remercier Richard Zhang et Jason Antic pour leurs travaux de recherche sur la colorisation d’image qui a inspiré [leur] projet. » Elle a conçu un GAN (Generative Adversarial Network, soit réseau adverse génératif) qui a été nourri d’un demi-million d’images issues de bases de données singapouriennes. D’aucuns trouvent qu’il donne à leurs photos noir et blanc des couleurs… locales. Un biais qui n’étonnera guère. De fait, le site colourise.sg où il fut un temps rendu accessible précise qu’il s’agit d’un « Prototype […] destiné spécifiquement aux vieilles photos singapouriennes. » Précision qui a disparu sur le site colourise.com…

Le miracle de la multiplication des pixels

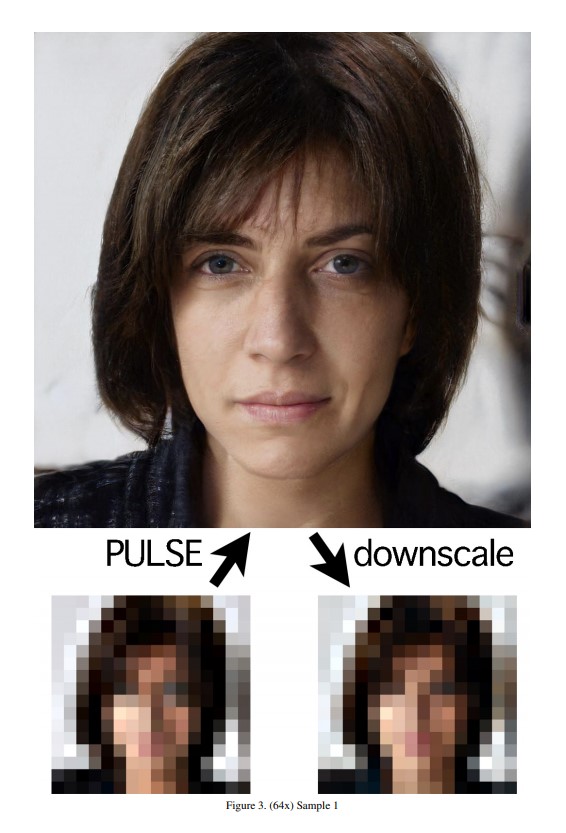

L’apprentissage profond permet donc d’inventer les couleurs plausibles d’une image en noir et blanc, même s’il faut lui pardonner un certain pourcentage de bévues. Il peut accomplir un miracle encore plus impressionnant : multiplier les pixels. C’est-à-dire augmenter notablement la résolution d’images de mauvaise qualité, voire floues. En juin dernier, à la dernière conférence CVPR (Conference on Computer Vision and Pattern Recognition) de l’IEEE (Institute of Electrical and Electronics Engineers), une équipe de l’université Duke (Durham, Caroline du Nord) en a fait une belle démonstration². Sachit Menon et ses collègues ont fait appel à un GAN et à l’apprentissage auto-supervisé. Ils ont appliqué leur approche sur des visages. Les exemples fournis dans leur publication, de portraits initialement pixelisés dont la résolution est accrue d’un facteur 64, laissent sans voix.

L’outil Pulse conçu par des chercheurs de l’université Duke invente des pixels pour augmenter d’un facteur 64 la définition de portraits © Institute of Elecrical and Electronics Engineers

Mais, s’agissant de vieilles photos, la baguette magique que l’on attend tout d’abord est celle qui les débarrassera de tous ces défauts dus à leur grand âge : grain, poussières, rayures et autres signes de fatigue. Dans ce domaine, une contribution³ a été très remarquée au cours de cette version 2020 de la conférence CVPR, qui se tenait, pour les raisons que l’on sait, en mode 100 % virtuel. Une équipe chinoise regroupant notamment des chercheurs de Microsoft Research, à Pékin, et de la City University of Hong Kong a présenté une approche nouvelle et des exemples impressionnants.

Ce logiciel mis au point chez Microsoft Research à Pékin élimine rayures, pliures et autres égratignures sur les vieux clichés © Bringing Old Photos Back to Life

Un film de Louis Lumière « remasterisé »

C’est en s’appuyant sur des outils dans le domaine public que Denis Shiryaev, un entrepreneur russe vivant à Gdansk, en Pologne, s’est amusé un jour à « remasteriser » (en 4 K et 60 fps) un célèbre court métrage daté de 1896, signé Louis Lumière, et intitulé L’Arrivée d’un train en gare de La Ciotat. Posté sur Youtube le 3 février dernier, il a été vu à ce jour 4,4 millions de fois.

Un autre court métrage montrant New York en 1911 affiche 14 millions de vues. Depuis, Denis Shiryaev propose sur son site Neural.love ses services en la matière : des couleurs, des pixels, et même des images par seconde en plus, grâce à un algorithme présenté4 l’année dernière à CVPR par une équipe sino-californienne.

Notes

1. Zhang R., Isola P., Efros A.A. (2016) “Colorful Image Colorization”. In: Leibe B., Matas J., Sebe N., Welling M. (eds) Computer Vision – ECCV 2016. ECCV 2016. Lecture Notes in Computer Science, vol 9907. Springer, Cham. doi.org/10.1007/978-3-319-46487-9_40

2. S. Menon, A. Damian, S. Hu, N. Ravi and C. Rudin, « PULSE: Self-Supervised Photo Upsampling via Latent Space Exploration of Generative Models, » 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle, WA, USA, 2020, pp. 2434-2442, doi.org/10.1109/CVPR42600.2020.00251

3. Bringing Old Photos Back to Life, Ziyu Wan, Bo Zhang, Dongdong Chen, Pan Zhang, Dong Chen, Jing Liao, Fang Wen; Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020, pp. 2747-2757. arxiv.org/pdf/2004.09484.pdf W. Bao, W. Lai, C. Ma, X. Zhang, Z. Gao and M. Yang, « Depth-Aware Video Frame

4. W. Bao, W. Lai, C. Ma, X. Zhang, Z. Gao and M. Yang, « Depth-Aware Video Frame Interpolation, » 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach, CA, USA, 2019, pp. 3698-3707, doi.org/10.1109/CVPR.2019.00382 arxiv.org/pdf/1904.00830.pdf

Image de Une : © Bringing Old Photos Back to Life