Dépister les deepfakes : le jeu du chat et de la souris

De nombreuses équipes de recherches développent des techniques de dépistage de vidéos falsifiées. Avec des résultats plus ou moins convaincants. Elles doivent aussi sans cesse s’adapter aux améliorations des concepteurs de deepfakes.

On est désormais bien loin des premiers deepfakes, ces vidéos dans lesquelles les yeux ne clignaient pas, les bouches étaient vides ou les moustaches éphémères… Il y a néanmoins encore un certain nombre d’imperfections détectables comme les alignements des dents, les oreilles, le regard ou les branches de lunettes. Mais cela évolue très vite ! De même, si certaines méthodes sont capables de détecter la supercherie en quelques secondes, la propagation d’une vidéo est, elle aussi, très rapide. La détection des deepfakes est une véritable course poursuite à tous points de vue !

Images extraites d’une vidéo du corpus FaceForensics :

on voit ici clairement les artefacts au niveau de la moustache, qui apparaît et disparaît au cours de la vidéo

L’engouement pour ces recherches ne date que de 2017, suite à la publication des premiers pornfakes (lire le premier article du dossier « Deepfakes : des modèles géométriques aux auto-encodeurs »). « Il y a deux grandes familles de techniques de détection, résume Ewa Kijak, maître de conférences et chercheure à l’Irisa à Rennes : celles qui reposent uniquement sur le contenu de la vidéo et celles qui utilisent la contextualisation, en comparant des éléments de contexte à ceux d’autres vidéos. » Chaque famille a ses avantages et ses inconvénients. A priori, il y a beaucoup plus de recherches actuellement sur l’analyse de contenu à laquelle personne ne se frottait jusque-là, entre autres parce que l’indispensable compression des images lors de la réalisation des vidéos élimine beaucoup d’informations exploitables (rappelons qu’une vidéo n’est rien d’autre qu’une succession d’images). Pourtant, les vidéos falsifiées existent depuis longtemps ; jusque-là, elles étaient assez facilement identifiées en détectant les images manquantes. Avec les deepfakes, c’est une autre histoire !

Beaucoup de solutions à base de réseaux de neurones

« L’analyse de contenu rassemble deux types de méthodes de détection, poursuit Vincent Nozick, maître de conférences à l’université Paris-Est Marne-la-Vallée, chercheur au Laboratoire d’informatique Gaspard-Monge (LIGM), dont l’équipe a été une des premières à détecter un deepfake créé à partir de GAN en 2018 : celles qui cherchent à identifier des traces de traitement de l’image comme des distorsions (warping) ; et celles à base de réseaux de neurones, qui, en comparant des vidéos, tentent de détecter des modifications caractéristiques sans pouvoir formuler en quoi celles-ci consistent. Ces deux méthodes d’analyse de contenu sont en fait liées à deux communautés de chercheurs : les experts en traitement du signal, férus de mathématique et d’abstraction, seuls en lice il y a encore quelques années ; et depuis 4 ou 5 ans, les experts en réseaux de neurones, plutôt informaticiens, spécialistes de puissants algorithmes dont ils ne peuvent en général pas expliquer les résultats. »

Pour l’instant, les solutions à base de réseaux de neurones ont pris le dessus. L’algorithme, d’abord entraîné sur une base de données de vidéos dont certaines sont étiquetées deepfakes, est ensuite capable de détecter des vidéos falsifiées de même nature. « C’est la méthode que nous avions choisie, précise Vincent Nozick. Ce qui était compliqué car, en 2017, il n’y avait que des deepfakes pornos ou de Nicolas Cage ! N’ayant évidemment pas de droits dessus, on a eu beaucoup de mal à diffuser notre base de données d’apprentissage auprès de la communauté scientifique… Aujourd’hui encore, je reçois des demandes tous les 2 ou 3 jours de chercheurs du monde entier pour l’exploiter. Elle n’est pas en ligne mais je la fournis sur simple demande ! » Avec les datasets proposés par Google et bientôt Facebook, les chercheurs ont depuis peu des bases de données d’envergure (voir encadré).

En raison de l’importance de la base de données d’entraînement, le réseau de neurones développé par l’équipe de Vincent Nozick, baptisé MesoNet, est aujourd’hui dépassé. « Il faudrait le réentraîner mais nous sommes passés à autre chose, reconnaît le chercheur. L’originalité de MesoNet est de s’intéresser au niveau mésoscopique, sur des zones de 50 x 50 à 100 x 100 pixels, entre le micro – le pixel – et le macro – la sémantique de l’image (reconnaître un chien, un chat, un visage…). Ce qui nous a permis d’identifier les zones falsifiées, en l’occurrence, les yeux, le nez et la bouche, avec de très bons résultats à l’époque, alors que c’est indétectable à l’œil nu. » De manière générale, les réseaux de neurones sont efficaces, même s’ils ne pointent pas les caractéristiques qu’ils détectent. Mais ce problème d’entraînement sur chaque nouvelle génération de deepfakes restera toujours un de leurs travers. Sachant que ce jeu du chat et de la souris entre concepteurs et détecteurs de deepfakes façon hackeurs et pirates, se joue à une échelle de temps très rapide.

Identifier les signatures numériques

On qualifie certaines solutions d’analyse de contenu de Forensics, un terme bien difficile à traduire, sorte de médecine légale de l’image (pendant des méthodes scientifiques d’investigation de crimes en criminologie). « Nos travaux portent sur la détection des différentes traces numériques laissées par les traitements successifs subis par la vidéo ou l’image (recadrage, compression, etc.), une suite d’opérations mathématiques, résume Tina Nikoukhah, doctorante au CMLA dans l’équipe de Jean-Michel Morel, qui travaille sur ces sujets. Nous cherchons à retrouver l’historique de ces traitements à partir de leurs traces numériques puis on vérifie que notre résultat global sur l’image coïncide avec toutes les sous-parties de l’image. Dans l’équipe, certains travaillent sur le bruit numérique, d’autres sur le démosaïcage (une étape de reconstruction des couleurs des images), d’autres encore sur différentes méthodes de détection de copier/coller [voir illustration, NDLR]. Nous avons des experts sur toute la chaîne de traitement des images et nous développons des techniques automatiques et en temps réel, qui ne nécessitent pas d’interprétation, avec une probabilité de confiance pour chaque détection. » L’équipe publie sur IPOL ses articles en ligne accompagnés d’une démo afin que tout le monde puisse tester ses propres images (exemple).

« Avec ces méthodes, nous avons pu reconstituer l’historique de compression d’images publiées sur les réseaux sociaux (mais c’est inefficace si les images sont falsifiées avant d’être compressées), détecter un copier/coller ou un recadrage », complète la doctorante qui s’intéresse désormais aux corrections d’aberrations chromatiques (qui produisent des traces colorées sur les bords des objets). L’enjeu de ces recherches est de cibler les traces les plus significatives.

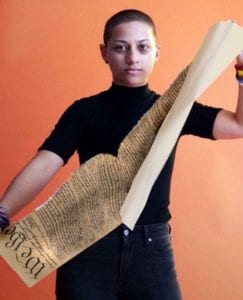

Un exemple de méthode de détection de copier/coller (zone bleue) sur une fausse image qui a circulé sur Twitter. On y voit Emma Gonzalez, figure des opposants à la vente libre des armes à feu aux États-Unis, déchirant la Constitution américaine (sur laquelle s’appuient les partisans de la vente d’armes). Sur l’image originale, c’était une cible de tir qu’elle déchirait. © CMLA

S’appuyer sur la cohérence du discours

Quid des méthodes basées sur la contextualisation ? « Nous y travaillons depuis quelques mois, indique Ewa Kijak, qui précise qu’elle a identifié quelques équipes américaines sur le sujet. D’une part, nous adaptons des méthodes de fouilles de base de données pour retrouver les vidéos similaires sur le web. D’autre part, sur un corpus de vidéos de Barack Obama que nous constituons, nous testerons des méthodes d’extraction d’information, de modélisation et de comparaison. Nous nous intéressons au masque labial mais aussi au profil linguistique (dictionnaire, sémantique, prosodieEnsemble de traits oraux d’une personne : rythme, inflexion, ton, tonalité, intonation, accent, modulation… ) ou aux subtiles expressions du visage ou du corps associées à la prononciation. Si nous parvenons à nos fins, une telle solution serait sûrement plus robuste aux progrès des deepfakes que l’analyse de contenus. Mais elle ne sera utile que pour des personnes connues, dont il existe beaucoup de vidéos en ligne. » Sans compter qu’il faudra savoir détecter les vrais faux deepfakes, vue l’incohérence des discours de certains hommes politiques qui se contredisent eux-mêmes au fil du temps…

Isabelle Bellin