L’IA décode les signaux des cétacés

⏱ 5 minEn s’appuyant sur les technologies de reconnaissance de la parole humaine, plusieurs équipes de recherche tentent de décrypter le langage des cétacés. En attendant, l’IA fait déjà ses preuves pour analyser leurs déplacements et leur comportement.

Comprendre les échanges entre ces grands mammifères marins que sont les cachalots, dauphins, baleines, rorquals… est un rêve de longue date. L’IA et ses puissants algorithmes ont ouvert une nouvelle ère dans l’analyse des signaux sonores sous-marins captés à proximité de ces mammifères marins. Les cétacés produisent une grande variété de sons impulsifs. Notamment des « clics » isolés ou en rafales, souvent organisés en séquences que l’on appelle « codas ». On distingue par ailleurs les « clangs », plus métalliques et très puissants, émis sur un rythme lent par les grands mâles. Et il y a encore des sifflements, des cris (des sons continus modulés en fréquence), des chants (des partitions complexes jouant sur une large bande de fréquence) et même des infrasons (à très basse fréquence). Une production acoustique complexe qui se mélange à une quantité de bruits anthropiques provenant de bateaux, d’activités portuaires et maritimes.

Les codas seraient spécifiques à chaque espèce de cétacés, avec des variations selon la zone du globe, comme des dialectes : huit clics pour les cachalots dans l’océan Indien, cinq dans les Caraïbes, quatre ou cinq aux Galápagos. « De plus, précise Hervé Glotin, bio-acousticien au laboratoire d’informatique et systèmes de l’université de Toulon, des observations de plus en plus précises des groupes permettent d’explorer des hypothèses sur l’existence d’une communication et d’une signature individuelle comme cela a déjà été montré chez un dauphin, le Tursiops. »

Filtrer l’information bio-acoustique

Où en est-on, sachant que la reconnaissance de la parole humaine, tout comme l’interprétation du discours sont désormais assez bien maîtrisés. « Nous ne sommes pas près de fournir un dictionnaire du langage des cachalots ou des dauphins », regrette Hervé Glotin. Avec son équipe, il cherche entre autres à identifier, sur des enregistrements d’orques au Canada ou de cachalots à l’île Maurice, des indices acoustiques permettant de distinguer espèces, clans, familles, individus, d’interpréter états émotionnels et comportements…

« La première étape, particulièrement difficile dans ce milieu adverse consiste à localiser les sources sonores et identifier les individus, explique le chercheur, responsable de la chaire IA de recherche et d’enseignement en bio-acoustique sous-marine à l’université de Toulon. Après quatre ans d’enregistrement et d’efforts pour attribuer les émissions aux individus, par un plongeur à l’île Maurice, grâce aux photos, vidéos et aux analyses génétiques, on a pu construire l’arbre généalogique d’une quarantaine de cachalots et décrire toutes les relations entre eux. On cherche maintenant à extraire les codas de nos enregistrements pour les associer à chaque individu. C’est un travail de longue haleine, au cours duquel l’IA nous sert comme filtre de l’information, à plusieurs niveaux. D’abord pour extraire les émissions des cétacés du bruit ambiant. Ensuite pour traiter les signaux : identifier des motifs, décomposer les signaux pour détecter leurs traits les plus fins et repérer des sous-ensembles qui peuvent correspondre par exemple à des groupes d’individus. On peut alors annoter ces groupes identifiés puis analyser à nouveau nos enregistrements, cette fois pour entraîner des modèles reposant sur le deep learning à les reconnaître. Le principal verrou scientifique concerne la mise au point de l’outillage mathématique permettant de représenter au mieux ces signaux. Car c’est bien plus subtil que pour la parole humaine ! »

Si certaines étapes utilisent une approche supervisée (avec des exemples annotés), l’apprentissage automatique est également d’un grand intérêt, dans une bonne partie de l’analyse, pour une approche aveugle, sans a priori, par exemple grâce à des auto-encodeurs qui ont l’avantage de pouvoir être entraînés de manière non-supervisée, avec des jeux de données non annotés. De nombreuses équipes étudient le potentiel des réseaux de neurones pour analyser la production acoustique de cétacés, à l’instar du Wild Dolphin Project qui s’intéresse aux dauphins tachetés de l’Atlantique (Stenella frontalis). Ces travaux¹ aboutissent souvent à la conclusion commune que ces méthodes sont efficaces pour détecter ces signaux et les classer. Sans aller beaucoup plus loin pour l’instant.

Analyser le comportement des cétacés

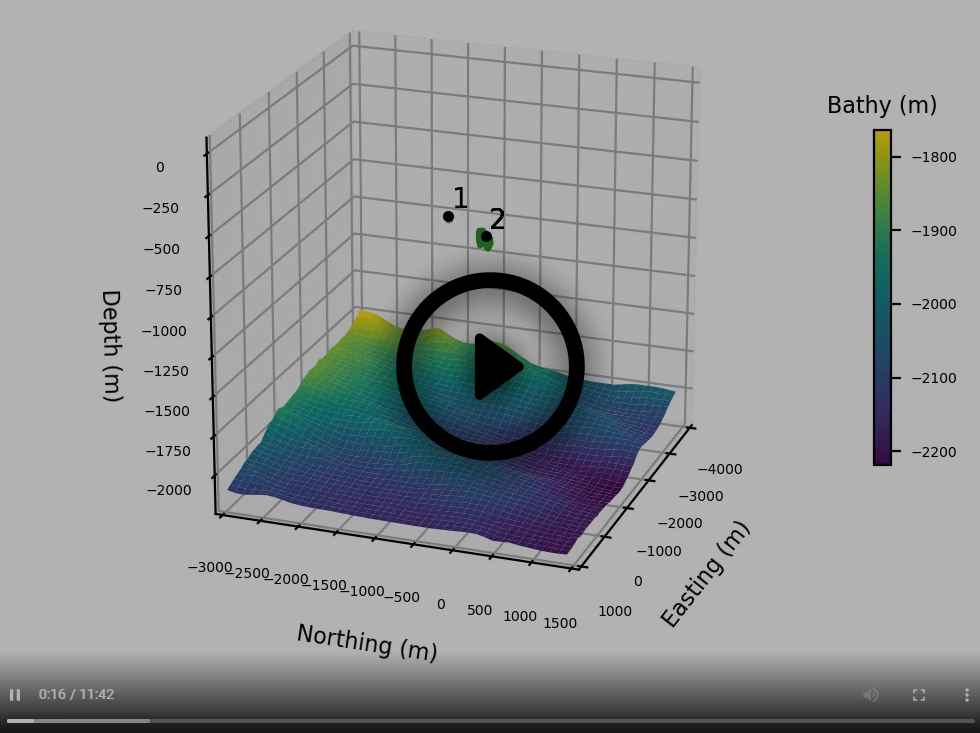

Ces signaux bio-acoustiques contiennent aussi beaucoup d’informations quant aux activités des cétacés. On peut en apprendre beaucoup sur leur comportement, sur leur technique de chasse par exemple. En janvier 2020, l’équipe d’Hervé Glotin a ainsi pu suivre dans le cadre de la mission Sphyrna Odyssey² six cachalots au large de Toulon pendant quelques heures, et montrer que ces grands carnivores s’associent pour chasser, remontant à la surface pour respirer chacun leur tour, avant de replonger à 500 mètres de fond. Grâce à des drones marins de surface équipés d’hydrophones, ils ont pu reconstituer une représentation en 3D de la scène.

Les deux drones Sphyrna. Crédit Rémi Demarthon.

Reconstitution 3D des déplacements des cachalots dans le cadre de la mission Shyrna Odyssey. Crédit : Sphyrna Odyssey.

Cachalot en plongée. Crédit : F. et V. Sarano.

Ces mesures et les analyses ultérieures nécessitent une grande qualité acoustique. Pour cela, l’équipe développe des cartes son de petite taille, très peu énergivores, capables de travailler en temps réel avec une IA embarquée. Elles équipent notamment leurs bouées développées dans le cadre du projet Bombyx, dont les plus récentes comportent cinq hydrophones, ce qui permet de localiser les sources sonores³ par triangulation. Accrochées à une ligne, elles peuvent descendre jusqu’à 1000 mètres et ne remonter à la surface que pour des transmissions d’information via une liaison téléphonique, ce qui les protège des tempêtes.

« Dans le fil de nos recherches sur l’identification et l’analyse des langages des espèces, nous sommes en train de déployer un réseau inédit de ces bouées pour détecter automatiquement la présence des cétacés sur 400 kilomètres de côtes entre Toulon et l’Italie (chaque bouée écoute dans un rayon de 20 kilomètres) et suivre leurs déplacements dans le but de prévenir les autorités en temps-réel pour éviter les collisions avec les navires », précise le chercheur qui déplore que tous les ans une douzaine de ces grands mammifères soient coupés en deux à cause du trafic maritime. À ce rythme, dans vingt ans, il n’y aura plus de cachalots et de rorquals dans la zone. Espérons que ces alertes soient suivies d’effet.

Isabelle Bellin

Image à la une : F. et V. Sarano

1. D. Kohlsdorf, C. Mason, D. Herzing et T. Starner, “Probabilistic extraction and discovery of fundamental units in dolphin whistles », 2014 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2014. https://doi.org/10.1109/ICASSP.2014.6855208

2. Glotin et al., Rapport Scientifique 2019-2020 de la mission Sphyrna Odyssey : découvertes étho-acoustiques de chasses collaboratives de cachalots en abysse & impacts en mer du confinement Covid-19. http://sabiod.univ-tln.fr/pub/SO1.pdf

3. Paul Best et al., Stereo to Five-Channels Bombyx Sonobuoys: From Four Years Cetacean Monitoring to Real-Time Whale-Ship Anti-Collision System. e-Forum Acusticum 2020. ⟨hal-03199965⟩