La reconnaissance des activités

⏱ 5 minLa vision artificielle est aujourd’hui capable d’interpréter avec plus ou moins de bonheur notre visage, nos gestes, voire notre comportement collectif. Le deuxième volet de notre dossier s’intéresse à la reconnaissance d’activités.

Les progrès récents de la vision artificielle permettent aujourd’hui d’observer et d’analyser nos comportements. On parle de « video understanding », de « scene understanding », « event recognition », « behaviour analysis », « activity monitoring »… On pense immédiatement à Big Brother, mais bien d’autres applications, tout à fait louables, sont envisagées. En particulier dans un domaine qui manque cruellement de réponses : le diagnostic, le suivi de patients présentant des déficits cognitifs liés au vieillissement et à l’apparition de maladies neurodégénératives comme la maladie d’Alzheimer, ou encore le maintien à domicile de ces personnes âgées.

C’est dans ce contexte que travaille François Brémond, directeur de recherches à Inria Sophia Antipolis, où il dirige l’équipe projet Inria Stars. Il est par ailleurs membre fondateur de l’équipe CoBTeK (Cognition – Behaviour Technology) de l’université de Nice (Inria et CHU de Nice), où des informaticiens et des psychiatres, neuropsychiatres, psychologues et autres chercheurs en neurosciences s’intéressent aux troubles du comportement chez les personnes âgées.

Des gestes élémentaires aux activités plus longues

« Nous nous intéressons aux activités du quotidien, explique le chercheur. Comme préparer un repas, utiliser un four à micro-ondes, manger, faire la vaisselle, le ménage, mettre ou enlever ses chaussures. Nous ne cherchons pas seulement à reconnaître une activité, mais aussi à détecter des anomalies. Par exemple, constater que le patient a oublié de fermer un robinet, le frigidaire… ou de prendre ses médicaments. Nous considérons plusieurs types d’activités, à plusieurs échelles temporelles. » Cela va des gestes élémentaires, par exemple lever un verre, à des activités composites, plus longues, comme la préparation d’un repas. Certains gestes impliquent une interaction avec un objet, qu’il faut identifier, d’autres non.

« Nous utilisons toutes sortes de capteurs », explique François Brémond. Des cameras couleur ordinaires (dites « RGB » pour « Red, Green, Blue ») à haute définition, des caméras faisant appel à la lumière infrarouge et fournissant une information de profondeur (« RGB+D », « D » pour depth, profondeur), typiquement la Kinect de Microsoft, mais aussi des capteurs plus simples, comme des puces RFID, qui permettent de « marquer » des objets.

Passer de la description à la signification

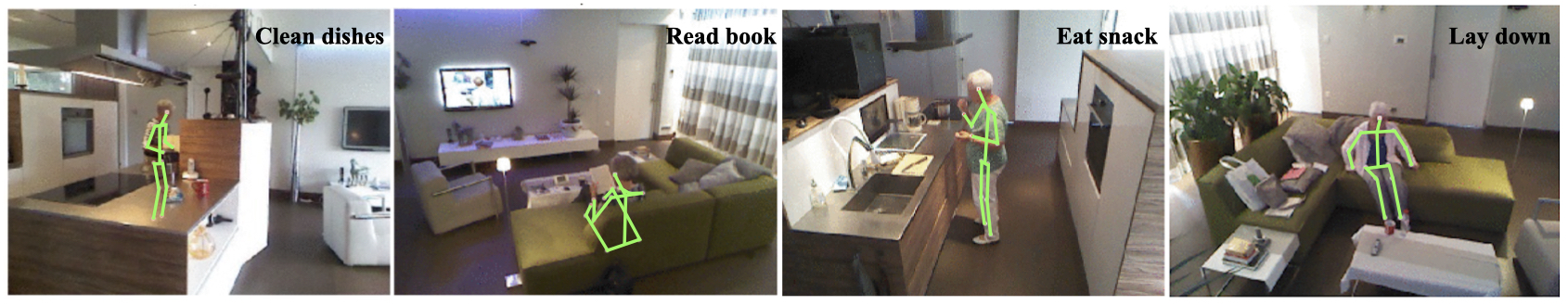

« À partir des pixels issus des caméras ou des nuages de points provenant des détecteurs infrarouge, nos algorithmes produisent un squelette du patient, en 2D ou en 3D, précise le chercheur. Ensuite, ils détectent, classifient, suivent les déplacements et finalement reconnaissent des gestes, des activités. Il s’agit là de passer d’une description à une signification. C’est l’aspect le plus délicat. » On parle du « gap sémantique ».

Une des difficultés rencontrées est la prise en compte du contexte. « Un geste élémentaire n’a pas le même sens selon l’activité dans laquelle il intervient, souligne François Brémond. C’est pourquoi nous nous intéressons pour nos modèles au mécanisme de « l’attention »¹ très en vogue dans le traitement du langage naturel. Par ailleurs, nous traitons des informations de nature chronologique, d’où notre intérêt pour les RNN [réseaux neuronaux récurrents, NDLR], et maintenant les TCN [Temporal Convolutional Neural Networks, NDLR]. Mais nous considérons le temps à différentes échelles : si la préparation d’un repas s’écoule sur une demi-heure, certains gestes essentiels ne durent qu’une seconde ou deux. Nos modèles doivent être capables de se concentrer sur ces épisodes de quelques secondes et les interpréter dans le contexte d’activités qui se déroulent à une échelle temporelle beaucoup plus longue. »

Différents types de réseaux de neurones mis en œuvre

François Brémond et son équipe travaillent avec toutes sortes de réseaux de neurones : « Des CNN (Convolutional Neural Network) tels que les ResNet (Residual Neural Network), ainsi que des RNN, notamment des LSTM (Long Short Term Memory). Récemment, nous avons publié² sur le recours à des SA-TCN (Self-Attention Temporal Convolutional Neural Networks), qui permettent de repérer les moments saillants et de zoomer sur les épisodes importants dans une longue vidéo. »

« Pour obtenir de bons résultats dans ce type de recherche, il est essentiel de bien choisir le jeu de données sur lequel sera entraîné le modèle, rappelle le chercheur. Il existe aujourd’hui des bases de données d’activités classiques, notamment celles inspirées par Google, Facebook ou Tencent. On y trouve typiquement des enregistrements sur YouTube correspondant à des activités comme : répondre au téléphone, conduire, manger, boire, sortir la voiture, serrer une main, embrasser, marcher, courir, s’asseoir, se lever… »

Divers jeux de données, avec leurs qualités et leurs défauts

Par rapport à l’objectif fixé, chacun de ces jeux de données a ses qualités et ses défauts. Le Moments in Time Dataset du MIT est très riche (1 million de clips de 3 secondes), son répertoire d’activité (339 classes) est très large, mais il ne propose que des vidéos RGB très courtes. Pour sa part, le NTU dataset de l’université de technologie de Nanyang (Singapour) propose dans sa seconde version 114 480 vidéos en RGB+D, réparties en 120 classes plus centrées sur la vie quotidienne. Le DAily Home LIfe Activity (DAHLIA) Dataset, publié par le CEA-LIST, a été entièrement réalisé dans une cuisine équipée de trois Kinect. Il propose un jeu certes modeste (51 vidéos de 39 minutes en moyenne, 33 heures au total), mais comprenant un enchaînement de sept d’activités longues annotées (sept classes : faire la cuisine, mettre la table, déjeuner, débarrasser la table, faire la vaisselle…). Comme son nom l’indique, le Breakfast Actions Dataset de la Brown University est très spécialisé (petit-déjeuner). Il propose 2 000 vidéos réparties en dix classes d’actions (préparation de café, thé, jus d’orange, pancakes, sandwich, œufs brouillés…), en RGB seulement, mais filmées dans 18 cuisines différentes.

« Nous avons travaillé avec certains de ces jeux de données, indique François Brémond, notamment DAHLIA et le Breakfast dataset. Mais nous avons choisi de réaliser, en 2019, notre propre dataset³, mieux adapté à nos travaux, en partenariat avec Toyota, qui a disposé d’une « smart home » aux Pays-Bas. Il a été enregistré en RGB+D dans un appartement équipé de sept Kinect, avec 18 volontaires âgés de 60 à 80 ans. Il comprend d’une part un jeu de 16 000 clips d’une minute environ (31 classes) et d’autre part 536 vidéos (51 classes) correspondant à des activités longues, de 20 minutes en moyenne. »

Diagnostic et suivi de l’évolution de maladies neurodégénératives

Les recherches de François Brémond visent notamment à proposer de nouveaux outils de diagnostic et de suivi de l’évolution de maladies neurodégénératives et en particulier la maladie d’Alzheimer. Le déclin cognitif de ces patients a des conséquences lourdes sur leur quotidien. Il est important de détecter le plus tôt possible les premiers signes annonciateurs de difficultés à venir. « Nous testons, par exemple, au CHU de Nice, un dispositif visant à évaluer la situation d’un patient en lui proposant de passer cinq minutes dans une pièce équipée de capteurs, où il doit effectuer une liste de tâches comme préparer une boisson, téléphoner, lire, arroser des plantes… Nos logiciels permettent ainsi d’obtenir automatiquement une évaluation normalisée des éventuels déficits cognitifs de chaque patient. »

À plus long terme, les travaux de François Brémond et de son équipe devraient déboucher sur des solutions susceptibles d’être intégrées dans des appartements ou maisons destinées à accueillir des personnes présentant des déficits cognitifs qui les mettent en danger au quotidien. Parce qu’elles risquent d’oublier leurs médicaments, de ne pas refermer le frigidaire, de tomber… Ce concept d’habitat intelligent, la maison attentive et sécurisée par l’intelligence artificielle, capable de garder un œil sur ses occupants et de donner l’alerte, est dans l’air depuis trente ans au moins. Il oblige les chercheurs à trouver des solutions pour résoudre un problème supplémentaire délicat : comment « veiller » sur une personne sans la « surveiller » ?

Notes

1. R. Dai, S. Das, L. Minciullo, L. Garattoni, G. Francesca et F. Bremond, « PDAN: Pyramid Dilated Attention Network for Action Detection », WACV 2021. ⟨hal-03026308⟩

2. R. Dai, L. Minciullo, L. Garattoni, G. Francesca et F. Bremond, « Self-Attention Temporal Convolutional Network for Long-Term Daily Living Activity Detection », AVSS, 2019. https://doi.org/10.1109/AVSS.2019.8909841

3. S. Das, R. Dai, M. Koperski, L. Minciullo, L. Garattoni, F. Bremond et G. Francesca. « Toyota Smart home: Real-World Activities of Daily Living », ICCV 2019. ⟨hal-02366687⟩

Pierre Vandeginste

Légende image de Une:

Exemples d’activités reconnues à partir de l’estimation des squelettes 3D sur des vidéos issues de la base de données Toyota SmartHome (project.inria.fr/toyotasmarthome). © Inria/Stars & Toyota