La reconnaissance des expressions faciales

⏱ 6 minLa vision artificielle est aujourd’hui capable d’interpréter avec plus ou moins de bonheur notre visage, nos gestes, voire notre comportement collectif. Le premier volet de notre dossier s’intéresse aux expressions faciales.

Le visage humain comporte 43 muscles. Pas étonnant que le langage du visage soit d’une richesse étonnante. Il véhicule des émotions, mais pas seulement ni toujours. Les premiers algorithmes de reconnaissance d’expressions faciales ont été publiés dans les années 1990, mais l’irruption de l’apprentissage profond a donné un coup de fouet à ce domaine. Résultat : de nos jours, un smartphone peut détecter les visages souriants. Pourtant de nombreuses pistes de recherches sont encore ouvertes.

99 % de fiabilité, en situation contrôlée

« Aujourd’hui, estime Chaabane Djeraba, professeur à l’université de Lille et chercheur au sein de l’équipe FOX du laboratoire CRIStAL (Centre de recherche en informatique, signal et automatique de Lille), l’état de l’art permet d’obtenir une catégorisation des expressions faciales avec une fiabilité de l’ordre de 99%… mais en situation contrôlée. » C’est-à-dire lorsque les algorithmes sont entraînés et testés avec des images captées sous un éclairage favorable et constant sur des volontaires immobiles face caméra, devant un arrière-plan optimal, etc. « Mais les choses se compliquent sérieusement, poursuit le chercheur, quand on cherche à appliquer nos modèles sur des sujets non coopératifs, dans des situations réelles. « In the wild » (« dans la nature »), comme on dit en anglais. » Autant dire « dans la vraie vie »…

Au cours de la dernière décennie, des travaux ont permis de bien prendre en compte certaines difficultés, comme l’éclairage ou l’arrière-plan. « Mais deux problèmes restent à l’ordre du jour : l’occultation et le mouvement, affirme Chaabane Djeraba. » Problèmes que l’on cherche à résoudre non seulement dans des contextes où l’on ne dispose que d’une image statique, mais désormais surtout lorsque la source est un flux vidéo.

Lire les expressions de personnes masquées

En cette période de pandémie, la question de l’occultation du visage prend un tour particulier. La vision artificielle peut-elle lire des expressions sur un visage portant un masque ? « Quand un visage est masqué, la difficulté s’accroît, bien entendu, mais certaines expressions sont moins difficiles à décoder, explique Ioan-Marius Bilasco, maître de conférences à l’université de Lille et chercheur également au sein de l’équipe FOX du laboratoire CRIStAL. Le sourire, par exemple, ne peut plus être détecté au niveau des coins de la bouche, qui sont occultés, mais il se prolonge dans le haut du visage. En revanche, la peur ou la tristesse s’expriment de manière différente, surtout dans le bas du visage et sont donc moins faciles à détecter¹. Notre équipe travaille sur cet aspect particulier de l’occultation, la thèse de Delphine Poux est en cours. »

« Nous nous intéressons également à l’interprétation des expressions faciales sur une tête en mouvement, ajoute Ioan-Marius Bilasco. La difficulté essentielle est de différencier les pixels qui « bougent » à cause d’une rotation de la tête ou du fait d’un sourire esquissé², par exemple. » Il faut distinguer le mouvement du visage des mouvements dans le visage. « Après avoir travaillé sur l’occultation et le mouvement, l’objectif final consiste à interpréter des visages qui sont plus ou moins occultés ET en mouvement, poursuit le chercheur. »

Évaluer les réactions des usagers d’un site web

« Les applications potentielles de l’interprétation des expressions faciales sont très variées, indique Ioan-Marius Bilasco. Nous avons par exemple appliqué nos méthodes dans le cadre du projet PAPUD, cherchant à évaluer les réactions des usagers d’un site web permettant d’effectuer des démarches administratives. Les acteurs de la télévision et autres fournisseurs de contenus voient dans cette technologie une solution pour améliorer leurs systèmes de recommandation. » Plus généralement, elle promet au monde du marketing un instrument pour qualifier et quantifier la réaction d’un public face à un nouveau produit (voir notre article). « Mais bien d’autres usages potentiels se découvrent, poursuit le chercheur, comme la mesure du stress au travail, de l’intérêt des auditeurs d’une conférence ou de la douleur d’un patient pendant une intervention. »

Le secteur des transports est également demandeur. « Il y a une dizaine d’années, se souvient Chaabane Djeraba, un sujet en vogue était déjà la détection, avec des capteurs à bas coût, de l’assoupissement d’un conducteur. Nous avons à l’époque publié³ sur la détection des clignements – et le déclenchement d’alertes – l’augmentation de leur durée étant un signe annonciateur d’assoupissement, voire d’endormissement. » Le sujet est à nouveau d’actualité, cette fois dans le contexte de la voiture autonome. De nombreuses équipes travaillent désormais sur des solutions permettant à la voiture du futur de garder un œil sur son conducteur (voir notre article sur le sujet). Il est vraisemblable que la vision artificielle permettra à terme de détecter chez un conducteur divers signaux importants dans le contexte de la voiture autonome, comme la fatigue, bien sûr, mais aussi le stress, l’anxiété…

Les psychologues à la rescousse

Nous, les humains, sommes capables de distinguer un grand nombre d’expressions faciales distinctes, et même de lire des émotions multiples sur le visage de nos semblables. Nous savons percevoir par exemple un mélange de surprise et de peur ou un dégoût amusé. Des travaux de psychologie cherchent à classifier ces expressions et d’autres à les analyser en composantes principales. « Les algorithmes de reconnaissance d’expressions faciales travaillent le plus souvent sur un répertoire de sept expressions faciales, explique Ioan-Marius Bilasco. On utilise typiquement les catégories : joie, tristesse, colère, surprise, dégoût, peur… auxquelles s’ajoute l’expression « neutre ». Celle des photos d’identité. Mais on peut en ajouter d’autres dans des contextes spécifiques. »

Une publication récente4 en distingue ainsi seize : l’amusement, la colère, la crainte, la concentration, la confusion, le mépris, le contentement, le désir, la déception, le doute, l’exaltation, l’intérêt, la douleur, la tristesse, la surprise et le triomphe. On retrouve dans cette liste la tristesse, la colère et la surprise de la classification classique à sept cases. Mais si la joie, par exemple, a disparu, on la suppose dispersée entre triomphe, exaltation, désir, amusement, contentement, intérêt… Qui plus est, les chercheurs de l’université de Californie à Berkeley et de Google Research qui signent cet article dans Nature, après avoir soumis à leur réseau de neurones six millions de vidéos provenant de 144 pays, estiment que ces douze expressions sont corrélées à des situations comparables d’une culture à l’autre.

Degré d’implication du sujet

« Des travaux en psychologie des émotions proposent une autre approche, consistant à situer les expressions dans un espace à deux dimensions ou plus, indique Ioan-Marius Bilasco. Typiquement, les deux premières dimensions considérées sont la « valence » et « l’activation » (« arousal » dans la littérature anglo-saxonne). La valence reflète le degré de positivité du sujet, que l’on peut interpréter aussi par le couple plaisir/déplaisir, tandis que le « arousal » correspond à un axe actif/passif et indique un degré d’implication du sujet. »

« Les algorithmes actuels de reconnaissance d’expressions faciales affichent des performances qui s’approchent progressivement de celles des humains, affirme Alexis Lechervy, maître de conférences à l’université de Caen et chercheur dans l’équipe Image du Greyc (Groupe de recherche en informatique, image, automatique et instrumentation de Caen). Mais dans la vraie vie, nous exploitons tous nos sens pour interpréter un visage. L’audition, en particulier, peut véhiculer des indices complémentaires. »

Vers des approches multimodales

« Notre équipe s’intéresse5 aux approches multimodales de la reconnaissance d’émotions, indique Alexis Lechervy. Un doctorant, Valentin Vielzeuf, a soutenu fin 2019 une thèse6 portant entre autres sur la multimodalité, notamment sur une approche audio-vidéo. Il a mis à l’épreuve ses algorithmes en participant par deux fois (2017 et 2018) au challenge “Emotion Recognition in the Wild” (EmotiW) qui propose de détecter des émotions (et de les classer selon sept classes) sur un visage dans des centaines de brèves vidéos extraites de films et de séries de télé-réalité. Il s’agit donc de situations « proches » de la réalité. Les algorithmes de ce jeune chercheur ont été classés troisième dans les deux éditions (sur une trentaine d’équipes participantes). »

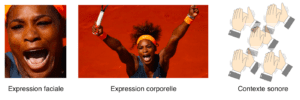

« Il est important de noter que l’émotion ne peut pas se déduire à coup sûr de l’expression faciale, ajoute Alexis Lechervy. La thèse de notre doctorant en donne un exemple parlant : un certain gros plan sur le visage de Serena Williams au moment précis où elle emporte la finale de Roland Garros. Sur ce visage, on peut lire de la tristesse ou de la peur. Mais en prenant du recul, les bras levés de la championne expriment nettement une joie intense. Et les acclamations du public, sur la bande son, vont dans le même sens. »

L’expression faciale de Serena Williams peut aussi bien correspondre à de la joie que de la tristesse ou de la peur, mais son expression corporelle et le contexte sonore (sa voix, les applaudissements) permettent de comprendre que Serena Williams célèbre sa victoire. © Vielzeuf

La reconnaissance des expressions faciales promet le développement d’applications très diverses, capables d’évaluer notre état émotionnel et d’en tenir compte. Des applications qui pourraient améliorer notre santé, notre sécurité… À condition, bien sûr, de fixer des limites pour qu’elles ne portent pas atteinte à nos libertés.

Notes

1. Delphine Poux, Benjamin Allaert, José Mennesson, Nacim Ihaddadene, Ioan-Marius Bilasco, et al.. Facial Expressions Analysis Under Occlusions Based on Specificities of Facial Motion Propagation. Multimedia Tools and Applications, Springer Verlag, In press. hal-02859856

2. B. Allaert, J. Mennesson, Ioan Marius Bilasco, C. Djeraba. Impact of the face registration techniques on facial expressions recognition. Signal Processing: Image Communication, Elsevier, 2018. doi.org/10.1016/j.image.2017.11.002

3. Taner Danisman, Ioan Marius Bilasco, Chaabane Djeraba, Nacim Ihaddadene. Drowsy Driver Detection System Using Eye Blink Patterns. ICMWI 2010. doi.org/10.1109/ICMWI.2010.5648121

4. Cowen, A.S., Keltner, D., Schroff, F. et al. Sixteen facial expressions occur in similar contexts worldwide. Nature 589, 251–257 (2021). https://doi.org/10.1038/s41586-020-3037-7

5. V.Vielzeuf, C. Kervadec, S. Pateux, A. Lechervy et F. Jurie. An Occam’s Razor View on Learning Audiovisual Emotion Recognition with Small Training Sets, ICMI 18, 2018. https://doi.org/10.1145/3242969.3264980

6. https://tel.archives-ouvertes.fr/tel-02437035/file/sygal_fusion_28417-vielzeuf-valentin.pdf