L’impact énergétique du numérique

Avez-vous une idée de l’impact énergétique des usages numériques ? L’intelligence artificielle (IA) y contribue indéniablement et de plus en plus sans que sa part soit identifiable. Et vu l’ampleur des investissements en IA dans le monde, le sujet mérite d’être posé. C’est ce que nous vous proposons dans ce dossier qui bat en brèche certaines idées reçues. Ce premier article brosse le problème dans ses grandes lignes.

20 à 50 % de la consommation mondiale d’électricité pourrait être due au numérique en 2030, indique Cédric Villani dans son rapport sur l’IA rendu public en mars dernier. « Ces estimations sont très exagérées, ce sont des projections linéaires théoriques heureusement improbables, affirme Frédéric Bordage, consultant en écoconception de services numériques et créateur du site GreenIT.fr. En outre, la consommation énergétique n’est qu’un des impacts écologiques : l’empreinte environnementale du numérique, ce sont avant tout l’épuisement des ressources (métaux, eau douce, ressources fossiles…), les déchets engendrés par les équipements électroniques et les atteintes à la biodiversité. Pour réduire ces impacts environnementaux, il faut d’abord réduire le nombre d’ordinateurs, de tablettes et de smartphones fabriqués ! »

Fabriquer moins d’équipements, les conserver plus longtemps

Ce n’est pas la tendance… Mais retenons que l’énergie consommée pour extraire les matériaux puis fabriquer ces équipements – ce qu’on appelle l’énergie grise – est très largement supérieure à ce que ces appareils consomment ensuite, 5 fois plus pour un smartphone selon l’association négaWatt qui réunit une vingtaine d’experts du domaine de l’énergie. Sachant que ces équipements électroniques sont de plus en plus économes et utilisés de moins en moins longtemps ! D’où l’importance qu’ils soient plus durables, réparables et recyclables.

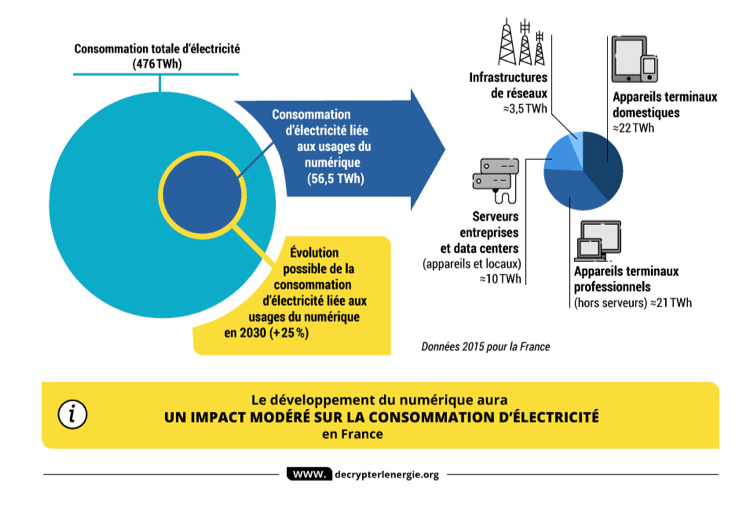

Cela étant dit, comment limiter la consommation électrique du numérique et s’assurer que les développements en IA ne fassent pas exploser la note ? D’abord, comment se répartit cette consommation ? Selon l’analyse détaillée publiée en décembre dernier par négaWatt (dont les résultats sont schématisés ci-dessous), le numérique représente 12 % de la consommation électrique de la France en 2015 (56,5 térawattheure ou TWh).

Ce total étant dû :

– à 76 % (43 TWh) à la consommation des terminaux (à part égale entre particuliers et professionnels) ;

– à 18 % (10 TWh) aux serveurs des entreprises et aux datacenters, ces centres de données avec leurs baies de stockage (une consommation liée à part égale aux appareils et à leur climatisation) ;

– à 6 % (3,5 TWh) aux infrastructures de réseaux.

« Globalement, à ce stade, pour diminuer la consommation, il faudrait tout simplement commencer par éteindre nos box quand on n’en a pas besoin, pointe Frédéric Bordage qui partage l’analyse de négaWatt (à elles seules, les box représentent 1 % de la consommation électrique française, ndlr). Ensuite, c’est le temps passé derrière nos écrans, autrement dit la phase d’utilisation qui impacte le plus : il faut donc mieux concevoir les services numériques, les alléger pour qu’ils soient plus efficaces, plus rapides pour effectuer une même tache, que ce soit réserver un billet de train ou faire tourner une IA, ce qu’on appelle une unité fonctionnelle. »

Bien choisir l’algorithme et les données

L’écoconception d’un service numérique suppose de prendre en compte tous les matériels et logiciels impliqués. Des méthodologies comme l’analyse de cycle de vie (ACV) permettent aux entreprises de mesurer les principaux impacts afin d’identifier les leviers à mettre en œuvre pour les réduire. « Côté logiciel, les développeurs et les chercheurs en informatique doivent prendre du recul, martèle le consultant. L’écriture des lignes de code a très peu d’impact et la plupart du temps, les compilateurs les optimisent ! Il faut avant tout bien penser la conception du logiciel, questionner l’utilité des fonctionnalités, parfois même du service tout entier. » Et pour cause : le poids d’une page web a été multiplié par 3 entre 2010 et 2015, pour le même service, pas plus rapide. « On ne sait plus concevoir des sites web, peste-t-il : on empile des frameworks, c’est de l’assemblage, pas de la conception. »

Pour une IA, c’est la même chose : le choix de l’algorithme compte plus que la façon de le traduire en lignes de codes (voir prochaine newsletter). Le premier levier est de réduire la puissance de calcul nécessaire. Frédéric Bordage rappelle qu’en 2007, IBM a divisé par 100 son nombre de serveurs à Zurich en modifiant l’algo d’affectation des données, autrement dit l’ordonnancement des taches.

Concernant les données, l’enjeu est de transmettre la bonne information et pas plus, autrement dit de savoir de quelles données on a besoin et à quel rythme. « Ces questions métier ne sont souvent pas posées, constate-t-il. Or elles importent plus que le meilleur format de données ou de technique de compression. Cela commence par une bonne terminologie des données. » Cette frugalité est à l’opposé de l’inflation actuelle de données transportées et stockées souvent sans intérêt. 90 % ne serviraient à rien, notamment parce qu’elles sont inexploitables (semi-structurées ou non structurées comme des textes, emails, publications de réseaux sociaux, documents PDF, voix, vidéos, données de tableaux…) ou que leur exploitation nécessite une énorme puissance informatique en comparaison de données structurées.

Datacenters et réseaux

Que dire des datacenters ? Il y en a plus de 4300 dans le monde, 147 en France. Même si les plus voraces ont une puissance installée de plusieurs dizaines de MW (celui de Kolos, en Norvège, atteindrait même 1 GW d’ici 10 ans), il faut garder en tête que ce sont des équipements particulièrement optimisés (voir article « Ce qu’il reste à gagner côté datacenters » de notre dossier).

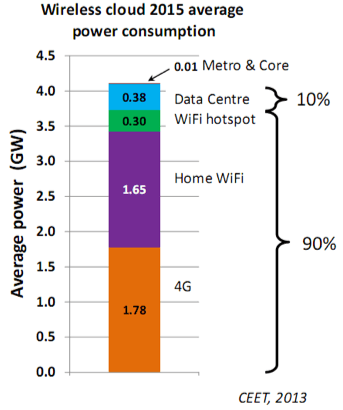

Concernant la consommation liée au réseau, « c’est le dernier kilomètre, ce qu’on appelle la boucle locale, qui représente 90 % de la consommation électrique, rappelle Frédéric Bordage citant la compilation d’études réalisée en 2016 par Kerry Hinton, professeur à l’université de Melbourne (voir ci-dessous). En cause, le réseau 4G jusqu’à nos smartphones et les box ADSL et fibre ainsi que les boîtiers TV associés. » Pour réduire ces consommations, il conseille avant tout de connecter son ordinateur en Ethernet filaire sinon en Wifi, sachant que la 4G consomme 23 fois plus d’énergie qu’une connexion ADSL.

Et demain ?

Selon Cisco, le trafic mondial de données échangées sur Internet pourrait être multiplié par 7 entre 2016 et 2021 (il passerait de 7,2 à 49 exaoctets – milliards de gigaoctets – par mois). La vidéo sur mobile représenterait 78 % de l’ensemble du trafic mobile en 2021. Parmi les impacts à prévoir, les plus difficiles concernent d’une part l’internet des objets (ou IoT, Internet of Things) avec des microconsommations de milliards d’objets connectés dans les systèmes domotiques ou les bâtiments intelligents, d’autre part les cryptomonnaies électroniques, notamment le bitcoin, la plus populaire. Elles font appel à une fonction mathématique de hashUne fonction de hash transforme n’importe quel contenu en un grand nombre hexadécimal de longueur fixe (256 bits, soit 64 caractères pour SHA-256 par exemple) composé de lettres (de « a » à « f ») et de chiffres. Le moindre changement dans la chaine d’entrée provoque un grand changement dans la chaine de sortie et le processus est pratiquement impossible à inverser. pour authentifier et sécuriser les transactions successives dans des blockchains, sortes d’historiques des échanges.

Les bitcoins utilisent Hashcash, un système de preuve de travail conçu par Adam Back. Or, même si le nombre de transactions est minime (parfois plus de 300 000 par jour tout de même), la consommation électrique est considérable (300 kWh par transaction en 2016, plus de 900 kWhselon Alex de Vries, consultant chez PwC : https://www.cell.com/joule/fulltext/S2542-4351(18)30177-6 d’ici fin 2018). Elle serait équivalenteSelon Karl J. O’Dwyer et David Malone de National University of Ireland, Maynooth (NUIM) : http://karlodwyer.com/publications/pdf/bitcoin_KJOD_2014.pdf en 2014 à la consommation électrique de l’Irlande, notamment à cause des validations et synchronisations, toutes les 10 mn, par les « mineurs », les ordinateurs aux nœuds du réseau. Sans compter que ces ordinateurs sont souvent installés en Chine, alimentés par une électricité au charbon. Des procédés de minage moins énergivores sont étudiés, à base de preuve d’enjeu au lieu de preuve de travail comme dans la cryptomonnaie Ethereum.

NégaWatt prévoit une augmentation de la consommation annuelle d’électricité de l’ordre de 25 % d’ici à 2030 (voir 1erschéma). Dans le même temps, l’association prévoit, avec prudence, que les technologies numériques pourraient générer des économies trois fois plus importantes dans les transports (optimisation du trafic, autopartage), grâce à la dématérialisation (télétravail, visioconférence, e-commerce), aux réseaux électriques intelligents (smart grids), aux bâtiments intelligents… De la même façon, les IA peuvent réduire certaines consommations énergétiques. Pour peu qu’on soit attentifs aux effets rebond, ces modifications de comportement concomitantes de toute optimisation qui peuvent finalement conduire à l’effet inverse à l’image de la construction d’une nouvelle route qui entraîne une augmentation du trafic ou des bénéfices du télétravail, largement inférieurs à ceux escomptés.

Google entend donner l’exemple. En 2014, grâce à une IA à base de réseaux de neurones, sa filiale DeepMind a amélioré de 15 % l’efficacité énergétique de ses datacenters. Et selon le Financial Times, Google envisagerait d’utiliser ce même savoir-faire pour réduire la facture énergétique à l’échelle d’un pays, le Royaume-Uni.

Isabelle Bellin

Pour en savoir plus

« Pour une société numérique » : Le nouveau rapport du Shift sur l’impact environnement du numérique

L’équipe a donc proposé de développer une plateforme Openscience, baptisée Green AI, pour capitaliser l’expertise des chercheurs et des industriels en matière d’IA et de partager ces connaissances pour que chacun soit en mesure de trouver la solution la plus éco-efficace.

L’équipe a donc proposé de développer une plateforme Openscience, baptisée Green AI, pour capitaliser l’expertise des chercheurs et des industriels en matière d’IA et de partager ces connaissances pour que chacun soit en mesure de trouver la solution la plus éco-efficace.