Normes européennes sur l’IA de confiance :

l’Afnor organise la concertation en France

⏱ 5 minLa publication de normes européennes sur l’IA de confiance est prévue pour 2025. La Commission requiert l’avis des organismes européens de normalisation. L’Afnor, qui porte la voix française, organise et pilote des échanges pour informer les acteurs concernés et recueillir leurs points de vue. Lancée le 21 octobre dernier, cette démarche participative est unique en Europe. Entretien avec Louis Morilhat, chargé de mission sur l’IA à l’Afnor.

Pourriez-vous tout d’abord nous rappeler le contexte ?

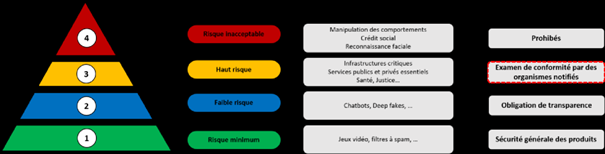

La Commission Européenne a présenté en avril 2021 un projet de directive encadrant l’emploi de l’intelligence artificielle. Les notions de confiance et d’analyse de risques y sont centrales. Ce futur règlement européen (IA Act) classe les systèmes d’IA selon quatre niveaux de risque (voir schéma ci-dessous) : « risque inacceptable » (niveau 4, de tels systèmes seront prohibés), « risque minimum » ou « faible risque » (niveaux 1 et 2, systèmes soumis à un code de conduite), enfin « haut risque » (niveau 3, systèmes soumis à des exigences réglementaires via un examen de conformité par des organismes notifiés). C’est pour cette dernière catégorie de systèmes, qui inclut une grande partie des applications industrielles, que des normes harmonisées sont en cours de préparation.

Par définition, de telles normes, bien que volontaires, prouvent que les produits ou services respectent les prescriptions techniques de la législation correspondante. A ce titre, il est essentiel que les entreprises s’impliquent dans leur rédaction afin de positionner leur technologie sur le marché. Ces normes ouvriront par ailleurs la voie à une certification qui pourrait être la première au monde et s’exporter à l’instar d’autres marquages CE. Thierry Breton, commissaire européen chargé notamment du numérique, a également évoqué un marquage CE « IA digne de confiance ».

Qu’entend-t-on par IA de confiance ?

La confiance est un concept abstrait. Tout le travail de normalisation consiste à le traduire en caractéristiques vérifiables, et pour certaines certifiables, alors même que les notions pointées par la Commission européenne sont difficiles à définir, comme l’explicabilité, l’interprétabilité, la transparence, la robustesse, la supervision, l’auditabilité, la souveraineté, l’équité ou encore la responsabilité. Par ailleurs, plusieurs de ces notions sont imbriquées. À titre d’exemple, l’explicabilité est un aspect intrinsèque de la sécurité mais aussi de l’équité, qui implique la non-discrimination. Chacune des caractéristiques retenues devra faire l’objet d’une définition, d’une description du concept, des exigences techniques et des métriques et contrôles associés.

Pourquoi créer une plateforme de normalisation de l’IA ?

Commençons par rappeler que comme tout processus de normalisation européenne, ces futures normes reposent sur des consensus entre experts, d’abord aux échelles nationales puis européennes [les trois organismes européens de normalisation concernés sont le CEN, le CENELEC et l’ETSI1]. En France, nous sommes l’organisme chargé d’établir ce consensus, en Allemagne, c’est le DIN, etc. Bon nombre d’acteurs français, notamment des startups peu familières de ces démarches de normalisation, anticipent les nombreux enjeux en question et aimeraient mieux les comprendre. Avec cette plateforme, gratuite, notre objectif est de réunir et d’animer cette communauté d’acteurs intéressés. Cela pour les sensibiliser aux enjeux de la normalisation de l’IA, aux travaux en cours, mais aussi pour stimuler les réflexions sur le sujet afin d’identifier avec eux les éléments stratégiques voire mettre en lumière des « angles morts ». In fine, cela nous permettra, d’ici un an, de produire des recommandations, voire, le cas échéant, de proposer de nouvelles pistes de normalisation en tenant compte de la position d’entreprises françaises les plus diverses possible. Aujourd’hui, environ 80 entreprises se sont manifestées pour participer à cette plateforme. Nous l’avons imaginée avec le Hub France IA qui fédère les acteurs français du secteur et France Digital qui réunit les startups européennes du numérique.

Comment fonctionnera cette plateforme ?

Nous mènerons les réflexions au cours d’ateliers thématiques périodiques très collaboratifs, avec les acteurs intéressés. Parmi tous les ateliers que nous avons proposé à la réunion de lancement le 21 octobre dernier, trois ont été largement plébiscités par la cinquantaine de participants et débuteront dès le mois de novembre 2022. Ils concernent les aspects juridiques de l’IA de confiance, comme la responsabilité et la contractualisation, les aspects environnementaux (« Green IA ») en termes de consommation énergétique des systèmes ou de contribution à des solutions environnementales, et enfin l’évaluation de la conformité via les labels et certifications, aspect qui préoccupe beaucoup les startups. Concrètement, au cours de chaque atelier, nous échangerons sur des cas d’usages, des retours d’expérience, des problématiques pour aboutir à des recommandations stratégiques ou des pistes de solution que nous nous chargerons de transférer à la commission de normalisation de l’Afnor. Par la suite, nous organiserons également des ateliers thématiques, focalisés notamment sur la façon de favoriser l’innovation en veillant à ne pas fermer des marchés aux startups et PME à cause de normes souvent établies par des grandes entreprises, ainsi que sur tout ce qui a trait à l’environnement numérique (la souveraineté, les communs, les smart cities), mais aussi sur le rôle des régions et des territoires, ou encore sur les risques liés à des domaines spécifiques comme les dispositifs médicaux, ou à l’industrie nucléaire.

Comment résumeriez-vous les enjeux pour les entreprises ?

Nous constatons un besoin important d’information et de préparation de la part de tous les acteurs, notamment des startups qui sont globalement moins bien informées que les grands groupes. Notre but est de les aider à anticiper les changements induits par ces normes, de manière à mieux orienter leur innovation et à développer leurs produits en tenant compte de ces évolutions, tout en minimisant les coûts de mise en conformité. Les normes seront une contrainte pour ceux qui n’y seront pas préparés. A l’inverse, ce sera une opportunité pour ceux qui seront prêts, une sorte de guide pour l’innovation : les produits conformes aux principales normes auront un accès grandement facilité au marché européen et probablement mondial. Nous encourageons les entreprises à participer à cette démarche unique en Europe. Et cette plateforme est le dernier maillon de la stratégie que nous avions décrite dans notre feuille de route. Elle vient également en appui du consortium d’industriels, confiance.ai, créé en janvier 2021 pour mettre en place une IA de confiance.

Qu’en attendez-vous à l’Afnor ?

Dans l’objectif d’avoir des réflexions aussi larges que possible, nous veillons à solliciter des profils très diversifiés, comme les acteurs juridiques ou les acteurs académiques, encore peu nombreux. Je le répète, cette plateforme s’adresse avant tout à ceux qui connaissent mal les enjeux de la normalisation. À l’inverse, certaines entreprises comme certains acteurs de la santé ou de l’assurantiel, y participent parce qu’elles connaissent bien ces normes et font preuve d’une vigilance particulière. La plateforme nous permettra également d’identifier des problématiques très spécifiques à un domaine, comme la qualité et la transparence des données dans le contexte contraignant de la RGPD pour le secteur bancaire. Autre exemple : comment déterminer la part d’IA dans un système industriel automatisé, ainsi que la proportion dudit système qui doit être normalisé ? Cette démarche est une première pour l’Afnor.

Propos recueillis par Isabelle Bellin

Pour en savoir plus : Feuille de route stratégique pour la normalisation de l’IA, Afnor, 2022

1. Respectivement Comité européen de normalisation, Comité européen de normalisation électrotechnique et Institut européen des normes de télécommunication.