Tour d’horizon des enjeux éthiques liés aux algorithmes et à l’IA

⏱ 7 minLe 26 mars dernier, lors d’une conférence de la SFDS (Société Française de statistique), Valérie Peugeot, chercheuse chez Orange Labs, membre de la CNIL et présidente de l’association Vecam détaillait les enjeux éthiques du big data et des algorithmes sur la base du récent rapport publié par la CNIL sur le sujet. Compte-rendu de cette intervention.

Une simple recherche sur Google trends sur les termes Big data et intelligence artificielle (AI) ces dix dernières années montre l’évolution sémantique. Attention à ces effets de mode, courants dans le monde de l’innovation, et à la société de promesses qu’ils engendrent, rappelle la chercheuse. Quoi que laissent supposer ces tendances, l’IA ne résout pas tout ! D’autant qu’on tend à y inclure des traitements de mégadonnées par des algorithmes déterministes.

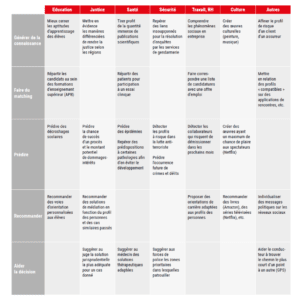

Valérie Peugeot recommande une certaine vigilance, à distance du techno enthousiasme comme du discours anti-IA. Selon elle, les données et les algos ne sont pas la promesse d’une nouvelle gouvernance automatisée comme le prévoit Tim O’Reilly, influenceur digital. Ils n’annoncent pas non plus forcément l’avènement du transhumanisme ou de la singularité technologique, ce point hypothétique de l’évolution technologique au-delà duquel les changements seraient imprévisibles. Ils rendent possible le meilleur comme le pire : prenons l’exemple de l’analyse massive des données médicales, elle permet d’améliorer la pharmacovigilance, d’aider le médecin dans la phase de diagnostic, mais elle crée un risque potentiel de discriminations dans les polices d’assurance. Une chose est sûre : les champs d’application de l’IA sont multiples comme le rappelle ce tableau tiré du rapport de la CNIL.

D’un point de vue éthique, la première question est : jusqu’où sommes-nous prêts à déléguer à la machine nos décisions ? Pour répondre à cette question, distinguons les algos de type déterministes, prévisibles, basés donc sur des règles connues et dont la décision peut être maitrisée, des algos probabilistes de machine learning ou encore les boites noires du deep learning à base de réseaux de neurones, les uns et les autres étant plus ou moins explicables (voir notre article « l’explicabilité des algos : une affaire de compromis »). La chercheuse propose une double grille de lecture (voir figure ci-dessous) : quelle autonomie du système acceptons-nous, autrement dit quel type d’algorithmes ? Et avec quel impact, individuel ou collectif, sur la société ? Selon cette catégorisation, l’amélioration de Google Translation passe par des algorithmes d’apprentissage automatique supervisé avec une certaine autonomie donc : l’algo définit des règles à partir d’exemples qui sont autant de cas validés par des humains. De même, des algorithmes de ce type, utilisés pour l’aide à la décision en matière de justice pourraient permettre de diminuer les inégalités dans les jugements rendus selon les juridictions ce qui est souhaitable, mais peut-être également enlever une marge d’appréciation essentielle au juge. Mais on comprend que l’enjeu est déjà potentiellement bien plus lourd qu’une traduction de mauvaise qualité.

À l’inverse, le repérage de navires en perdition ou en dégazage à partir d’avions 24 heures sur 24, impossible à faire autrement qu’avec des systèmes automatisés à l’échelle des océans, fait appel à des algorithmes d’apprentissage automatique non supervisés : l’algo élabore sa propre spécification en fonction des données brutes. Les risques associés semblent a priori faibles. Cette même famille d’algorithmes pourrait être utilisée dans les hôpitaux pour répartir les malades et fixer les dates d’hospitalisation. Mais quels critères sont acceptables ? La réduction des lits inoccupés ou des maladies nosocomiales, la rentabilité des établissements… Quant à feu l’algo de la plateforme d’orientation des étudiants APB, déterministe, auquel on reprochait à juste titre un manque de transparence, la chercheuse fait remarquer qu’il a été remplacé par ParcourSup, ce qui ne fait que déporter la responsabilité vers les universités qui attribueront les places soit par des équipes enseignantes, ce qui pose à nouveau la question de l’arbitraire ou des passe droits, soit en utilisant leurs propres algos dont pour l’instant on ignore tout autant le fonctionnement. Dans ces deux exemples, on voit à quel point cela peut transformer profondément et la vie des individus et le fonctionnement même de notre système éducatif ou de santé. Enfin, à l’extrémité en termes d’impact collectif, les robots tueurs soulèvent le problème d’algos non supervisés, autonomes, capables de prendre des décisions de vie et de mort sans mettre en danger la vie de celui qui la prend. Une rupture radicale dans l’histoire de la guerre et du rapport de l’humanité à la mort.

Les biais et leurs conséquences

De ces questions en découlent d’autres : qui est responsable en cas de problème ? L’algo est-il une aide ou devient-il un véritable substitut ? Jusqu’où se prive-t-on du débat en déléguant ainsi la décision ? La part d’intervention humaine n’est-elle pas à l’essence même de notre humanité et de la capacité de remise en question comme le met si bien en scène le film Douze hommes en colère dans lequel un seul homme fait basculer tout un jury d’assises ? Il faut éviter une forme de « dilution de la chaine de responsabilités », voire du sentiment même de responsabilité, prévient Valérie Peugeot. À ce titre ne faudrait-il pas mieux interdire certaines applications comme les robots tueurs ? Et s’assurer de l’explicabilité des algorithmes dans des champs comme la médecine personnalisée ? La question s’est posée récemment avec la controverse autour du système Watson d’IBM lorsqu’il est utilisé pour l’aide à la décision médicale. Certains chercheurs lui reprochent son côté « boite noire » alors qu’il serait explicable selon ses concepteurs.

Certains algos sont-ils discriminants ou exclusifs du point de vue social ? De nombreux exemples illustrent ces risques. À ce titre, la chercheuse rappelle que la sélection des données traitées par l’algorithme embarque déjà certains choix. Comme ce biais identifié par Kate Crowford (université de New-York) concernant le recueil par smartphone des données sur l’état des chaussées pour mieux les entretenir, favorisant les propriétaires de smartphones et leurs quartiers. Ou celui concernant Amazon qui avait exclu les quartiers noirs d’un de ses nouveaux services (la livraison gratuite en un jour), son algo ayant jugé qu’ils n’offraient guère de possibilités de profit pour l’entreprise, au vue de l’historique des ventes. Alors que l’intention était guidée par des critères commerciaux, le résultat est une discrimination raciale. Autre exemple : l’algo de justice prédictive Compas (Northpointe) utilisé aux États-Unis pour des décisions de libération conditionnelle défavorise les afro-américains comme l’a montré l’association de journalistes Propublica. Les travaux de la politiste Virginia Eubanks[1] qui s’est penchée sur trois systèmes automatisés développés pour optimiser les programmes sociaux américains montrent à quel point les algorithmes peuvent assigner les pauvres à leur condition.

Par ailleurs le risque est réel que les algorithmes nous enferment dans ce que nous sommes ou nous savons de nous-mêmes, d’un entre-soi jusqu’au risque de manipulation et d’affaiblissement démocratique comme le met en lumière l’affaire Cambridge Analytica à partir des données de Facebook. Le militant d’Internet Eli Pariser qualifie de « bulle de filtres » ce filtrage de l’information et l’état d’ « isolement intellectuel » et culturel qu’il provoque. Dans la sphère politique, cet enfermement crée une atomisation de la société, chacun vivant dans un espace de prêt-à-porter politique au détriment du débat public. Au-delà de la sphère politique, les exemples de dérives sont déjà nombreux : la compagnie d’assurance américaine John Hancock fait varier le prix des primes de ses assurés jusqu’à 15 % en fonction de leur activité et de leur mode de vie tracés grâce au bracelet connecté Fitbit qu’elle leur offre ; sur le modèle « Pay How You Drive », Direct Assurance étudie l’adaptation du tarif des primes en fonction de la conduite automobile de l’assuré grâce à un boîtier intelligent, connecté à une application mobile (YouDriveLite).

Des réponses juridiques et éthiques

Que dit la loi face à ces biais ? La loi française Informatiques et libertés de 1978 modifiée par le règlement général européen pour la protection des données personnelles (RGPD) qui entre en application en mai 2018 (voir notre article « données personnelles : qui a accès à quoi ? #entreprises ») comporte notamment 3 articles censés garantir l’usage des données à des fins qui ne nuisent pas au citoyen, l’interdiction Aucune décision produisant des effets juridiques à l’égard d’une personne ne peut être prise sur le seul fondement d’un traitement automatisé de données destiné à définir le profil de l’intéressé ou à évaluer certains aspects de sa personnalité de décision sur le seul fondement d’un algorithme et le droit à une explicationLes informations permettant de connaître et de contester la logique qui sous-tend le traitement automatisé en cas de décision prise sur le fondement de celui-ci et produisant des effets juridiques à l’égard de l’intéressé en cas de décision prise par un algorithme. Mais ces règles pour essentielles qu’elles soient, souffrent de deux faiblesses : elles ne couvrent que les effets individuels, et non les conséquences collectives ; elles n’encadrent que les données personnelles, c’est-à-dire identifiées ou identifiables, et pas les données anonymisées et agrégées.

Face à cela, la CNIL, au terme d’un processus de consultation de 9 mois à travers la France, a dressé une première série de principes fondamentaux et de pistes de réponses. Le principe de loyauté, consiste à affirmer que les responsables des algorithmes doivent veiller en permanence à assurer de bonne foi le service de classement ou de référencement, sans chercher à l’altérer ou à le détourner à des fins étrangères à l’intérêt individuel et collectif des utilisateurs. La vigilance collective, de toute la chaine d’acteurs, du concepteur à l’utilisateur constitue un second principe. Ces principes peuvent se traduire concrètement par de premières initiatives :

– Former à l’éthique tous les maillons de la « chaîne algorithmique » : concepteurs, professionnels, citoyens

– Rendre les systèmes algorithmiques compréhensibles en renforçant les droits existants et en organisant la médiation avec les utilisateurs. Plus que de transparence, il s’agit de travailler sur leur intelligibilité, la capacité à en comprendre la logique générale

– Travailler le design des systèmes algorithmiques au service de la liberté humaine

– Constituer une plateforme nationale d’audit des algorithmes

– Encourager la recherche de solutions techniques pour faire de la France le leader de l’IA éthique

– Renforcer la fonction éthique au sein des entreprises.

Des pistes qui demandent à être fouillées, complétées, confrontées à la réalité des innovations technologiques, pour que l’éthique ne soit ni un alibi ni une manière de repousser les questions à plus tard, mais une véritable prise pour construire une société numérique qui participe à la réduction des inégalités et protège nos libertés.

Isabelle Bellin

[1] Automating Inequality https://virginia-eubanks.com/