Gen-Z, le protocole de communication open source qui décuplera les débits de données

⏱ 6 minGen-Z désigne un vaste consortium industriel international, ainsi que la norme hardware de transfert de données sur laquelle il travaille. Sa promesse, décupler en toute sécurité les débits sans consommer davantage d’électricité, et ouvrir la voie à une nouvelle génération de data centers, de réseaux télécoms ou d’objets connectés.

Quel est le point commun entre des voitures autonomes et plus généralement les Smart Cities, un système d’alerte Seveso en cas de pollution chimique, un réseau d’objets connectés ou de capteurs domestiques ? Tous ces exemples ont en commun de nécessiter une multitude de capteurs qui doivent pouvoir échanger beaucoup de données, quasi en continu. Des quantités de données qu’il est désormais possible d’analyser grâce aux outils statistiques actuels notamment au machine learning.

Exigences de rapidité, sécurité, économie

Pour que ces solutions se démocratisent, les équipements ainsi que tout l’écosystème qui les entoure (serveurs, mémoires, réseaux de communication, algorithmes, etc.) doivent être économiques. « Les capteurs doivent coûter quelques centimes d’euros, explique Patrick Demichel, architecte des systèmes stratégiques chez HPE (Hewlett Packard Enterprise). Instrumenter une maison, par exemple pour surveiller une personne fragile (lire le dossier « Quantification de la fragilité »), doit coûter de 10 à 100 euros et non 1 000, comme c’est le cas actuellement. » Ensuite, un tel déploiement de capteurs communicants suppose de bonnes conditions de sécurité. Bien loin de la tendance actuelle. « Car, outre la facilité avec laquelle on peut hacker un assistant personnel, un pacemaker ou un disque dur, la multiplication actuelle d’équipements connectés, de solutions logicielles et d’échanges de données non sécurisés accroît sans cesse les trous de sécurité et les possibilités d’interception, poursuit Patrick Demichel. Ça devient un véritable bric-à-brac ! »

Enfin, et c’est un des points majeurs, il faut pouvoir assurer la rapidité de transmission des informations. Nos réseaux de télécommunication sont-ils à la hauteur pour déployer cette vision d’un monde supervisé ? « Ce sera le cas avec les réseaux radio 5G, partout en cours de déploiement (la France étant très en retard), répond Pierre Navidi, CTO de Kleos, entreprise qu’il a fondée en 2006 et qui fabrique des plateformes 4G et 5G depuis 2014. Le problème, c’est que ces nouveaux réseaux ouvrent la voie à quantité de nouveaux matériels et logiciels qui induisent une consommation énergétique insoutenable. La Chine, qui a lancé le déploiement sur tout son territoire, l’a déjà freiné en raison d’une multiplication par 10, voire 20, de la consommation électrique. Si l’on intègre les objets connectés, les voitures autonomes (petits clusters de processeurs spécialisés), etc. à la 5G, ce sera ingérable dans dix ans. »

Pourquoi ? L’une des raisons principales est l’inaptitude du protocole de communication d’internet, TCP (Transport Control Protocol), qui gère les requêtes entre clients et serveurs et créé les canaux de communication. Protocole dont le premier RFC« Les requests for comments (RFC), littéralement « demande de commentaires », sont une série numérotée de documents officiels décrivant les aspects et spécifications techniques d’Internet, ou de différents matériels informatiques. » https://fr.wikipedia.org/wiki/Request_for_comments (Requests for Comments) est sorti en 1981 (RFC793)¹… À l’origine, il avait été conçu par le Darpa (Defense Advanced Research Projects Agency), pour permettre une résilience des réseaux de communication entre un nombre limité d’hôtes interconnectés avec de faibles débits. Or, depuis l’avènement d’internet il y a plus de vingt-cinq ans et la généralisation des services de toute sorte, le nombre d’hôtes a augmenté de plusieurs ordres de grandeur, mais on continue de bricoler avec ce protocole… alors qu’il en faut un nouveau, adapté à des réseaux à base de fibres optiques et à une infrastructure de réseau télécoms de plus en plus performante.

Gen-Z décuplerait le débit de données

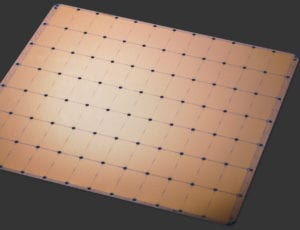

« Gen-Z est la solution idéale pour l’échange des énormes flux de données à venir, tout en assurant très simplement la qualité et la disponibilité, et surtout la sécurité de ces services, reprend Patrick Demichel. Ce protocole de transmission de données est 10 fois plus rapide que le protocole internet actuel. » Retour en arrière : Gen-Z est né d’une initiative de HPE, il y a plus de dix ans. Comme souvent, une rupture technologique naît d’un constat incontournable. En l’occurrence ici, la course à la puissance dans les data centers était face à un mur technologique pour atteindre l’Exascale. Un mur en matière de consommation énergétique, notamment liée au transfert de données : 50 % de l’énergie dépensée par un data center est due au déplacement des données jusqu’à l’unité de calcul. Hewlett Packard Labs a misé sur un nouveau design d’architecture de serveurs : « Il est basé d’une part sur un nouveau type de mémoire, le Memory driven computing (avec des mémoires persistantes qui n’ont pas besoin d’énergie pour conserver leurs données), d’autre part sur une nouvelle sémantique. Celle-ci repose sur un nouveau protocole de communication, sécurisé et particulièrement simple, de type Store/Load (Stoke/Charge), pour échanger les données entre ces éléments de stockage et les éléments de calcul (CPU, GPU, FPGA, Asics…) », explique Patrick Demichel, un des évangélistes de ce concept. Hewlett Packard Labs a mis en œuvre ce design dans un prototype, The Machine, dévoilé en 2016.

C’est à la suite de ces travaux qu’HPE a lancé la création du consortium d’industriels Gen-Z, pour initier ce changement radical de paradigme et promouvoir ce nouveau standard ouvert d’interconnexion de composants, cédant au passage une grosse partie de sa propriété intellectuelle. Les recherches y sont poursuivies depuis mi 2016. Gen-Z réunit aujourd’hui quelques 70 industriels autour des 12 membres fondateurs (AMD, ARM, Broadcom, Cray, Dell EMC, HPE, Huawei, IDT, Micron, Samsung, SK hynix et Xilinx). Tous les grands acteurs du numérique, équipementiers, fabricants de composants ou de logiciels, rejoignent peu à peu le consortium : Cisco Systems, Samsung Semiconductors, Nokia, Microsoft, IBM, Hitachi, Google ou ZTE pour n’en citer que quelques-uns. « Et si Nvidia et Intel n’y sont pas encore, ils devraient travailler sur le sujet », affirme Patrick Demichel. C’est ce qu’on peut lire en filigrane dans le protocole d’entente signé début avril 2020 entre Gen-Z et CXL, la technologie d’interconnexion soutenue par Intel. « Gen-Z est la promesse d’une intercompatibilité totale où chaque composant d’un serveur pourra échanger avec les autres composants au moyen d’une sémantique simple, résume-t-il. Le consortium est ouvert à tous avec des spécifications sur la base desquelles chacun peut développer ses matériels. »

Le temps de déployer un nouveau standard

Pourtant, quatre ans après le lancement du consortium, force est de constater que ce nouveau paradigme peine à prendre corps, comme chaque changement de nouveau standard… « Ces solutions ouvertes, coopératives et partagées bouleversent tout l’écosystème comme l’Open Source en son temps [1997-1998, NDLR], justifie l’architecte systèmes. C’est un énorme saut technologique pour les équipementiers qui doivent installer Gen-Z dans leurs composants. Il faut créer un nouveau modèle économique, avec de nouveaux composants Gen-Z compatibles. Ce n’est pas rien ! Cela dit, ça démarre : les premiers équipements, commercialisés en 2019, sont des mémoires persistantes. AMD a annoncé un processeur Gen-Z. D’autres suivront. Le premier domaine sera assurément celui des data centers, premières architectures concernées. Pour l’instant nous faisons des démonstrations d’interopérabilité entre composants. D’ici trois à cinq ans, cela devrait se déployer dans les télécoms. Quant au déploiement à grande échelle, il viendra d’une application… mais qui sait laquelle ? »

Gen-Z pourrait être la clé de grands systèmes comme les Smart Cities, car cela répond aux exigences en termes de coût, d’énergie et de sécurité. Le concept s’applique tout autant à des réseaux d’objets connectés qui ont besoin de solutions particulièrement optimisées, sinon impossibles à déployer en termes de consommation énergétique et de sécurité. « L’internet des objets (IoT) va générer 100 000 fois plus de données qu’aujourd’hui, qu’il faudrait pouvoir stocker et traiter avec la même quantité d’énergie qu’aujourd’hui, constate Patrick Demichel. Gen-Z permet cela. »

La solution pour déployer des réseaux d’objets connectés

« L’idée serait de multiplier des capteurs (simples et à bas coût car déployés en très grande quantité) incluant des mémoires persistantes et des composants Gen-Z-compatibles, poursuit-il. La fonction de ces capteurs serait seulement de collecter la donnée pour la transmettre par intermittence à un objet plus intelligent de leur environnement proche (un smartphone, une TV, un ordinateur, une montre connectée, un assistant personnel…). Tous ces objets ont un microprocesseur qui dort la plupart du temps, qui pourrait être mis à profit pour faire des petits calculs locaux, ensuite relayés sur des serveurs connectés en filaire. Cela permettrait de rapprocher le calcul des données, sachant que les capteurs consommeraient très peu, car ils ne seraient connectés que lorsqu’ils captent et envoient leurs données, par exemple 1 milliseconde toutes les 10 secondes. »

Cette multitude d’objets connectés de l’IoT échangerait avec le protocole Gen-Z, unique langage de communication : « C’est l’esperanto des machines, déclare Patrick Demichel. Il remplacera les milliers de protocoles actuels ! Et grâce à un mécanisme d’authentification via des clés de cryptage, chaque objet sera identifié, sans ligne de code. Ce qui assurera la sécurité de ces réseaux d’objets connectés. Autre qualité de Gen-Z : la simplification du codage, ce qui est fondamental dans des environnements distribués hétérogènes. Décomplexifier est devenu une nécessité absolue pour créer des systèmes de grande taille sûrs, résilients et peu énergivores. Enfin, la rapidité de transfert de données sera elle aussi accrue, car au fur et à mesure, il y aura de plus en plus d’appareils équipés de composants photoniques, ce qui leur permettra, à leur échelle, de traiter les informations plus rapidement. »

Selon ses concepteurs, les forces de ce concept sont l’universalité de la solution et l’interopérabilité qu’elle permet entre différents matériels. « Cela ouvrira la voie à toutes sortes d’applications qui nécessitent beaucoup de données ainsi qu’au développement d’algorithmes à base de machine learning, prévoit Patrick Demichel. C’est la seule solution pour déployer des réseaux d’objets connectés à bas coût et en toute sécurité. » « C’est aussi un sujet de souveraineté numérique, fait remarquer Pierre Navidi. C’est la meilleure façon de reprendre la main sur nos données à moindre coût. Cette nouvelle révolution technologique sera plus impactante que l’Internet et les données mobiles, promet-il dans un courrier adressé au ministre de l’Économie, Bruno Le Maire. Elle permet de réaliser des infrastructures composables, nativement sécurisées, super efficientes et open source, offrant un champ d’innovations impossible à borner. De quoi créer un monde de milliards d’objets intelligents coopérants. »

1. V. Cerf et R. Kahn, « A Protocol for Packet Network Intercommunication »,IEEE Transactions on Communications,vol. COM-22, No. 5, pp 637-648, May 1974.

Pour en savoir plus

https://www.youtube.com/watch?v=OTsk8B-EnmM

https://genzconsortium.org/wp-content/uploads/2018/05/Gen-Z-Overview.pdf

Isabelle Bellin