La start-up française LightOn accélère l’apprentissage profond… grâce au calcul optique

⏱ 6 minL’intelligence artificielle est un ogre, ses réseaux de neurones exigent toujours plus de puissance de calcul… Les processeurs optiques de LightOn proposent une solution pour accélérer radicalement l’apprentissage profond… en consommant moins d’énergie.

Les applications de l’apprentissage profond, toujours plus ambitieuses, exigent des puissances de calcul qui ne cessent de croître. La facture énergétique s’alourdit, l’empreinte carbone aussi. Pour gagner en efficacité, on a délaissé les ordinateurs classiques pour se tourner vers les processeurs graphiques (GPU), et même des puces plus spécialisées. La start-up française LightOn propose une solution radicale pour gagner à la fois en efficacité et en sobriété, reposant sur l’optique.

« Notre approche repose sur ce que l’on appelle le Multiple Light Scattering (diffusion multiple de la lumière), explique Laurent Daudet, le directeur technique de LightOn. Quand la lumière traverse un milieu translucide, elle subit une cascade de diffusions, qui réalisent instantanément un calcul algébrique puissant que l’on appelle une « projection aléatoire ». Dans nos dispositifs, une image est projetée sur une lame translucide, et un capteur récupère sur l’autre face de cette lame une autre image : le résultat de ce calcul optique. »

Cette projection aléatoire réalise un calcul matriciel particulier. Elle multiplie l’image initiale par une énorme matrice de valeurs aléatoires. Or, ce type de calcul est utile pour réaliser certaines opérations dans le contexte de l’apprentissage profond. Ainsi la rétro-propagation, l’opération fondamentale de l’apprentissage dans un réseau de neurones, peut être remplacée par de nouveaux algorithmes impliquant des projections aléatoires.

Associer les avantages de l’optique et de l’électronique

« L’approche de LightOn consiste à proposer une solution hybride, précise Laurent Daudet, alliant les performances de l’optique à celles des puces électroniques. LightOn développe un coprocesseur optique, une Optical Processing Unit (OPU) ayant vocation à collaborer avec des processeurs classiques (CPU) et graphiques (GPU). »

Dans un réseau de neurones apprenant à classifier, par exemple, des images, les premières couches, où sont détectées des features (caractéristiques visuelles locales des images), sont creuses : chaque neurone n’est connecté qu’à quelques neurones de la couche précédente. L’optique n’y est bien souvent pas plus efficace que les GPU. En revanche, les dernières couches, où s’opère la classification des images, sont denses : chaque neurone y est connecté à tous les neurones de la couche précédente. Elles brassent d’énormes quantités de données. C’est là que l’approche optique fait des miracles.

« Alors que notre premier prototype avait les dimensions d’un smartphone, notre dispositif de deuxième génération ne fait plus que la taille d’une boîte d’allumettes, indique Laurent Daudet. En entrée comme en sortie, les images comportent aujourd’hui 1 million de pixels. Notre premier prototype, Aurora 1.5, traitait 1 500 images par seconde (1,5 kHz), mais le nouveau, Aurora 4.5, fonctionne à 4.5 kHz. »

Deux mille milliards d’opérations par cycle

Selon LightOn, le calcul effectué dans l’OPU Aurora 1.5 reviendrait à multiplier l’image initiale par une matrice comportant 170 milliards de coefficients. C’est l’équivalent de deux mille milliards d’opérations par cycle. À 1,5 kHz, cela représente quelque trois millions de milliards d’opérations par seconde. Pour une consommation de 30 watts. Le ratio puissance sur énergie représenterait un gain de deux à trois ordres de grandeur, par rapport à une puce ad-hoc, comme la TPU de Google.

Dans un premier temps, LightOn permet de tester sa technologie via le cloud (cloud.lighton.ai). Des serveurs réalisés autour de l’OPU Aurora 1.5, comportant aussi une GPU (Nvidia Tesla V100) et une CPU (Intel Xeon Gold) sont exploitables à distance au travers d’une bibliothèque logicielle ad hoc. « On peut utiliser notre OPU avec une seule ligne de code en Python », assure Laurent Daudet.

Igor Carron, président de LightOn, présente la dernière génération de cœur photonique des OPU Aurora. © LightOn

Trier la masse d’information issue d’un accélérateur de particules

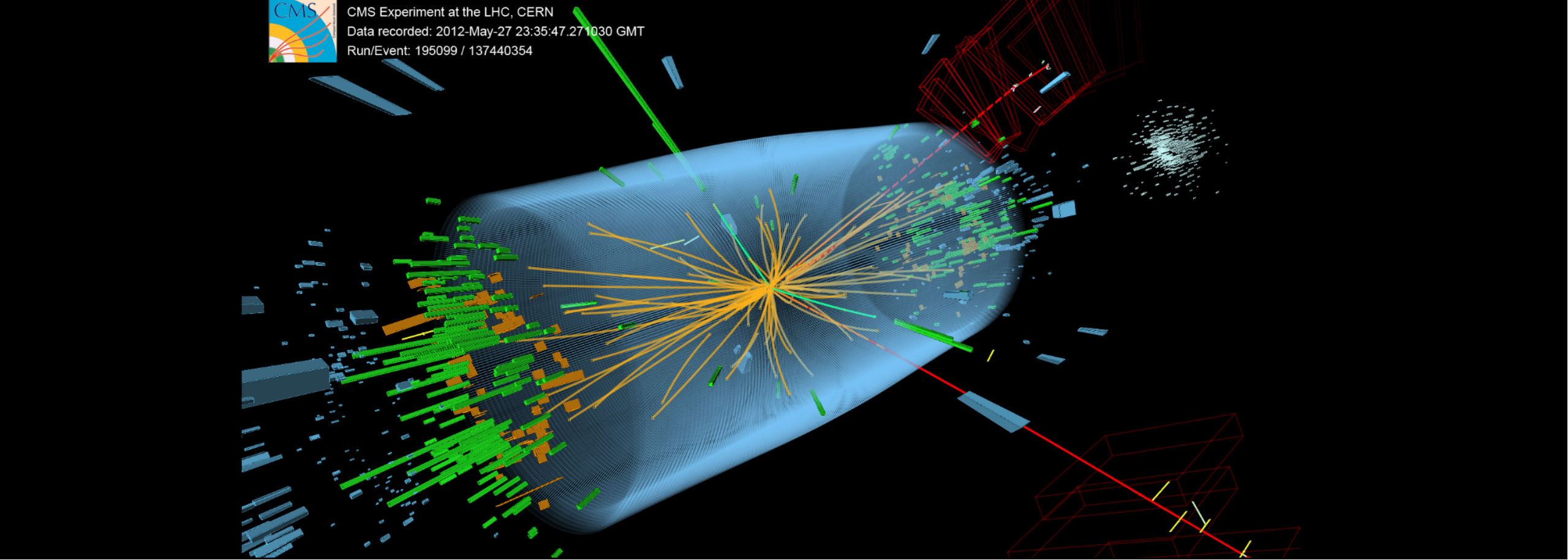

Qu’en est-il justement de l’utilisation de ce coprocesseur optique dans les laboratoires ? David Rousseau est un chasseur de particules. Il travaille souvent sur des données issues du LHC (Large Hadron Collider) du Cern (Organisation européenne pour la recherche nucléaire), installé à Genève, où le boson de Higgs fut découvert en 2012. Directeur de recherche au laboratoire de physique des 2 Infinis Irène-Joliot-Curie (IJCLab, UMR CNRS, université Paris-Saclay et université de Paris), à Orsay, il jongle entre physique des hautes énergies et sciences des données.

« Nous avons testé la technologie optique de LightOn sur un problème de classification d’images issues des calorimètres qui équipent les instruments Atlas et CMS au LHC, » indique le chercheur. Ces instruments fournissent des images visualisant les flux d’énergie après une collision de protons. Comme le collisionneur engendre quelque quarante millions de collisions par seconde, ce type d’instrument produit un flux d’images gigantesque, qu’il est matériellement impossible de stocker in extenso. Il est impératif d’effectuer un tri en temps réel, de sélectionner les images « intéressantes », où il se passe quelque chose.

« Nous voulions voir si l’approche optique de LightOn pouvait accélérer la phase d’apprentissage des réseaux de neurones qui trient ces images. Même si les algorithmes testés ont parfois un taux de bonne classification légèrement moindre qu’avec nos algorithmes de référence, nous avons observé un gain très net en vitesse d’apprentissage, par rapport à nos moyens de calcul habituels. Ces résultats sont suffisamment prometteurs pour que l’on envisage de futures expériences. »

La rencontre de chercheurs d’horizons différents

À l’origine de LightOn, il y a la rencontre de quatre chercheurs d’horizons différents. Igor Carron, le président de la start-up, faisait des recherches dans le domaine spatial à l’université A&M du Texas, tandis que Laurent Daudet travaillait sur des problèmes d’acoustique à l’université Paris-Diderot, Sylvain Gigan et Florent Krzakala, aujourd’hui conseillers scientifiques de la jeune pousse, étaient enseignants-chercheurs à l’ESPCI (École supérieure de physique et de chimie industrielles de la ville de Paris), Ils s’intéressaient respectivement à l’optique dans les milieux aléatoires et à l’apprentissage statistique. Le quatuor a publié un premier article[1] puis déposé un premier brevet en 2015. Leur start-up est créée l’année suivante. Installée au PC’Up, l’incubateur de l’ESPCI, elle réunit aujourd’hui 25 personnes.

Au MIT : l’apprentissage optique « sur silicium »

Le calcul optique a une longue histoire, qui débute dans les années 1950… mais il n’a jamais débouché que sur des applications de niche. Pourtant, en 2017, un article[2] publié par une équipe du MIT décrivait une expérience permettant le fonctionnement d’un réseau de neurones par voie optique. Le dispositif comportait notamment un réseau de minuscules interféromètres réunis sur un puce réalisée en technologie silicium. Les deux principaux auteurs de l’article, Nicholas Harris et Yichen Shen, après un début de parcours entrepreneurial commun, ont pris des chemins divergents et sont aujourd’hui à la tête de deux jeunes pousses rivales : Lightmatter, soutenue par des fonds d’investissement états-uniens derrière lesquels on trouve Google, et Lightelligence, qui a obtenu un financement auprès de Baidu, le Google chinois.

Dans les deux cas, l’objectif est d’intégrer des dispositifs optiques très miniaturisés sur le silicium d’une puce par ailleurs classique (CMOS). La lumière y est exploitée de manière unidimensionnelle, et non de façon massivement parallèle sous forme d’images, comme chez LightOn. Le marché visé est celui des applications embarquées où il importe d’exploiter des réseaux de neurones efficacement mais très sobrement, énergétiquement parlant. En août dernier, à la conférence Hot Chips 2020 de l’IEEE, Lightmatter a présenté un prototype de sa puce, dont la production est promise pour la fin 2021.

Un réseau de neurones optique fait de la reconnaissance vocale

En France, une équipe de l’université de Bourgogne Franche-Comté, à Besançon, s’intéresse à une tout autre approche des réseaux de neurones optiques. « Nous nous appuyons sur le concept de « reservoir computing », qui dérive des réseaux de neurones récurrents, explique Laurent Larger, le directeur de l’Institut Femto-ST. Nous avons publié[3] en 2017 les résultats d’une expérience qui nous a permis de tester avec succès notre solution sur un problème de reconnaissance vocale certes simplifié (chiffres) mais au rythme d’un million de mots par seconde. »

Aujourd’hui, LightOn propose l’accès à sa technologie via le cloud. Mais son objectif est de commercialiser un boîtier (rack standard 2U) construit autour de son coprocesseur optique, connectable à n’importe quel serveur. L’annonce devrait intervenir fin 2020. « Notre produit devrait intéresser toutes les équipes qui travaillent sur des applications ambitieuses de l’apprentissage profond, qui nécessitent de traiter des masses d’information énormes dans la phase d’apprentissage, estime Laurent Daudet. Par exemple dans le domaine du traitement du langage naturel, des algorithmes de recommandation, ou encore du criblage de molécules thérapeutiques. Notre technologie optique leur propose un bond en avant en termes de puissance de calcul en même temps qu’une importante économie d’énergie. »

[1]A. Saade et al., « Random projections through multiple optical scattering: Approximating Kernels at the speed of light, » 2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Shanghai, 2016, doi.org/10.1109/ICASSP.2016.7472872

[2]Shen, Y., Harris, N., Skirlo, S. et al. Deep learning with coherent nanophotonic circuits. Nature Photon 11,(2017). doi.org/10.1038/nphoton.2017.93

[3]Laurent Larger et al., High-Speed Photonic Reservoir Computing Using a Time-Delay-Based Architecture: Million Words per Second Classification, Phys. Rev. X, 7 (2017) doi.org/10.1103/PhysRevX.7.011015

Image de une : image d’une collision de particules détectée par l’instrument CMS (Compact Muon Solenoid) du LHC (Large Hadron Collider) du Cern, à Genève. © CERN