L’IA s’interroge sur sa voracité énergétique

⏱ 6 minL’intelligence artificielle, dont les besoins en puissance de calcul croissent de manière exponentielle, sera-t-elle freinée par sa voracité énergétique ? Toujours plus présente dans notre quotidien, son impact sur la planète commence à se faire sentir. Suffira-t-il de prôner une « IA verte » ou faudra-t-il faire le tri entre IA utile et IA futile ?

On sait déjà que le numérique en général consomme une part croissante, inquiétante, de la production électrique mondiale. « La consommation énergétique du numérique augmente de 9 % par an, assure Hugues Ferreboeuf, consultant et responsable de programme au Shift Project. Elle approche des 10 % de la consommation électrique mondiale. » Le dernier rapport de ce think tank, qui œuvre en faveur d’une économie libérée de la contrainte carbone, précise que 55 % seulement de cette consommation est le fait de l’utilisation des applications du numérique, les 45 % restant correspondant à la production et au recyclage de sa quincaillerie si vite obsolète : ce que l’on appelle « l’énergie grise ».

Quid des conséquences sur le climat ? « Dans notre dernier rapport, nous avons estimé la part des émissions mondiales de gaz à effet de serre dues au numérique à 4,3 % en 2020, contre 2,2 % en 2010, soit presque un doublement en dix ans », indique Frédéric Bordage, l’animateur de GreenIT.fr, « la communauté des acteurs du numérique responsable qui s’intéressent, entre autres, à la sobriété numérique, à l’écoconception des services numériques, à la low-tech, et plus globalement à un avenir numérique alternatif. »

Des applications toujours plus ambitieuses… et gourmandes en énergie

Qu’en est-il des applications de l’IA ? On voit fleurir, depuis peu, des publications académiques s’alarmant de la progression de la consommation énergétique des applications de l’apprentissage profond, le fer de lance actuel de l’IA. Comme celle¹, très citée, d’une équipe de l’université du Massachusetts, à Amherst, qui montrait en juin 2019 que l’entraînement de certains réseaux de neurones particulièrement complexes, utilisés dans les applications relevant du langage naturel, consommait autant d’énergie qu’un humain en 57 ans, ou que 316 allers-retours New-York – San Francisco.

Plus récemment, un article², signé en premier lieu par un chercheur du MIT, expliquait, en se fondant sur l’étude d’applications de l’apprentissage profond dans cinq grands domaines, que les progrès constatés par le passé « dépendent fortement de l’augmentation de la puissance de calcul ». Conséquence pour l’avenir : les progrès deviendront « rapidement insoutenables sur les plans économique, technique et environnemental ». Pour sortir de l’impasse, assurent les auteurs, il faut « des méthodes considérablement plus efficaces en termes de calcul, qui devront soit provenir de changements apportés à l’apprentissage profond, soit du passage à d’autres méthodes d’apprentissage automatique. » L’IA devrait-elle revoir sa copie ?

Pourtant, les algorithmes sont de plus en plus efficaces

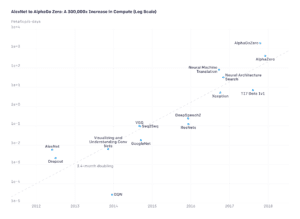

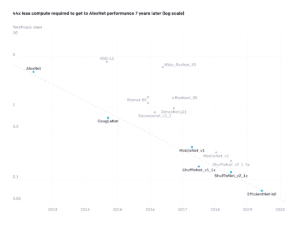

La célèbre entreprise de R&D OpenAI s’est exprimée sur ce sujet en mode chaud et froid. Une première étude³ publiée en 2018, et qui a fait du bruit, montrait que la quantité de calculs nécessaire à l’entraînement des plus puissants modèles d’apprentissage profond publiés s’était accrue d’un facteur 300 000 entre 2012 et 2018, soit un doublement tous les 3,4 mois. Ce qui semble promettre des lendemains qui déchantent. Mais en mai dernier, une nouvelle étude4, plus rassurante, montre cette fois que les algorithmes s’améliorent : pour atteindre le même niveau de performance sur le même jeu de données (ImageNet), les réseaux de neurones de 2018 sont 44 fois plus efficaces que ceux de 2012. Soit un gain d’un facteur 2 tous les seize mois. Sachant que dans le même temps, la loi de Moore nous dit que les machines sont de leur côté devenues, en gros, huit fois (doublement tous les deux ans) plus puissantes.

© OpenAI

© OpenAI

Revenons à la consommation électrique. « Quand la quantité de calcul nécessaire aux applications les plus avancées explose d’un facteur 10 chaque année, l’efficacité énergétique des ordinateurs s’améliore d’un facteur 10… en gros tous les huit ans », explique Arnaud Delaunay, responsable du pôle Data chez la société de conseil Linkvalue et auteur d’une étude5 sur le sujet. Il y a donc un problème. Même en tenant compte de l’amélioration constatée des algorithmes.

Mais l’amélioration de l’efficacité du logiciel et du matériel ne suffit pas

On peut donc craindre un coup de frein dans les prouesses à venir de l’IA… sauf à espérer des améliorations radicales permises par de nouvelles approches. En sciences, on n’est jamais à l’abri d’une bonne nouvelle. Un article6 récent, en provenance de l’université de Waterloo (Ontario, Canada), décrit par exemple une méthode permettant de réduire très fortement la taille du jeu de données nécessaire pour apprendre à les classifier. Cette nouvelle approche est dénommée « Less Than One Shot Learning », soit « apprentissage en moins d’un coup ». Elle promet des modèles qui apprennent à distinguer N classes d’objets à partir de M exemples, M étant plus petit que N. Et donc des économies substantielles. Affaire à suivre…

Reste que les appels à la sobriété se multiplient. Comme d’autres chapitres de l’informatique, l’intelligence artificielle cache sous le tapis sa part de gâchis. « L’apprentissage profond favorise une informatique paresseuse, estime Romain Rouvoy, chercheur de l’équipe Spirals (Inria, université de Lille), au sein du laboratoire Cristal. Il n’est plus nécessaire d’avoir un doctorat en machine learning pour s’en servir, et il est souvent mis en œuvre par des non spécialistes qui font appel à des bibliothèques perçues comme des boîtes noires qu’il suffit de nourrir d’un copieux jeu de données. Si les développeurs d’applications embarquées, sur smartphone ou objet connecté, sont sensibles aux questions de consommation électrique, parce qu’ils savent que leur code dépend de la charge d’une batterie, ceux qui travaillent sur l’entraînement de gros réseaux de neurones sur une informatique sédentaire s’inquiètent rarement de la question énergétique. Pire, le cloud est perçu comme une ressource « élastique« : on peut toujours lui demander plus de puissance. »

Vers une culture de la sobriété

Il y aurait comme un problème de culture. Des initiatives visent à promouvoir une méthodologie, un outillage pour l’éco-conception des applications. « Il faut changer les habitudes, poursuit le chercheur. Et pour cela des outils sont nécessaires. Pour commencer, le développeur doit pouvoir évaluer en permanence la consommation électrique du code qu’il produit. Depuis 2012, nous développons un outillage logiciel, PowerAPI, permettant de placer de véritables compteurs d’énergie dans le code, afin d’évaluer l’effet sur la consommation énergétique de toute amélioration ou correction apportée à une application. Notre bibliothèque est à l’œuvre chez Orange, et sera bientôt disponible sur OVH Cloud. »

L’entraînement de réseaux de neurones toujours plus complexes n’est pas la seule cause d’obésité énergétique de l’IA. « C’est une question très débattue aujourd’hui, indique Hugues Ferreboeuf : où doit-on faire de l’IA ? Une tendance actuelle veut qu’elle soit de plus en plus répartie, notamment sur des objets connectés faisant appel à des processeurs basse consommation. Une intelligence plus délocalisée permettrait de minimiser les communications avec l’informatique lourde et de moins encombrer le cloud. Mais cela peut déboucher sur une multiplication débridée d’objets dont « l’intelligence« est sollicitée quelques minutes de temps à autre. » Surtout si ce supplément d’âme est d’une utilité douteuse… « On doit se demander s’il est vraiment nécessaire de pouvoir parler à son aspirateur plutôt que d’appuyer sur un bouton. »

L’impact sur la planète va au-delà de la question énergétique

L’IA futile est également dénoncée par Frédéric Bordage. « La multiplication à l’infini d’objets numériques dont l’utilité est souvent discutable n’a pas seulement une incidence sur l’état de la planète au travers de la consommation d’énergie. La production de ces milliards de gadgets à la durée de vie courte et difficilement recyclables induit une surconsommation de ressources naturelles qui sont finies. Ces objets, petits mais si nombreux, dilapident eux aussi des métaux comme le cuivre, l’or, le lithium, le cobalt… Et l’indium, le germanium, le gallium, le tantale… et bien d’autres éléments rares. Nos estimations indiquent qu’il ne reste plus que trente années de ressources devant nous. »

« Il faut faire du numérique en général, de l’IA en particulier, un facteur de résilience plutôt qu’un facteur d’effondrement », clame Frédéric Bordage. Il serait dommage en effet que l’IA devienne complice du pillage de la planète alors qu’elle pourrait tant faire pour la protéger. Mais c’est un autre sujet.

Notes

1. Emma Strubell et al., Energy and Policy Considerations for Deep Learning in NLP, Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, 2019. www.aclweb.org/anthology/P19-1355.pdf

2. Neil C. Thompson et al., The Computational Limits of Deep Learning, 2020, arxiv.org/pdf/2007.05558.pdf

3. openai.com/blog/ai-and-compute

4. openai.com/blog/ai-and-efficiency

5. Quelle est l’empreinte écologique des entraînements de modèles en data science ?

6. arxiv.org/pdf/2009.08449.pdf