Toucher : vers des prothèses plus intelligentes ?

⏱ 5 minLes progrès du deep learning permettent d’envisager des prothèses à la fois plus agiles et plus faciles à appréhender pour les patients. À plus long terme, des algorithmes d’apprentissage non supervisé laissent même entrevoir l’émergence d’un véritable sens du toucher artificiel.

La France compte entre 8 000 et 15 000 personnes amputées d’un membre supérieur, ce qui représente 15 % environ du nombre total de personnes amputées. Pour leur faciliter la vie, des prothèses robotiques contrôlées par signal myoélectrique – l’activité électrique des muscles mesurée par des électrodes posées sur la surface de la peau– ont fait leur apparition ces dernières années. Mais ces prothèses demeurent difficiles à contrôler : « Même les mouvements les plus simples nécessitent des années d’apprentissage au corps humain », explique Daniel Cattaert, chercheur à l’Institut de neurosciences cognitives et intégratives d’Aquitaine (INCIA, CNRS /université de Bordeaux). Au sein de l’équipe HYBRID, ce dernier développe des algorithmes de contrôle plus précis et intuitifs grâce au machine learning, pour que le bras robotique reproduise à l’identique le mouvement voulu par le patient. Ces travaux explorent deux voies : d’abord des algorithmes classiques de vision par ordinateur pour mieux déceler l’intention dans le mouvement de préhension, et de manière plus prospective, la conception d’algorithmes de type réseau de neurones directement inspirés de notre sens du toucher intégrant de fines boucles de rétroaction entre muscle, os et nerfs.

Miser sur la vision artificielle

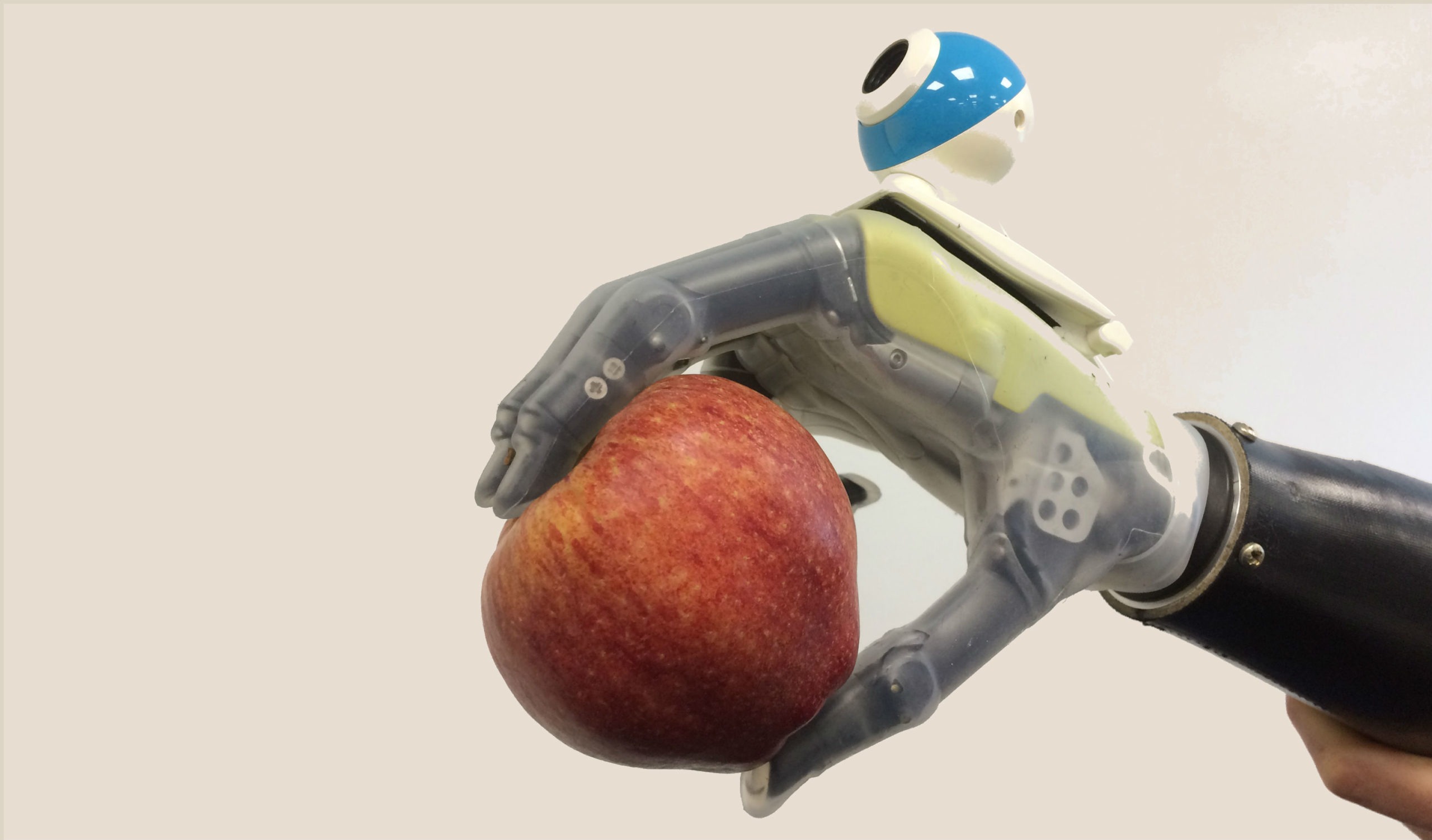

En 2017, choisissant la voie mature de la vision artificielle, une équipe d’ingénieurs en biomécanique de l’université de Newcastle a présenté une main bionique surmontée d’une caméra ; elle est actuellement en essai clinique. Selon l’auteur principal, Kianoush Nazarpour, cette main permettrait, à l’instar d’une main naturelle, « d’attraper une tasse ou un biscuit au premier coup d’œil dans la bonne direction ». Pour y parvenir, les chercheurs ont entraîné un réseau neuronal convolutif (CNN) pour classifier 500 objets en fonction du mode de préhension le plus approprié, « mais sans les identifier de manière explicite, ni mesurer leurs dimensions », précise Kianoush Nazarpour. Pour chacun, 72 images prises sous différents angles ont été utilisées, aboutissant au terme de l’entraînementà un succès de classification des nouveaux objets de 75%. Lors d’un test ultérieur en conditions réelles, deux personnes amputées ont ainsi pu se saisir avec succès des objets voulus dans 88% des cas, avec un temps de reconnaissance décroissant.

Des prototypes également basés sur des algorithmes de vision artificielle ont été mis au point par les gagnants d’Imagine Cup, un concours technologique international réservé aux étudiants et organisé par Microsoft, ainsi que par l’université de New York, mais avec des approches divergentes. Dans le premier cas, les données visuelles étaient envoyées dans le cloud pour la partie classification en recourant au service Custom Vision du géant américain. Dans le second cas, les calculs décrits par la chercheuse Rohini Sharma ont été embarqués au sein du dispositif grâce à un GPU ; elle utilise la bibliothèque libre OpenCV et la plateforme open source TensorFlow.

Ou la peau artificielle

Malgré ces avancées, le développement d’un sens du toucher artificiel semble indispensable à terme. « Notre sens du toucher est très performant car notre cerveau associe l’information visuelle et l’information tactile. Sans retour tactile, il reste très difficile, par exemple, de manipuler un objet fragile sans le briser », souligne le chercheur Alexandre Pitti. Au sein du laboratoire ETIS (Université de Cergy-Pontoise / CNRS/ENSEA), ce dernier a développé une peau artificielle souple, et a utilisé un réseau de neurones auto-organisé pour simuler un type de mécano-récepteur humain à sa surface. Cette peau peut recouvrir bras robotiques et prothèses pour mieux détecter la nature des objets. « C’est un gros enjeu de recherche en termes d’électronique, mais il y a aussi un défi au niveau du traitement du signal. Même avec les capteurs les plus précis au monde, un dispositif tactile sans traitement intelligent sera toujours bancal », prévient le chercheur.

Une voie possible consiste à réaliser un entraînement supervisé de ces peaux artificielles, moyennant le développement de bases de données conséquentes, comparable à ce qui a permis l’essor de la vision artificielle. C’est l’objectif que se sont fixés des chercheurs du MIT. Grâce à un gant peu onéreux intégrant 550 capteurs de pression, ils ont réalisé une « cartographie tactile » – de courtes vidéos montrent les points de pression grossir ou rétrécir sur la surface de la main – pour 27 objets, créant une banque de 135 000 « signatures » de la préhension humaine. Cette banque de données peut être utilisée pour entraîner un réseau de neurones à identifier la nature et la masse des objets à manipuler. Des chercheurs japonais menés par le professeur Akira Furui, de l’université de Hiroshima, travaillent également sur la classification des signaux myoelectriques relatifs à certains gestes, pour améliorer la réponse des prothèses robotiques.

Entraînées par apprentissage non supervisé

De manière plus prospective, des chercheurs de Facebook AI et de l’université de Berkeley, en Californie, s’intéressent à une méthode de manipulation qui ne nécessite aucun entraînement préalable. Cet apprentissage « non supervisé » se base sur un algorithme baptisé « deep tactile MPC », directement inspiré de réseaux de neurones d’analyse de séquences vidéos pour prédire les images futures à partir des images précédentes. En l’occurrence, cet algorithme a analysé les « cartes tactiles » établies par un capteur de haute résolution lors de différentes gestes comme rouler une bille, déplacer un bâton ou identifier au toucher le chiffre d’un dé à 20 faces. Il a ensuite pu proposer des actions pour la suite de ces gestes. Un résultat prometteur pour « créer des systèmes capables de comprendre comment l’environnement va réagir au toucher », concluent les auteurs.

En France, à l’université de Cergy-Pontoise, Alexandre Pitti explore lui aussi des méthodes d’apprentissage non supervisé. « La première étape consiste à ce que la peau artificielle qui recouvre le bras puisse se construire une sorte de représentation topologique de ses propres capteurs, en intégrant information tactile, visuelle et motrice, pour savoir, dans n’importe quelle situation, quand elle est touchée, et où », résume le chercheur. Ce processus se base sur des algorithmes de type cartes de Kohonen, une classe de réseau de neurones permettant de faire émerger des relations de voisinage entre les neurones par auto-organisation, suite à une première phase d’apprentissage pendant laquelle les chercheurs exercent des pressions aléatoires sur toute la surface de la peau artificielle.

Algorithmes et neurobiologie

Une fois cette « cartographie corporelle » acquise – un sens appelé proprioception chez l’humain – Alexandre Pitti et son équipe ont essayé d’y intégrer des informations tactiles et visuelles. Ils s’inspirent pour cela de découvertes récentes en neurobiologie. « Certains types de neurones au sein du cortex pariétal sensorimoteur, dits « neurones de proximité », s’activent lorsqu’un objet est proche d’une partie du corps. Autrement dit, nous anticipons le contact », résume Alexandre Pitti. Les chercheurs ont implémenté ce mécanisme neuronal au sein d’un nouvel algorithme et ont réussi à le reproduire : ils ont détecté une activation de certains neurones artificiels lorsqu’un objet approchait de leur peau artificielle, « ce qui veut dire que le programme apprend tout seul la distance entre la peau et l’objet », se félicite Alexandre Pitti. Prochaine étape ? « Exploiter cette fonctionnalité toujours sur un vrai robot pour améliorer sa capacité à se représenter son propre corps, à se diriger vers un objet et à le saisir ».

Hugo Leroux

Illustration à la une, la « main qui voit » de l’Université de Newcaslte @Newcastle University.