De plus en plus de données disponibles mais de quelle qualité ?

Au-delà du problème déjà évoqué d’ouverture des données des collectivités locales, c’est un problème de qualité qui se pose. Une qualité indispensable dans une logique d’interopérabilité, de fraicheur, de granularité, etc., condition sine qua non à des usages ultérieurs variés.

« Les villes françaises disposent de données de qualité, du point de vue intrinsèque, affirme Jean-Marie Bourgogne, délégué général d’OpenDataFrance, l’association publique qui accompagne les collectivités dans l’opendata. En revanche, elles sont, en général, sous des formats très variés, même quand elles sont mutualisées dans des portails communs en txt ou csv, ce qui permet de programmer des requêtes automatisées. Le problème est qu’elles sont stockées telles que les collectivités les ont, ce qui empêche de les croiser. A l’heure actuelle, à cause de ce manque d’homogénéisation, les données des villes ne sont pas du tout interopérables. » Certaines ne sont pas datées, des champs sont mal remplis voire vides ou tout simplement renseignés différemment : par exemple la date est sous la forme jour/mois/année ou l’inverse, le mois défini sous forme de nombre ou en toutes lettres, l’année signalée comme 2018 ou 18 ; des chiffres sont séparés de virgule ou de point ; des villes sont décrites sous plusieurs noms, etc. Sans parler des données qui sont disponibles sous forme pdf, impossibles à traiter de façon automatisée.

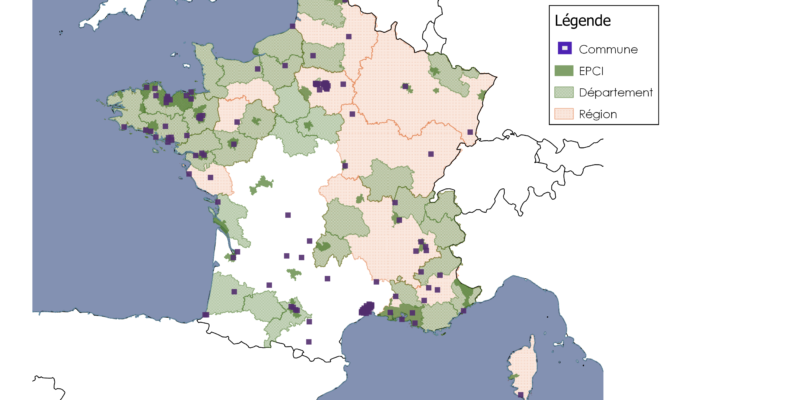

OpenDataFrance a défini un ensemble de bonnes pratiques et une normalisation des jeux de données, selon des standards précis (voir 1er article du dossier). Un Observatoire de l’opendata des territoires (voir carte ci-dessous), en cours de finalisation, sera, par ailleurs, lancé en mars prochain pour collecter et cartographier automatiquement toutes les données disponibles sur un territoire, publiques ou privées, savoir qui les publie, dans quel format, avec quel contenu, quel accès.

© OpenDataFrance

Figure sur cette carte l’ensemble des collectivités locales françaises déjà engagées dans une démarche d’ouverture et de partage de données publiques.

Bientôt un outil pour tester la qualité

« Harmoniser toutes ces données n’est pas forcément compliqué contrairement à ce que veulent faire croire certains, explique Jean-Marc Lazard, d’OpenDataSoft, éditeur de portails de données. Certes, le champ des données est un gros bazar mais il existe des outils pour corriger cela en partie comme notre plateforme. » Et les éditeurs de progiciels qu’utilisent les collectivités vont devoir se mettre au diapason. « Quand les 5 éditeurs pour les marchés publics incluront un format d’export de données au standard national que nous avons défini, 90 % des collectivités locales seront conformes, confirme Jean-Marie Bourgogne. Ce sera le cas dès cette année puisque cela va devenir contractuel. » Les appels d’offre des villes exigeront, à terme, de mettre à disposition les données brutes et dans des formats bien définis. C’est un mouvement de fond.

Et des outils tels que la plateforme Qualidata devraient y contribuer d’ici à 2019 : ce projet d’OpenDataFrance, financé par le dernier Plan investissements d’avenir, devrait permettre de tester si la qualité des données est en conformité avec le référentiel national avant de l’injecter dans une base de données pour tel ou tel usage, public ou privé. « Les premiers tests concerneront les sept jeux de données essentielles pour lesquels les standards ont été définis, ceux sur l’état civil, les marchés publics, les subventions, les équipements publics… poursuit Jean-Marie Bourgogne. Nous ajouterons d’autres jeux de données au fur et à mesure de nos capacités à qualifier leur description. » Ailleurs, comme aux Etats-Unis où l’open data est la règle, la publication des données est encouragée quelle que soit leur qualité. Mais seuls les geek et les experts sont capables de les valoriser. C’est une autre façon de faire.

Adapter la qualité au contexte d’utilisation

Cela dit, la qualité de la donnée dépend avant tout du contexte dans lequel on veut la réutiliser, fait remarquer Jean-Marc Lazard : de quelle exhaustivité, justesse, fraicheur, granularité a-t-on besoin ? : « Le principal problème pour exploiter les données en l’état, ce n’est pas leur format mais leur diversité et leur hétérogénéité vu la variété de capteurs dont elles proviennent. » Il cite l’exemple d’une donnée sur la qualité de l’air qui peut nécessiter plusieurs mesures successives et un traitement algorithmique avant de devenir interprétable. Autre notion importante à définir selon l’usage : la granularité de la donnée, c’est-à-dire son degré de précision, que ce soit dans l’espace ou dans le temps (a-t-on besoin d’une mesure au mètre, à l’heure, au mois… ?). « Attention néanmoins à ne pas faire de la surqualité, pointe-t-il, comme de chercher à avoir des données en temps réel si l’on n’en a pas besoin. C’est l’usage de la donnée qui compte et doit orienter les améliorations. » Autrement dit, une donnée métier peut être de qualité suffisante pour un usage précis mais pas pour être réutilisée dans un autre contexte.

Isabelle Bellin

Pour aller plus loin :

Présentation publique de l’observatoire open data des territoires le 21 mars 2018