Edge Computing : une des clés du traitement des données de la smart city

⏱ 3 minPour répondre au déluge de données engendré par les projets de smart cities, un réseau décentralisé, capable de traiter les données localement au plus près des capteurs qui les génèrent, s’imposera.

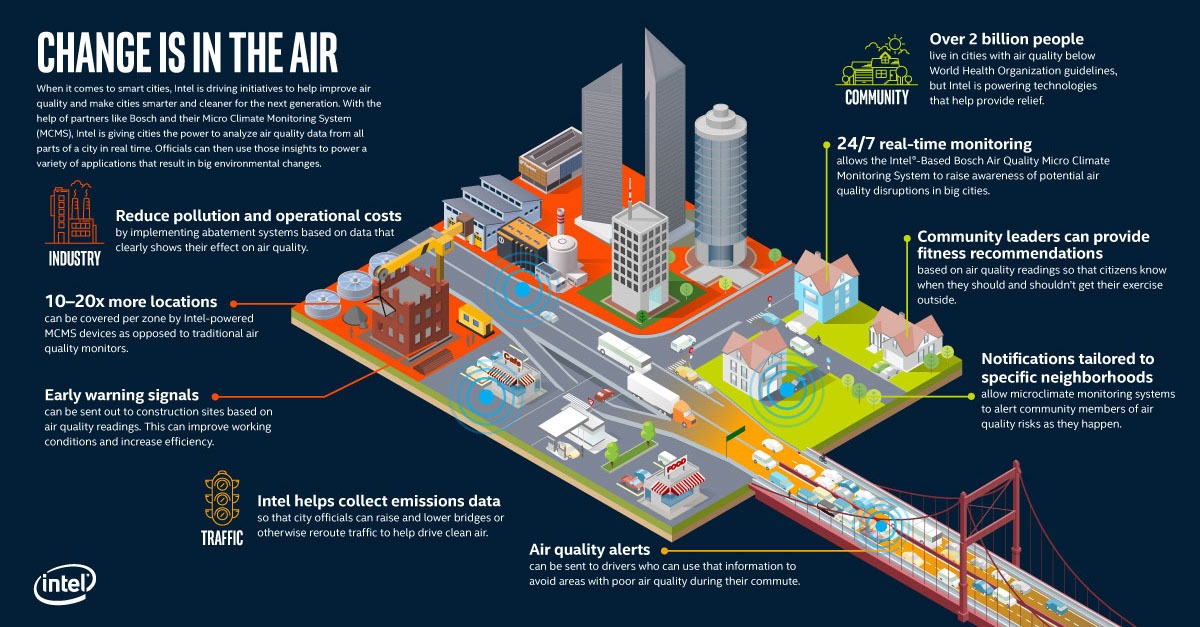

Mesure de la qualité de l’air, régulation du trafic, gestion des réseaux, surveillance, informations à destination des piétons ou des automobilistes… la ville intelligente, c’est d’abord un volume quasi infini de données issues de capteurs et des divers objets connectés coopérant et négociant entre eux. Autant d’informations à enregistrer, agréger, traiter et dispatcher. Ce futur big data des villes est à mettre en regard des capacités forcément limitées des réseaux et des centres de calcul. Face à ce constat, la solution existe : l’Edge Computing, soit une architecture informatique décentralisée, jusque dans les objets eux-mêmes, permettant de traiter les données au plus près de leur lieu de production. Littéralement, on parle de traitement de données à la périphérie du réseau, par opposition au modèle où l’intelligence serait toute entière contenue au sein de datacenters distants, parfois sur d’autres continents, le fameux cloud. « C’est la condition de l’avènement de la ville intelligente, prévient Patrick Demichel, chez HPE. Tous les acteurs du numérique vont dans cette direction. »

Concrètement, l’Edge Computing consiste à faire traiter les données par le périphérique lui-même, ou par un ordinateur ou un serveur local, au lieu de les transmettre à un datacenter. Cela permet à des capteurs et des actionneurs de traiter une partie de l’information qu’ils recueillent en aval du réseau. De quoi par exemple décider de faire passer un feu de circulation au vert dans le but de désengorger un carrefour, à partir de l’analyse du trafic local par traitement d’images. L’information issue de plusieurs sources est ensuite synthétisée en vue d’un traitement de plus haut niveau. Typiquement, l’information recueillie par un ensemble de caméras de vidéosurveillance permet la régulation du trafic à l’échelle d’un quartier ou d’une ville. Enfin, en amont du réseau, le cloud fusionne et exploite les données globales, notamment au moyen d’algorithmes d’apprentissage profond – ou deep learning – pour la mise à jour des modèles de décision implémentés en périphérie. « Chaque cas sera particulier, mais génériquement, l’idée est celle d’un réseau de traitement des données en strates », résume le spécialiste.

Premiers déploiements

L’avènement de l’Edge Computing est liée à l’explosion de l’intelligence embarquée, et ce jusqu’au sein des composants les plus basiques. De quoi transformer chaque étage du réseau en un véritable centre de calcul. Dans le jargon des technologues, ces plateformes intermédiaires sont des « gateways ». Jean-Laurent Philippe, chez Intel, explique : « Ce sont des calculateurs à l’écoute des capteurs d’un côté et connectés au cloud de l’autre. » Des solutions existent déjà et certaines villes commencent à les déployer, par exemple Grenoble, Santander en Espagne, ou Tsukuba au Japon. Ainsi, Intel1 et Bosch proposent par exemple une gateway pour le suivi en continu et en temps réel d’une myriade de paramètres atmosphériques : température, humidité, intensité lumineuse, taux de particules, concentration en dioxyde de carbone… Elle prend la forme d’un boitier incluant capteurs et logiciels d’analyse, le tout relié en filaire ou en hertzien au réseau global.

Plus précisément, les gateways ne sont pas des ordinateurs comme les autres. Leur particularité : une capacité hors pair à agréger des données hétérogènes, transitant par de multiples canaux (wifi, 4G, Ethernet, LoRa, Zigbee, Z-Wave, Bluetooth…) et échangées via des protocoles variés. Ainsi, « l’innovation se porte essentiellement sur les périphériques et le middleware », précise Jean-Laurent Philippe. Un exemple : la plateforme SensiNact2, développée par le CEA, est capable de réunir sur une interface unique des informations aussi différentes que des températures, la fréquentation d’un musée ou le trafic automobile. « Déployée dans le cadre des projets ClouT puis BigClouT3, SensiNact a permis un accès unique à plus de 500 000 équipements physiques et virtuels répartis dans plusieurs villes européennes et japonaises », détaille Marc Duranton, au CEA-LIST. L’intérêt ? La possibilité pour les développeurs d’applications d’utiliser l’ensemble de ces données sous un format unique.

A terme, l’Edge Computing nécessitera des solutions nouvelles dans tous les segments des technologies numériques. A commencer par des architectures de processeurs optimisées pour des calculs plus rapides et moins gourmands en énergie. La Solution PNeuro4, développée par le CEA-LIST et la start-up GlobalSensing Technologies, se distingue ainsi par un gain énergétique de 200 lors de la mise en œuvre d’un algorithme type réseau de neurones, par rapport au cas où ce dernier est exécuté sur un processeur graphique embarqué (GPU). Cette solution permet, par ailleurs, de traiter 25 000 images par seconde quand un processeur classique plafonne à 900.

Pour sa part, Emilio Calvanese Strinati, au CEA-Leti, cite un projet de cloud « élastique », capable de fédérer, au gré des besoins, les capacités de calcul de plusieurs gateways. « Nous travaillons également sur des solutions permettant de conserver localement le résultat d’une requête sur Internet, dès lors qu’elle serait effectuée un grand nombre de fois dans un laps de temps réduit et dans un périmètre restreint, décrit le scientifique qui ajoute : Nous testerons notamment de telles solutions lors des Jeux olympiques de 2020, à Tokyo, dans le cadre du projet H2020 5GMiEdge5. » A n’en pas douter, avec l’essor de l’Edge Computing, la ville intelligente changera de dimension.

Mathieu GROUSSOn

1 https://www.intel.com/content/www/fr/fr/internet-of-things/gateway-solutions.html

2 http://www.leti-cea.fr/cea-tech/leti/Pages/innovation-industrielle/Demonstrateurs/SensiNact.aspx