IA militaire : la menace (de moins en moins) fantôme

⏱ 5 minLes forces militaires sont de plus en plus tentées d’intégrer des technologies d’intelligence artificielle (IA) pour guider ou automatiser leurs décisions. Elles songent aussi aux armes autonomes, sur lesquelles travaillent de grands industriels de l’armement. Autant de systèmes qui deviendront à leur tour des cibles dans l’espace cyber.

En 2015, puis en 2017, un panel de chercheurs (dont Stephen Hawking), mais aussi d’industriels (comme Elon Musk) publiaient une lettre ouverte demandant à l’Organisation de Nations unies de bannir les robots tueurs. Ce qui inquiète ces spécialistes d’informatique et d’IA ? La jonction des technologies de Machine Learning et de la robotique, aboutissant à la création d’armes autonomes capables de reconnaître des cibles et de prendre seules la décision de les détruire.

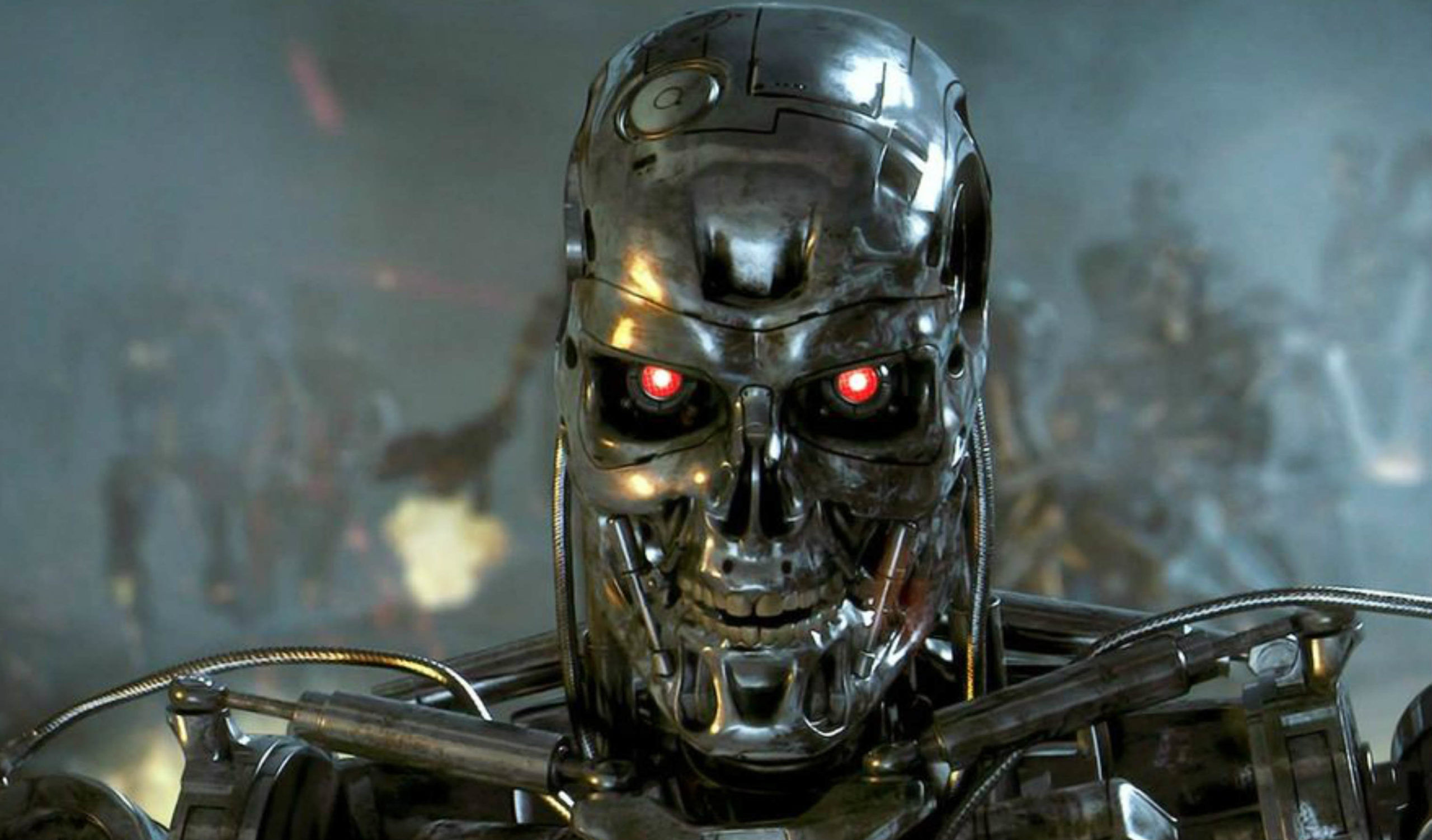

Science-fiction ? Plus tout à fait. Car ce scénario à la Terminator fait clairement partie des priorités de certains États. L’armée russe explique ainsi vouloir robotiser au moins un tiers de ses armements d’ici à 2025, et le célèbre fabriquant d’armes Kalashnikov ne se prive pas d’aligner plusieurs systèmes autonomes à son catalogue, grâce à l’utilisation d’une technologie d’IA qui serait à même d’identifier des cibles sur le champ de bataille et de prendre la décision de tirer sans intervention humaine. Coup marketing du célèbre concepteur de l’AK-47 ? Probablement, d’autant que les premières annonces quant aux capacités réelles de cette IA restent assez floues. Mais les travaux russes, symbolisés par une vidéo d’un robot humanoïde (le Fedor), tirant sur des cibles au moyen de pistolets, ou encore les recherches américaines (les États-Unis disposent de prototypes de robots tueurs, selon le New York Times) ont de quoi réveiller bien des peurs.

Défis techniques, questions culturelles et éthiques

Pour l’instant toutefois, faute de technologies réellement au niveau, les armes totalement autonomes ne seraient probablement pas opérationnelles sur un champ de bataille. « Disposer d’armes 100 % autonomes pose de nombreux problèmes techniques, car on parle ici de tâches complexes, explique Jean-Christophe Noël, chercheur associé au centre des études de sécurité de l’Institut français des relations internationales (Ifri). Les solutions actuelles correspondent à des applications limitées… Innovantes et très utiles, mais limitées. Surtout, l’homme n’a pas renié sa place dans l’armée ; les questions culturelles et éthiques que pose le déploiement d’armes autonomes ne vont pas être balayées du jour au lendemain. »

Auteur d’un récent rapport sur l’utilisation de l’IA dans l’armée (Intelligence artificielle : vers une nouvelle révolution militaire, disponible en téléchargement), Jean-Christophe Noël y brosse un panorama assez éloigné d’un épisode de Star Wars. Il met plutôt en avant des applications très précises, dont la vocation est d’aider les militaires, non de les remplacer. « Des applications qui vont dans le sens d’une collaboration raisonnée entre l’homme et les machines », souligne-t-il.

Aider l’opérateur de tir à acquérir des cibles

Le premier Forum Innovation Défense, qui se tenait fin novembre à Paris, offre un aperçu des projets phares sur lesquels travaillent l’armée française et les industriels hexagonaux. Citons en particulier le programme de drones aériens, conçu par Naval Group (l’ex-DCNS) et Airbus, pour équiper les navires de combat de la Marine nationale. Dérivés d’un hélicoptère civil, ces drones de reconnaissance devraient être mis en service avant 2030. On retrouve une philosophie similaire dans un projet franco-britannique de lutte contre les mines sous-marines. Là encore, il s’agit d’utiliser des drones autonomes pour détecter et neutraliser ces menaces. Ce projet, mené par Thales et BAE Systems, repose notamment sur des technologies de reconnaissance et de classification. Autre projet aperçu sur le Forum, un système autonome d’acquisition de cibles, embarqué sur des blindés, un travail de recherche mené par le fabriquant de missiles MBDA. Reposant sur des chaînes algorithmiques capables d’identifier en temps réel plusieurs types de cibles par leur signature thermique, et sur une informatique à base de processeurs Kalray (conçus en France), le système vise, en tout cas pour l’instant, à assister les opérateurs de tirs.

De son côté, Jean-Christophe Noël cite plusieurs cas représentatifs des travaux de recherche actuels. Le projet américain Maven d’abord : ce dernier vise à trier et à analyser les images de drones pour sélectionner les plus pertinentes. Les IA d’assistance au pilotage sur les avions de chasse ensuite. Ici, il s’agit de décharger le pilote de certaines tâches, quand ce dernier est stressé et saturé d’informations. Et, enfin, les applications capables de coordonner des réseaux de tirs (par exemple pour défendre un navire attaqué) ainsi que les flux logistiques de munition. « À mon avis, les premières applications qui seront déployées permettront d’interpréter un maximum de sources d’informations, pour disposer d’une connaissance maximale du champ de bataille et recommander des actions, en prenant en compte, par exemple, la doctrine de l’armée concernée, la personnalité des généraux adverses ou encore des données sur la portée des armes déployées sur le terrain », précise le chercheur.

« Si on arrive à des intelligences fortes, l’impact sera impressionnant »

Même si on est encore loin d’un scénario à la Terminator, l’automatisation croissante embarquée dans les armements pose déjà des questions sur la relation entre l’homme et la machine. Car les exemples passés montrent que l’humain a parfois du mal à interpréter les réactions de la machine. Rappelez-vous les batteries de missiles sol-air Patriot utilisées lors de l’invasion de l’Irak en 2003, dont les opérateurs avaient mal compris un automatisme, ce qui avait conduit à la destruction par erreur d’un avion américain et à la mort de son pilote.

La nature des projets actuellement les plus avancés ne permet toutefois pas d’écarter tout à fait les risques que font peser d’éventuels progrès spectaculaires de la technologie. Comme l’explique Jean-Christophe Noël, « si les promesses actuelles de l’IA se vérifient et qu’on arrive à des intelligences fortes, l’impact sera impressionnant : nous assisterons alors à la montée en puissance de l’automatisation. En effet, dans le contexte actuel de concurrence exacerbée, notamment entre les États-Unis et la Chine [lire notre article « La Chine bientôt 1ère puissance mondiale grâce à l’IA »], ces technologies seront testées, et feront alors évoluer notre rapport à la guerre, avec la possible délégation de notre sécurité à des robots. Ce qui peut entraîner une déresponsabilisation des sociétés et, à terme, la déshumanisation de plus en plus fréquente des décisions. » La récente décision du Département de recherche militaire américain (la Darpa) d’injecter 2 milliards de dollars dans un programme appelé « AI Next », visant à développer les futures générations de technologies d’IA, capables de mieux s’adapter à un environnement changeant et de prendre des décisions, y compris dans des domaines où elles n’ont pas été entraînées, montre en tout cas que certaines nations, États-Unis en tête, sont déterminées à aller vers une autonomie croissante des machines. Et un monde dans lequel l’homme ne serait plus essentiel dans la prise de décisions.

Empoisonner une IA

Cette automatisation croissante va, par ailleurs, inévitablement donner naissance à des contre-mesures. Les systèmes informatiques hébergeant les IA risquent à leur tour de devenir la cible de cyberattaques, visant à rendre ces algorithmes inopérants, voire à les détourner de leurs missions, au détriment des armées qui les exploitent. Sans oublier les vulnérabilités propres aux IA. Ces dernières sont soumises à au moins trois types de menaces spécifiques, ne nécessitant pas de prendre le contrôle du système informatique les hébergeant, énumère Gérôme Billois, associé au sein de l’activité cybersécurité du cabinet de conseil Wavestone :« Les attaques par empoisonnement d’abord, qui consistent à injecter des données permettant de détourner une IA de son modèle initial. Les attaques par inférence ensuite, où il s’agit ni plus ni moins que de tirer les vers du nez d’une intelligence artificielle. Soit pour découvrir ses limites, soit pour accéder à des données. Enfin, les attaques par illusion auxquelles sont aussi sensibles les algorithmes de reconnaissance d’images. » Comme l’a montré un récent test, il suffit par exemple d’apposer une bande de scotch sur des panneaux routiers pour tromper les algorithmes des véhicules autonomes… Les algorithmes utilisés dans le civil étant similaires à ceux exploités dans le domaine militaire, nul doute que les chars robotisés, les véhicules blindés autonomes ou les modules de transport seront eux aussi vulnérables à des techniques voisines. Qu’on pourrait qualifier de camouflage 2.0.

William Chinaski