L’IA fait de plus en plus entendre sa musique

L’informatique musicale est un domaine passionnant qui, comme bon nombre de champs artistiques, utilise l’apprentissage automatique (machine learning), parfois statistique (à base de probabilités), parfois à base de deep learning et de réseaux de neurones. Néanmoins, même s’ils stimulent la créativité, les algorithmes développés n’ont pas d’intérêt sans l’expertise de musiciens. Aucune intelligence artificielle (IA) n’est encore capable de composer seule.

L’idée de musique électronique apparait dès les débuts de l’informatique, en 1842… quand Ada LovelaceEn son honneur, TheVinylFactory a créé The Ada Project, une timeline qui permet de découvrir des portraits de ces pionnières de la musique électronique., travaillant avec Charles Babbage et ses machines de calcul, imaginait de « composer de manière scientifique et élaborée des morceaux de musique de n’importe quelle longueur ou degré de complexité ». La musique comparée à une science ? « Bien sûr, répond Philippe Esling, chercheur à l’Ircam (Institut de recherche et coordination acoustique/musique) et professeur d’informatique à l’UPMC (Paris 6). Dans l’Antiquité (dans le Quadrivium), la musique figure parmi les 4 sciences fondamentales aux côtés de l’arithmétique, de la géométrie et de l’astronomie, et cela jusqu’aux invasions Viking au VIIIe siècle. Elle réapparait dans les arts et les sciences à la Renaissance et surtout avec la musique contemporaine au XXe siècle. » Notamment avec le travail de Iannis Xenakis, un des pionniers en la matière comme le rappelle l’exposition Artistes et robots (voir notre article).

IANNIS XENAKIS

Iannis Xenakis au CEMAMU, 1972

© Collection Famille Xenakis – droits réservés

Qu’en est-il aujourd’hui ? Musique et informatique sont désormais à l’honneur dans des conférences internationales comme CSMC (Computer Simulation of Musical Creativity) ou bien encore ICMC (International Computer Music Conference) et SMC (Sound and Music Computing), où plus de la moitié des présentations concernent les réseaux de neurones. Ci-dessous un exemple de composition étonnant, en live !

Aide à la composition

Qu’apporte le deep learning ? « De nouvelles perspectives de synthèse musicale, de nouvelles manières d’interagir avec la musique, de la représenter comme nous l’avons évoqué récemment dans le cadre d’une journée sur l’apprentissage automatique appliqué à la musique, poursuit le chercheur qui met néanmoins en garde contre les effets de mode : dans beaucoup de cas, ces méthodes ne sont pas au niveau des approches d’apprentissage statistique que nous développons depuis maintenant 40 ans à l’Ircam. » Prenons le cas des logiciels de co-improvisation Omax ou ImproteK améliorés avec des modèles probabilistes à base de mémoire, ils génèrent une véritable créativité avec une conversation musicale entre le musicien et le système.

Quoiqu’il en soit, les exemples d’IA utilisées dans le champ musical se multiplient : Amper pour générer des bandes sons d’accompagnement, Duet pour l’accompagnement piano, NSynth pour créer de nouvelles sonorités, Emmy pour composer « à la façon de »…. Fin 2016, l’Institut Asimov a comparé six modèles (Magenta, Deep Jazz, Bach Bot, Flow Machines, Wave Net, GRUV), la plupart à base de réseaux de neurones. La conclusion est qu’il faut encore des musiciens aux manettes. De même, l’album Hello World, sorti sur plusieurs plateformes en janvier 2018 est bien loin d’avoir été entièrement composé par une IA comme cela a été annoncé. Les 15 titres ont été réalisés avec Flow Machines, une IA développée dans le cadre d’une bourse ERCCes bourses octroyées par le Conseil européen de la recherche (ERC en anglais) financent des chercheurs d’exception pour mener des recherches exploratoires par le français François Pachet désormais directeur du laboratoire de recherche de Spotify. Le système est entrainé sur un gigantesque corpus de morceaux avec des algorithmes à base de chaînes de MarkovUne chaîne de Markov permet de déterminer l’état suivant en fonction de l’état actuel et d’un jeu de probabilités. Plusieurs compositeurs ont utilisé ce procédé algorithmique..

Résultat : plutôt que de composer, cette IA est surtout capable d’imiter n’importe quel style de musique. Comme le précisait François Pachet à Forward : « L’idée n’était pas de faire des automates mais plutôt des outils d’assistance à la composition ou à la création/…/Cela génère de nouveaux actes créatifs, le premier étant de choisir ce qu’on va mettre dans le système. Et il n’y a qu’un musicien avec une intention et un projet qui puisse choisir ces données d’entrée. Avec l’intelligence artificielle, on fait du sampling, c’est-à-dire qu’on tire des échantillons à partir de modèles, ce qui est probablement un des éléments du processus de création musicale, mais pas uniquement. »

Modélisation du son

Pourquoi les modèles à base de deep learning qui ont donné de formidables résultats en analyse d’images sont-ils plutôt décevants en musique ? « D’abord parce qu’il est quasi impossible de faire un instantané de la musique comme on découpe une image en parties élémentaires, explique Philippe Esling. Le temps musical se développe sur de multiples échelles, du son discret qui peut durer une microseconde à plusieurs secondes, jusqu’à une pièce complète. Malgré tout, grâce au Music Information Retrieval, l’apprentissage automatique a considérablement amélioré la modélisation du son. La reconnaissance du genre musical nécessite une analyse temporelle complexe, et la subjectivité du concept sous-jacent – le son perçu – reste encore aujourd’hui ouverte à débats. »

Le machine learning ouvre la voie à de nouvelles solutions comme ces synthétiseursBientôt disponible à cette adresse capables de créer de nouveaux instruments. « Nous travaillons sur l’apprentissage de processus génératifs grâce à des IA, mais toujours dans l’idée que le processus soit contrôlé par l’humain pour améliorer sa créativité, précise Philippe Esling, même si nous avons aussi produit quelques exemples sonores entièrement créés par IA. Nous étudions notamment la capacité de généralisation des algos, pour s’assurer qu’ils soient capables de réagir à de nouvelles données. »

Extraits sonores:

Ecoute et synchronisation

Mais c’est encore l’apprentissage statistique qui est à la base du logiciel Metronaut, une application mobile gratuite qui permet à tout musicien ou chanteur, de tout niveau, de s’accompagner avec une orchestration interactive qui s’adapte à son tempo en temps réel, comme le ferait un vrai musicien. Après 7 années de développement, le logiciel est porté par une start up, Antescofo créée mi-2016, finaliste du concours SXSW du festival du numérique à Austin (Texas). « Notre application permet, pour l’instant, de jouer de la musique classique et bientôt du pop/rock, annonce Arshia Cont, ex chercheur de l’Ircam comme 3 des 4 cofondateurs d’Antescofo. Nous avons déjà 40 000 utilisateurs dans le monde et nous lançons notre application en Chine ce mois-ci. Metronaut est la première plateforme mondiale qui permet de voir concrètement comment la musique est jouée par tout un chacun. » Il comporte un « algo d’écoute » basé sur de l’apprentissage non supervisé probabiliste, comme les algorithmes de reconnaissance vocale type Siri mais en temps réel, en moins de 20 ms.

Metronaut comporte aussi un module qui lui permet d’anticiper pour « finir la phrase ensemble » et s’adapter aux erreurs d’interprétation : cette synchronisation, mise en œuvre grâce à la « sympathie des horloges »Ce phénomène découvert par Huyghens en 1665, explique la synchronisation de pendules., est un énorme avantage pour un musicien amateur. Arshia Cont rappelle d’ailleurs, dans une conférence au Collège de France, que le perfectionnisme algorithmique va à l’encontre de la créativité. C’est, selon lui, un des principaux défauts de l’IA tout comme les data challenges biaisés par le manque de diversité des morceaux sur lesquels sont entrainés les algos.

Représentations du son

Qu’apporte l’IA en termes de créativité musicale ? Dans une autre conférence au Collège de France sur la créativité musicale artificielle, Gérard Assayag, directeur de l’unité Représentations musicales de l’Ircam, définit trois types de créativités : combinatoire quand elle recombine des éléments existants, cas de la plupart des solutions actuelles, basées sur la mémoire et l’imitation ; exploratoire lorsqu’il s’agit d’étudier de nouvelles solutions d’espaces conceptuels connus ; transformante lorsqu’il s’agit de changer l’espace conceptuel. De fait, trouver de nouvelles représentations du son, de nouveaux outils d’écriture de la musique sont parmi les grands enjeux actuels de l’informatique musicale en termes de créativité rappelait le compositeur Philippe Manoury en introduction de son colloque au Collège de France.

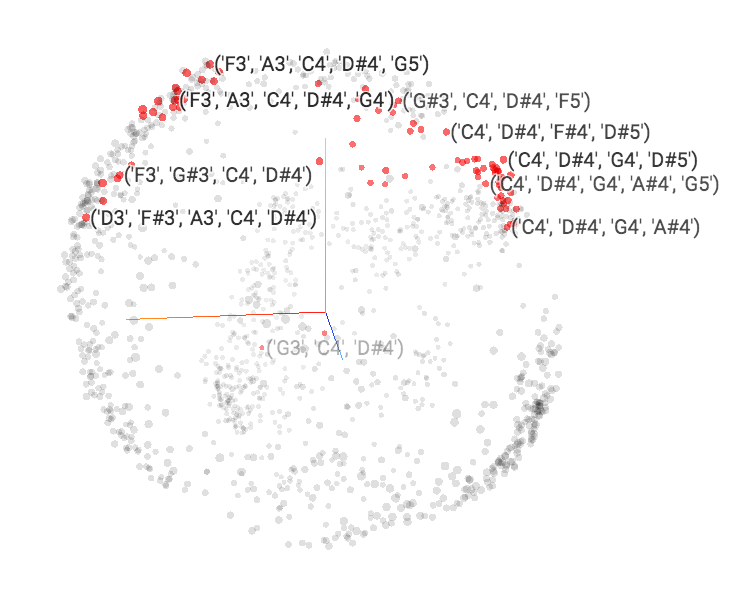

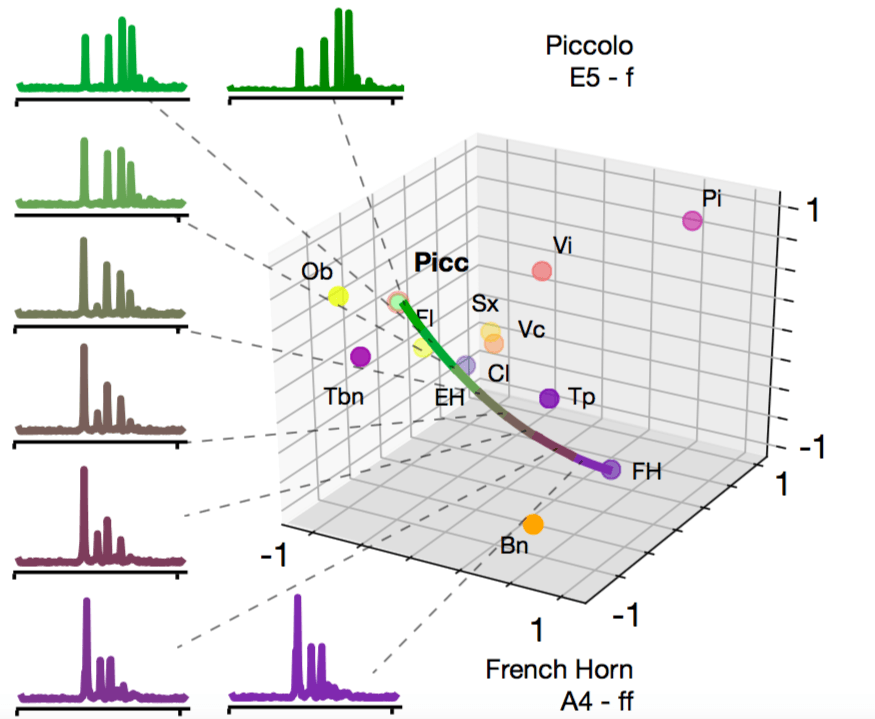

Comment représenter les données sonores ? « Sachant que l’ensemble des notes d’un orchestre pourrait être représenté dans un espace complexe à plusieurs milliers de dimensions, nos recherches sur l’apprentissage de représentations ont toutes pour objectif de trouver l’espace simple et organisé dans lequel transcrire toutes ces informations musicales », précise Philippe Esling. Des doctorants de l’Ircam, comme Mathieu Prang, transforment ainsi, grâce à l’apprentissage automatique, les informations d’une partition symbolique en points dans un espace multidimensionnel (par exemple à 100 dimensions), chaque point étant une note. (Voir ci-dessous)

Composer revient alors à imaginer des chemins dans cet espace. D’autres, comme Axel Chemla, développent un système, à base d’apprentissage non supervisé et d’une représentation des données dans un espace interactif de multiples dimensions. (Voir ci-dessous)

Cela permet de créer des contenus sonores inédits et même un nouvel instrument. Pas de doute, la musique est une science à part entière !