En attendant l’ordinateur quantique universel…

⏱ 4 minL’avènement d’un ordinateur quantique universel n’est pas pour demain, ni même certain. Les industriels misent plutôt sur des processeurs quantiques intermédiaires qui, associés à des supercalculateurs classiques, pourraient bientôt déboucher sur des applications concrètes.

Connaissez-vous Peter Shor ? En 1994, ce mathématicien américain invente un algorithme quantique capable de réaliser la factorisation d’un nombre entier en un temps record. La factorisation consiste à décomposer un nombre en ses facteurs premiers : par exemple, 1001 = 7x11x13. Simple à première vue, cette opération nécessite une puissance de calcul colossale pour de très grands nombres, au point qu’elle n’est plus réalisable en pratique pour nos supercalculateurs classiques. Ce qui est plutôt rassurant dans la mesure où le chiffrement qui protège nos transactions bancaires et nos communications en ligne repose sur la factorisation.

Mais impossible n’est pas quantique ! En s’appuyant sur l’algorithme de Shor, un ordinateur quantique pourrait y arriver en un temps raisonnable, menaçant de fait la sécurité informatique. « En 2021, Google avait estimé qu’un processeur de 20 millions de qubits pourrait factoriser en huit heures un nombre de 2048 bits contre un milliard d’années pour un ordinateur classique », illustre Olivier Ezratty, consultant et auteur, spécialiste des technologies quantiques. Conscient de cet enjeu, l’Institut national américain des normes et de la technologie (NIST) avait lancé dès 2016 un programme dédié à la cryptographie dite “post-quantique”. L’idée étant de créer et standardiser des protocoles de sécurité qui résisteraient aux assauts d’un ordinateur quantique. Cet objectif fait également partie de la stratégie nationale quantique française présentée par le Gouvernement en janvier 2021.

Associer calcul quantique et calcul classique

Mais l’ordinateur quantique universel, doté de plusieurs millions de qubits, n’est pas pour bientôt. De nombreux scientifiques estiment même qu’une telle machine ne verra jamais le jour. En effet, plus on ajoute de qubits dans un processeur, plus ils interagissent, et plus il y a de chance que le système perde sa nature quantique et donc sa puissance de calcul : un phénomène que les physiciens appellent la « décohérence ».

Pour les acteurs comme Pasqal, D-Wave, IBM ou Google, l’objectif à court et moyen terme n’est donc pas de créer un ordinateur quantique universel mais plutôt de construire une machine qui puisse donner un avantage en termes de puissance de calcul pour des applications concrètes, parmi lesquelles le machine learning. « A cet égard, il est important de souligner que malgré les nombreuses annonces de l’écosystème de l’informatique quantique ces dernières années, nous en sommes encore à un point où aucun prototype quantique n’a pu apporter de réel avantage par rapport à une machine classique », souligne Olivier Ezratty. Nous assistons donc à une course sur deux fronts technologiques interdépendants : trouver la meilleure application et concevoir la meilleure architecture matérielle ad hoc.

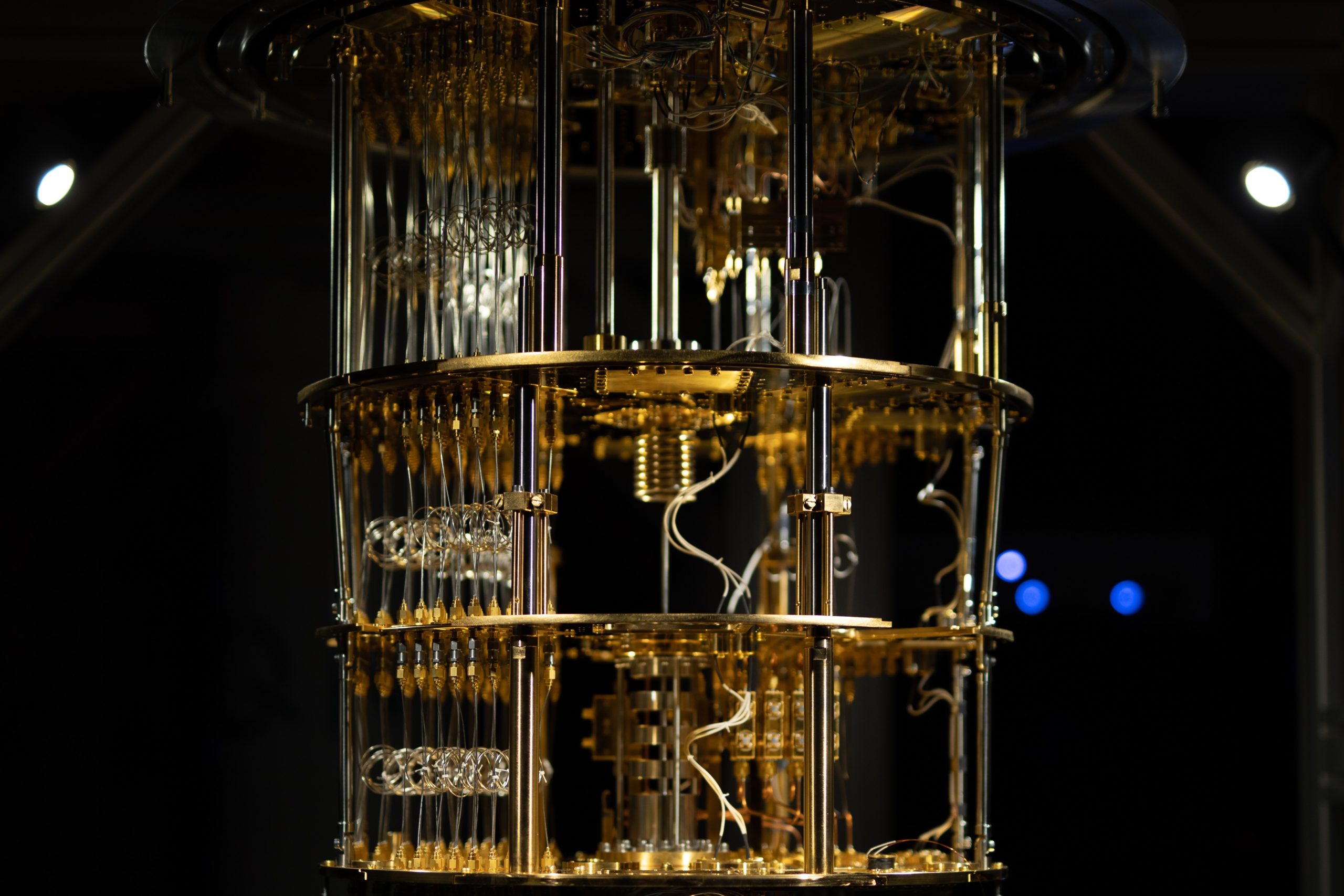

Atos, par exemple, mise sur des ordinateurs hybrides, mêlant supercalculateurs classiques et processeurs quantiques. La firme française a d’ailleurs officialisé en novembre 2022 son partenariat avec la société européenne IQM, spécialisée en informatique quantique, pour créer un système hybride destiné à des applications de simulation. De la même façon, IBM prévoit de créer des data centers mêlant processeurs quantiques et calculateurs haute performance classiques : seule une partie du logiciel serait traitée par des processeurs quantiques, le reste étant pris en charge par les calculateurs classiques.

La décohérence, voilà l’ennemi !

Aujourd’hui, les processeurs quantiques comportent au mieux des centaines de qubits, bientôt des milliers. « Mais le « bruit » qui affecte les qubits et génère des erreurs à chaque opération quantique augmente pour l’instant au gré du nombre de qubits », prévient Olivier Ezratty. Pour augmenter ce nombre, une solution envisagée est de connecter entre eux plusieurs processeurs quantiques. « Pour y arriver, nous devons développer les technologies autour du processeur que l’on appelle les technologies capacitantes », explique Xavier Vasques, directeur technique d’IBM France et distinguished data scientist. Ces technologies ne visent pas à établir entre processeurs quantiques une simple liaison permettant des échanges de données, mais des connexions permettant l’intrication de qubits entre processeurs différents.

Un autre enjeu, toujours lié à la décohérence, est de maintenir ces processeurs dans un état quantique suffisamment longtemps pour exécuter des algorithmes utiles en pratique, comme des réseaux de neurones ou des algorithmes de classification de type SVM (voir notre précédent article). « Depuis 2018, on a multiplié ce temps par dix, passant de 0,1 ms à plus de 1 ms aujourd’hui. Et c’est en constante amélioration », souligne Xavier Vasques. Par ailleurs, la fiabilité des qubits a augmenté ces dernières années : « Les recherches dans ce domaine ont porté leurs fruits, puisqu’en moins de quatre ans, on est passé d’un taux d’erreur de 1/10 à près de 1/1000, pour une porte logique à deux qubits. »

La redondance pour corriger les erreurs

Mais cela ne suffit pas. En effet, des erreurs liées à la décohérence surviennent au moment du stockage de l’information quantique ou de l’exécution d’un calcul. Il est donc important de les corriger en temps réel. Les scientifiques misent pour cela sur les “codes correcteurs d’erreur”. Pour faire simple, cette approche consiste à dupliquer l’information quantique de chaque qubit dit « logique » – qui participe effectivement au calcul et stocke l’information à protéger – sur des qubits dits « auxiliaires », qui ne participent pas directement au calcul mais permettent de contrôler l’état du qubit logique et de corriger les erreurs.

Enfin, un aspect primordial dans la mise en place d’une machine quantique vraiment utile est son accessibilité par une communauté scientifique la plus large possible. Tous les grands groupes ont donc créé leur propre écosystème logiciel pour permettre au plus grand nombre de chercheurs de créer des algorithmes. Atos propose ainsi un outil de développement d’algorithmes quantiques appelé MyQLM qui peut être installé sur un simple ordinateur personnel. De son côté, Google propose une suite logicielle baptisée Cirq qui permet aux développeurs de coder en Python – le langage informatique le plus utilisé en machine learning – sans aucune connaissance préalable en physique quantique. IBM propose une solution similaire baptisée Qiskit, permettant à l’utilisateur de coder sans même s’apercevoir qu’il mobilise en partie un processeur quantique. Les progrès du matériel et du logiciel suivent donc une trajectoire similaire, ils devraient dans les prochaines années atteindre une maturité autorisant les premières applications intéressantes.

Gautier Cariou

Légende photo : Vue partielle sur un accélérateur quantique du finlandais IQM Quantum computers. © IQM.