Les images tombées du ciel ont lancé l’agriculture de précision

⏱ 5 minLa première forme d’information utile pour numériser l’agriculture vient du ciel. Des images toujours plus précises et fréquentes, issues de satellites, ont permis le décollage d’une « agriculture de précision », qui vise à choyer les champs à l’échelle des mètres carrés.

L’agriculture est entrée dans l’ère numérique. L’ordinateur a fait son apparition dans les fermes depuis un certain temps, les exploitants utilisent des logiciels et des services en ligne de plus en plus sophistiqués, qui se nourrissent de données issues de fournisseurs patentés ou de toutes sortes de capteurs statiques ou embarqués, des robots arpentent certains champs… Bien sûr, ce mouvement n’affecte pas à la même vitesse les nations industrialisées et les pays émergents, les grandes exploitations et les petites. Et certains types de cultures (céréales, vigne…), pour des raisons techniques et/ou économiques, se prêtent mieux au jeu que d’autres. Mais le mouvement est lancé…

Les images tombées du ciel constituent la plus importante source de données pouvant intéresser le monde agricole. Elles sont fournies depuis les années 1970 par des satellites, et depuis peu également par des drones. C’est en 1972 que la NASA lance Landsat-1, le premier satellite d’observation de la terre à des fins civiles. La France, quant à elle, aura son Spot-1 à partir de 1986. On parle alors de télédétection : dans un premier temps, les images sont de qualité limitée, rares et chères, l’agriculture ne bénéficie que d’informations régionales, au mieux par exemple d’estimations sur les rendements et récoltes à venir, à l’échelle nationale, régionale ou du terroir.

La bonne dose au bon endroit, au bon moment

Ces images s’améliorent et se démocratisent au point d’accélérer l’émergence d’une véritable « agriculture de précision ». Celle-ci repose sur un premier principe d’une grande évidence : plutôt que de traiter (eau, engrais, pesticides…) une parcelle de manière uniforme, on peut apporter à chaque zone ce dont elle a besoin, quand elle en a besoin. Avec à la clé des économies, moins de gâchis, moins de chimie dans la nature. La « modulation intra-parcellaire » est facilitée depuis l’apparition de dispositifs de géolocalisation de précision (GPS RTK), qui permettent aujourd’hui de contrôler en temps réel, en fonction d’une cartographie préalablement enregistrée, la quantité d’intrant délivrée par un épandeur d’engrais ou un pulvérisateur de produits phytosanitaires, équipé en conséquence.

« Aujourd’hui, la première source d’imagerie pour l’agriculture de précision, en Europe, ce sont les satellites Sentinel de l’ESA (Agence spatiale européenne), dont les images sont gratuites, explique Éric Ceschia, directeur de recherches Inra au Cesbio (Centre d’études spatiales de la biosphère), une unité mixte de recherche (CNRS, université Toulouse-III Paul-Sabatier, Cnes, IRD, Inra). Un exploitant peut obtenir tous les cinq jours une nouvelle image de ses champs, avec une résolution de dix mètres, issue des Sentinel 2-A et 2-B (lancés en 2015 et 2017). » Il s’agit d’images multispectrales (13 bandes de fréquences, du visible à l’infrarouge court, 2400 nm). Ce flux de données représente 7 To par jour.

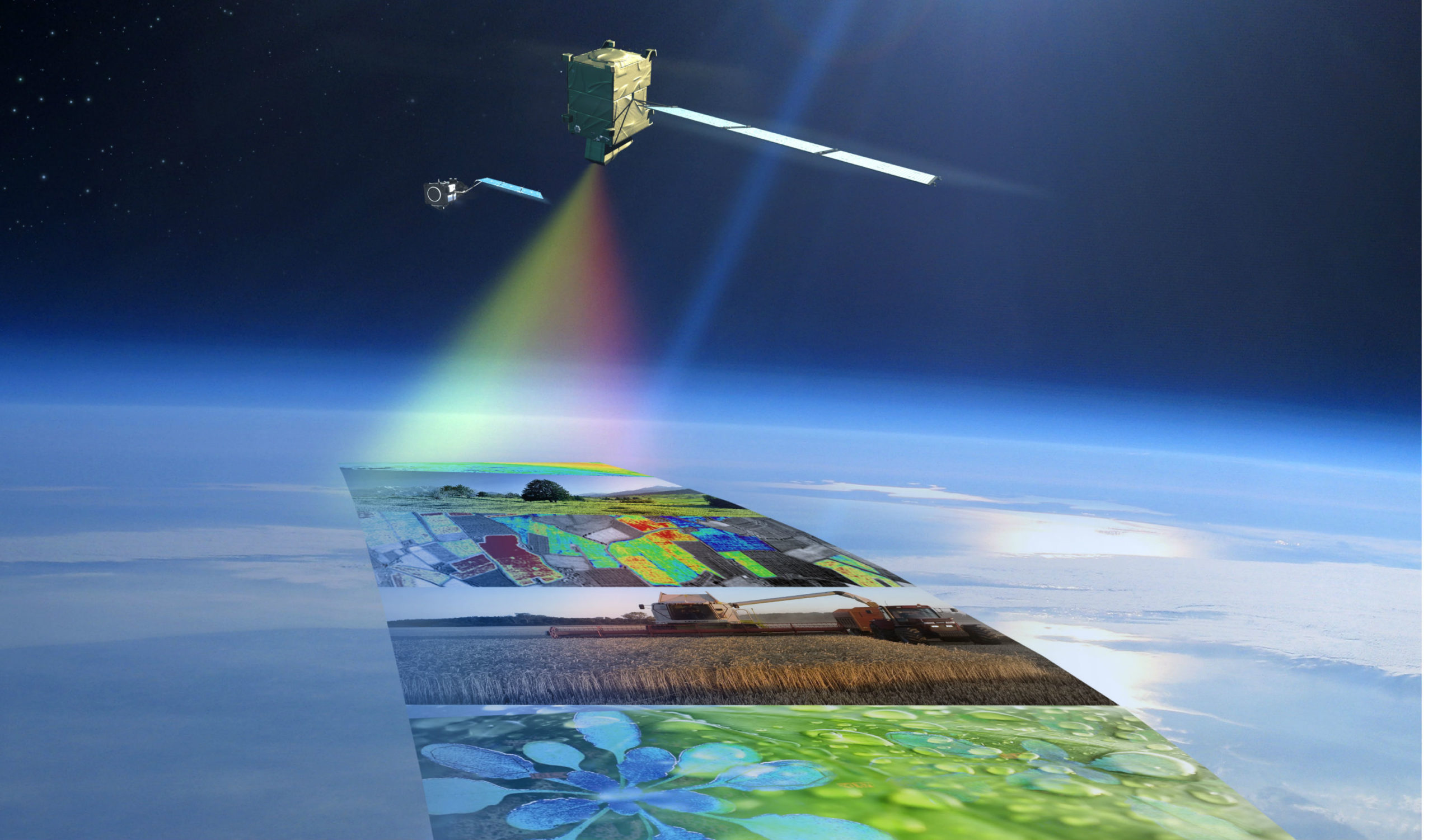

Les deux satellites Sentinel 2, lancés par l’ESA en 2015 et 2017, fournissent tous les 5 jours des images optiques multispectrales (13 bandes, du visible à l’infrarouge court) d’une résolution de 10 mètres contenant de précieuses données pour l’agriculture. ©ESA

« Mieux, poursuit Éric Ceschia, à côté de ces images optiques, les Sentinel 1-A et 1-B fournissent des images radar avec une résolution et une périodicité semblables. Elles n’apportent pas les mêmes informations, mais quand il y a des nuages, elles compensent l’absence d’images optiques, en apportant par exemple une indication sur les humidités de surface ou la biomasse. D’autres satellites apporteront demain des données complémentaires. Ainsi, à partir de 2023, le satellite Flex (Fluorescence Explorer) de l’ESA doit capter la faible fluorescence infrarouge produite par l’activité de photosynthèse des cultures. Et dans le cadre d’une coopération franco-indienne, Trishna doit, sans doute dans cinq ans, fournir des images dans l’infrarouge thermique à partir desquelles on obtiendra une estimation plus fiable de la réserve utile en eau du sol et du stress hydrique des plantes. »

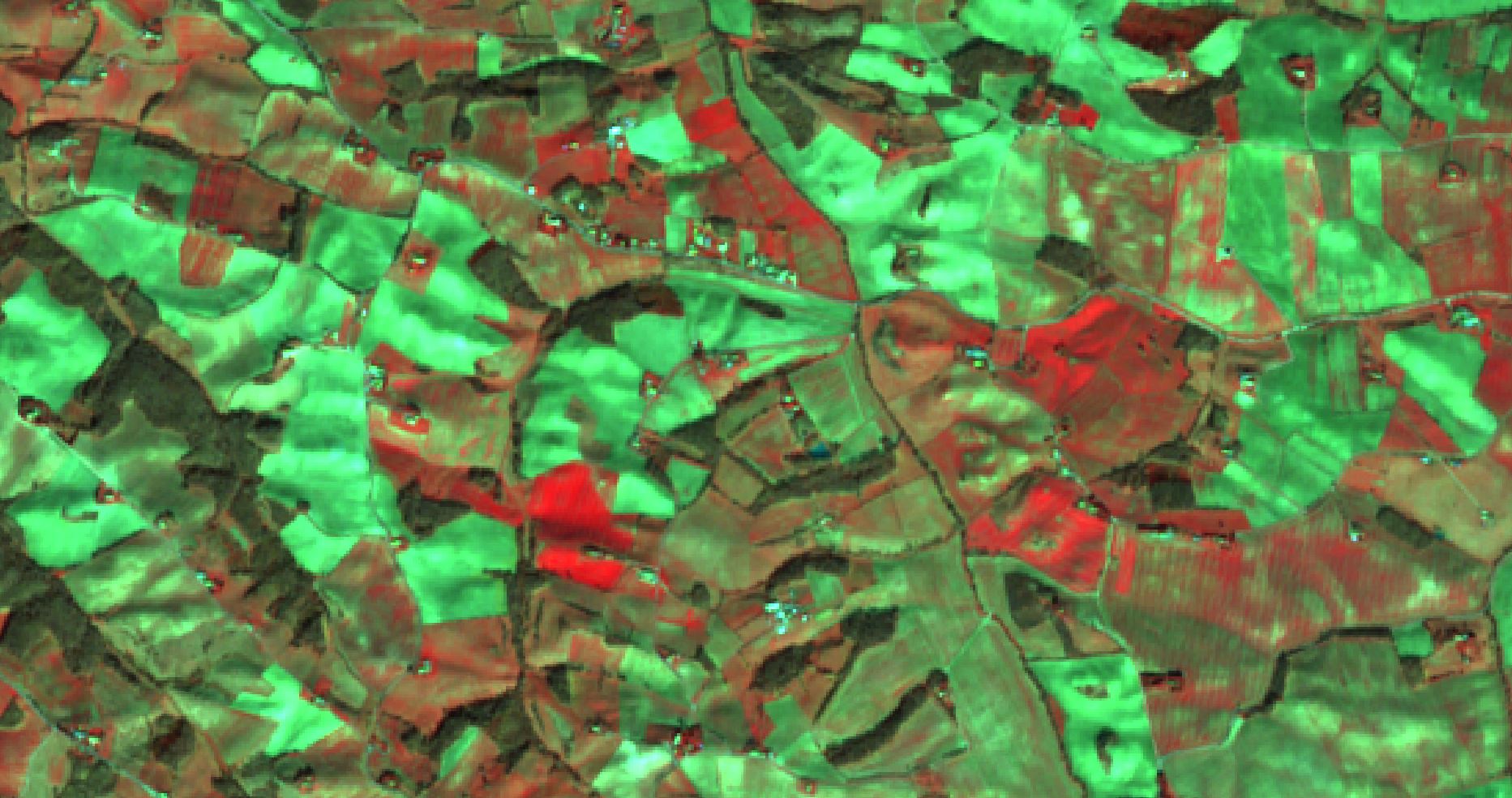

Les deux satellites radar Sentinel 1, lancés par l’ESA en 2014 et 2016, fournissent même par temps couvert des images d’une résolution de 10 mètres contenant de précieuses données pour l’agriculture (humidité de surface, biomasse). ©ESA

Faire parler les images

Il ne suffit pas de disposer d’images fréquentes et de bonne qualité, encore faut-il savoir les faire parler. À peine tombées du ciel, des algorithmes les prennent en charge tout d’abord pour les corriger, car l’atmosphère n’est pas totalement transparente. Les satellites Sentinel 2 se donnent la peine de consacrer trois de leurs canaux (sur 13) à la détection spécifique des cirrus (nuages ténus d’altitude), de la vapeur d’eau et des aérosols, ce qui permet à des algorithmes de corriger les perturbations qu’ils introduisent dans les images. Ensuite, il faut interpréter, et c’est plus compliqué, car il faut tenir compte de multiples paramètres comme, pour commencer, l’éclairement des lieux.

À partir des valeurs mesurant la lumière acquise dans chaque bande de fréquence pour chaque pixel, les algorithmes calculent pour commencer des« indices ». Le plus connu est le NDVI (Normalized Difference Vegetation Index) ou « indice de végétation par différence normalisé ». Il évalue la quantité de végétation et son état de santé. Cet indice ne varie pas selon l’éclairement global, sa valeur est comprise entre -1 et +1, les surfaces couvertes de végétaux affichant des valeurs positives, typiquement comprises entre 0,1 et 0,7. On obtient de la même manière un « indice de stress hydrique » à l’aide d’un calcul portant sur les mesures dans l’infrarouge moyen et le proche infrarouge. C’est surtout en confrontant l’information issue des satellites à un modèle de croissance de la plante concernée que l’on peut espérer en tirer le maximum. Au final, les algorithmes actuels sont capables d’évaluer la croissance des cultures, de détecter le stress hydrique ou encore d’estimer des besoins en irrigation, en azote ou des bilans carbone des cultures. Déceler des pathologies s’avère plus difficile, c’est un sujet encore jeune.

Cette image issue du satellite Sentinel 2 et traitée en fausses couleurs montre une portion du territoire de la commune de Lézat-sur-Lèze, en Ariège. Le vert indique des sols nus (labours, etc.) et le rouge des cultures plus ou moins avancées (colza, blé, prairie…). Sur les parcelles de colza (les plus rouges), on remarque des zones mal ou non levées. ©Esa.

Satellite et drone

Depuis peu, un nouveau type d’imagerie est apparu, avec l’émergence des drones. « Ils apportent une meilleure résolution (des millimètres plutôt que des mètres), des images même sous les nuages, et plus de souplesse : ils volent où et quand c’est utile, explique Véronique Bellon-Maurel. Ingénieur agronome spécialiste des capteurs optiques à l’Institut national de recherche en sciences et technologies pour l’environnement et l’agriculture (Irstea) de Montpellier, elle dirige l’institut Convergences Agriculture Numérique (#DigitAg), qui regroupe des chercheurs de 17 partenaires dont l’Irstea, l’Inra, le Cirad et l’Inria. Mais il y a un coût, à l’heure où certaines images satellitaires sont gratuites ou presque. De plus, l’usage des drones est limité par la législation, puisqu’ils doivent voler à vue, et de jour. Demain, ils pourraient s’imposer s’ils savaient faire des choses inaccessibles au satellite : détecter en temps réel des bio-agresseurs ou maladies par vision artificielle, ou faire des prélèvements à la volée. Mais c’est une autre histoire. »

Pierre Vandeginste

Illustration à la une. Le satellite Flex (Fluorescence Explorer) que l’ESA doit lancer en 2023 mesurera la fluorescence émise par les plantes, un indice de leur activité photosynthétique. ©ESA